英特尔:64核第五代至强芯片在AI基准测试上比AMD下一代128核EPYC不相上下

AI基准测试是客户进行芯片选型的重要评估手段。随着英特尔和AMD在CPU上运行的AI工作负载领域争夺领导地位,AI基准之战正在升温。

为了证明自己的产品在AI工作负载的表现,不管是英特尔还是AMD纷纷亮出自己在相关基准测试方面的结果。

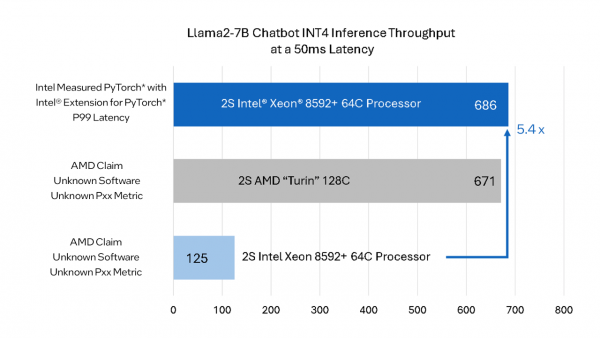

前段时间,在COMPUTEX上,AMD的Zen 5 EPYC Turin在人工智能工作负载上比英特尔至强芯片快5.4倍。

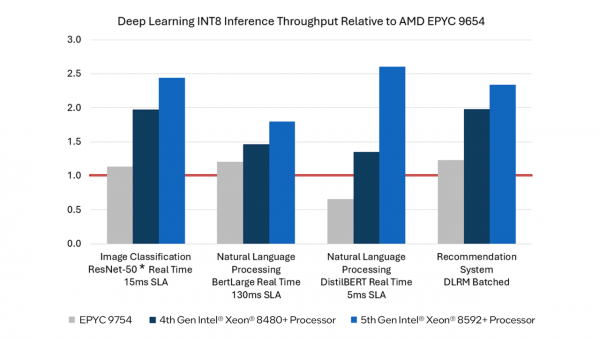

但是近日,英特尔表示,正在上市的第五代至强芯片比AMD即将于2024年下半年上市的3nm EPYC Turin处理器更快。英特尔表示,AMD的基准对Xeon性能的描述“不准确”,并分享了自己的基准来反驳AMD的说法。

英特尔自己的内部测试结果显示,至强的性能表现并不逊色,比AMD的基准测试快5.4倍,这样比较起来,至强比EPYC Turin并不弱,这使得目前正在发售的64核Xeon相对于AMD未来的128核机型具有优势——这的确是一个相当令人印象深刻的说法,而且在性能上也有很大的变化。

英特尔表示,AMD没有透露其用于基准测试的软件细节,也没有透露测试所需的SLA。AMD的测试结果与其内部广泛使用的开源软件(Intel Extension for PyTorch)并不匹配。

如果该基准测试代表真实性能,那么可能存在的差异是英特尔对AMX(高级矩阵扩展)数学扩展的支持。这些矩阵数学函数极大地提高了AI工作负载的性能,目前还不清楚AMD在测试英特尔芯片时是否采用了AMX。值得注意的是,AMX支持BF16/INT8,因此软件引擎通常会将INT4权重转换为更大的数据类型,以驱动AMX引擎。AMD的当前一代芯片不支持原生矩阵运算,目前还不清楚Turin是否也支持。

所以测试结果之所以出现这样的巨大差异,还是在软件调优。英特尔的硬件可利用软件框架和工具包进行加速,并获得出色的大模型推理性能,其中包括PyTorch和英特尔 PyTorch扩展包、OpenVINO工具包、DeepSpeed、Hugging Face库和vLLM。

来源:至顶网计算频道

好文章,需要你的鼓励

诺奖得主辛顿:20年内超级智能会比我们更聪明,人类想生存只能成为被AI照顾的“婴儿”

2024年10月8日,Geoffrey Hinton(杰弗里·辛顿)因在人工神经网络领域的开创性工作获得诺贝尔物理学奖。

NVIDIA推出ChronoEdit:让AI图像编辑拥有物理常识的革命性技术

NVIDIA联合多伦多大学开发的ChronoEdit系统通过将图像编辑重新定义为视频生成问题,让AI具备了物理常识。该系统引入时间推理机制,能够想象编辑的完整变化过程,确保结果符合物理规律。在专业测试中,ChronoEdit超越了所有开源竞争对手,特别在需要物理一致性的场景中表现突出,为自动驾驶、机器人等领域的应用提供了重要技术突破。

AI推理新突破:乔治亚大学团队让大型语言模型学会“精打细算“的思考方式

这项研究提出了MITS框架,使用信息论中的点互信息指导AI推理过程,解决了传统树搜索方法计算成本高、评估标准模糊的问题。通过动态采样和加权投票机制,MITS在多个推理数据集上显著超越现有方法,同时保持高效的计算性能,为AI推理技术开辟了新方向。

亚马逊云科技的“AI毛坯房”,能解决游戏出海80%需求吗?

TE Connectivity 2025财年第四季度销售额增长17%,业绩高于预期销售额、经营利润率及现金流均创下全年新高

月之暗面AI模型注意力机制新突破:让AI更聪明更快的"记忆管理术"

Sora 2应用向美国等地用户全面开放,无需邀请码

Perplexity与Getty Images签署多年许可协议,应对版权争议

AWS业绩超华尔街预期,云基础设施需求持续旺盛

德州核电数据中心合作项目启动,计划2031年投产

高通骁龙X Elite和X Plus笔记本芯片详解

众智有为 致敬同路人|四川赛狄:从“碰撞”到“同路”,一位华为同路人的蜕变之旅

亚马逊股价大涨,AWS云业务增长加速

Microsoft 365 商业客户无处躲避 Copilot 功能扩张

Google Chrome推出AI操作按钮对抗AI浏览器