英特尔Gaudi 2D AI加速器为DeepSeek Janus Pro模型提供加速

近日,DeepSeek发布Janus Pro模型,其超强性能和高精度引起业界关注。英特尔® Gaudi 2D AI加速器现已针对该模型进行优化,这使得AI开发者能够以更低成本、更高效率实现复杂任务的部署与优化,有效满足行业应用对于推理算力的需求,为AI应用的落地和规模化发展提供强有力的支持。

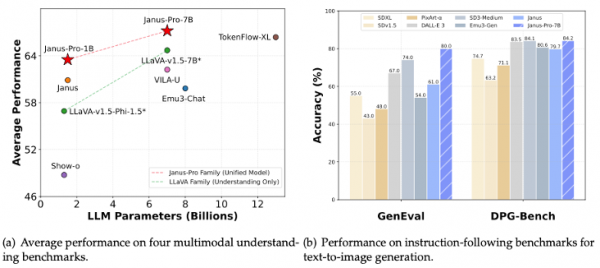

作为一款创新性的AIGC模型,DeepSeek Janus模型集成了多模态理解和生成功能。该模型首次采用统一的Transformer架构,突破了传统AIGC模型依赖多路径视觉编码的限制,实现了理解与生成任务的一体化支持。在此基础上,Janus Pro通过优化训练策略和扩展模型规模,显著提升了文生图等功能的性能与稳定性,并提供了10亿参数和70亿参数两个版本,在性能与精度上展现了较强的竞争力。

在Janus Pro统一的Transformer架构下,文生图模型的吞吐量高低已经从依赖加速器的高算力向充分利用HBM内存高带宽和大容量转换。英特尔® Gaudi 2D凭借 2.45TB/秒的高带宽和 96GB HBM大容量内存,为Janus Pro模型提供了强大的计算支持,使其在生图批处理任务中,随着批量大小(Batch Size)的增加,吞吐性能得到显著提升,大幅缩短任务处理时间。

与此同时,结合英特尔Optimum-Habana框架的优化,英特尔® Gaudi 2D显著提升了文生图任务的吞吐性能和推理效率,仅需约10秒即可生成16张高质量的图片,性能表现卓越。而且,开发者仅需调整数行代码,即可实现这一结果,极大降低了开发门槛和迁移成本,为 AI 应用的高效部署提供便利。

此外,DeepSeek的蒸馏模型在至强和Gaudi平台上也得到了支持,能够为客户创造更好的总体拥有成本(TCO),推动AI的普惠。

一直以来,英特尔始终秉承开放的态度,并通过软硬件相结合的方式推动AI应用落地。目前,英特尔丰富的AI产品组合,包括英特尔®至强®处理器、英特尔®酷睿™ Ultra处理器和英特尔锐炫™显卡等,已经针对业界超过500个开源AI模型提供支持,广泛涵盖DeepSeek、Llama 3.1和通义千问等。同时,英特尔深耕开放生态,不仅以开放生态系统软件实现针对性优化,也通过打造企业AI开放平台(OPEA)为这些模型提供支持。

好文章,需要你的鼓励

无需Linux即可运行自由开源软件

本文介绍了如何在Windows和macOS等主流操作系统上使用免费开源软件,无需更换操作系统即可摆脱付费订阅。文章推荐了Ninite等工具来安装免费软件,并详细介绍了Firefox、Thunderbird、LibreOffice、VLC等优秀的开源替代方案。作者强调虽然学习新工具需要时间投入,但从长远来看,使用不依赖订阅模式的替代工具将带来巨大回报。

港大团队让AI学会动态空间推理:像人类一样理解物体在三维空间中的运动变化

香港大学和腾讯联合研究团队开发DSR Suite框架,首次让AI掌握动态空间推理能力。该技术通过自动化流水线从真实世界视频提取三维几何信息,构建了包含5万个训练样本的DSR-Train数据集和1484个评估样本的DSR-Bench基准。核心创新GSM几何选择模块能根据问题精准提取相关几何知识,避免信息过载。实验显示新方法在动态空间推理任务上达到58.9%准确率,超越最强对比模型20个百分点,为机器人导航、自动驾驶等应用奠定重要基础。

超越 SEO:AI 引擎优化如何改变在线可见性格局

随着生成式人工智能系统提供直接答案而非链接列表,传统搜索引擎优化正面临重大变革。谷歌AI概述功能已覆盖约30%的美国搜索,导致网站点击率大幅下降。专家预测,到2030年AI将占B2B软件研究的70%以上。AI引擎更重视结构化数据、实体识别和权威性,而非传统的关键词和反向链接。营销人员需要采用实体权威工程等新策略来优化AI可见性。

南京大学团队推出T2AV-Compass评测基准:让AI生成视频与音频完美匹配的“统一考场“

南京大学团队发布T2AV-Compass,这是全球首个文本到音视频生成模型的综合评测基准。研究构建了500个复杂测试场景和双重评估体系,发现当前AI模型存在"音频真实感瓶颈"—视频质量优秀但音频效果较差。该基准为AI视频生成领域提供统一评估标准,指出了未来技术改进的关键方向。