英伟达公布截至2027年的GPU与互联技术路线图

在计算、网络和图形技术发展史上,英伟达曾经先后做出过卓越而独特的贡献。但如今的英伟达正掌握着前所未有的巨量资金,并凭借其自身架构、工程与供应链优势而在生成式AI市场上处于领先地位,因此能够随心所欲地制定几乎任何符合其发展规划的技术路线图。

其实从本世纪初开始,英伟达就已经成为市场上极为成功的创新厂商,单凭数据中心计算领域之外的消费级市场已经赚得盆满钵满。但高性能计算(HPC)研究人员还是成功将英伟达推向了加速计算领域,而后AI研究人员又凭借GPU计算创造出一个全新市场。从历史角度来看,这一市场已经酝酿了四十年,期待以合理的价格对超大规模数据执行海量计算,从而真正将愈发强大的思考机器带入每一个人的日常生活。

这不禁让我们想到Danny Hillis、Marvin Minksy和Sheryl Handler等行业先驱,他们早在上世纪80年代就曾尝试制造这样的机器,创立了Thinking Machines以推动AI处理,希望在传统的HPC模拟与建模应用之外开辟出新的智能空间。还有Yann LeCun,他成功在AT&T贝尔实验室创造出卷积神经网络。但当时的他们既没有充足的数据,也不具备相应的计算能力来开发如今我们所熟知的现代AI。当时的黄仁勋还在存储芯片制造商LSI Logic公司担任董事,随后成为AMD的CPU设计师。而就在Thinking Machines于90年代初陷入困境并最终破产之后,黄仁勋在圣何塞高速公路旁的一家Denny’s餐厅里遇见了Chris Malachowsky和Curtis Priem,三人最终联合创立了英伟达。意识到研究领域及超大规模社区中蕴藏着新兴的AI技术机遇,英伟达公司决定构建系统软件及底层大规模并行硬件,希望能让这场自计算技术发展之初就伴随而生的AI革命之梦落地生根、开花结果。

AI可以说是人们一直以来所追求的终极计算形态,也代表着我们所期待的发展奇点。如果其他星球上也有生命,那这些生命也一定会进化至拥有大规模毁灭性武器、并创造出AI技术的水平,而且二者很可能是相辅相成、互为因果。也正是这道技术门槛,包括对这两项技术的处理方式,将决定一个生物种群能否在大规模灭绝事件当中幸存下来。

前面聊的这些似乎跟本文讨论芯片制造商路线图的主旨有些偏离,但并非如此,我们正生活在一个前所未见的有趣时代。

在本届于中国台北召开的年度Computex贸易展主题演讲当中,英伟达公司联合创始人兼CEO黄仁勋再次强调将生成式AI革命,也就是他所谓的第二次工业革命作为时代背景,希望一窥AI、特别是英伟达硬件的未来。我们也由此了解到英伟达的GPU与互连技术路线图,而且据称这些内容跟黄仁勋以往的演讲一样,都是在最后一刻才被确定下来。

技术革命已经不可避免

黄仁勋在演讲中提醒我们,生成式AI的关键在于规模,并强调2022年底的ChatGPT时刻完全是技术和经济双重驱动下的必然结果。具体来讲,要想实现ChatGPT这样的突破性时刻,首先要求GPU性能实现大幅提升,之后要在此基础上实现庞大的GPU产能。英伟达在性能层面确实取得了成功,而性能是决定AI训练与推理可行性的前提。更重要的是,强大的性能显著降低了大语言模型在生成响应token时所耗费的能耗。下面我们具体来看:

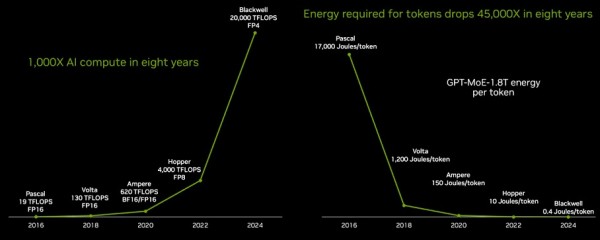

从“Pascal”P100 GPU到“Blackwell”B100 GPU之间相隔了八年,期间GPU性能提高了1053倍。最新的B100 GPU将于今年晚些时候正式出货,并持续供应至2025年。(图表上展示的数字为1000倍,但实际并不准确。)

其中部分性能提升是通过降低浮点精度实现的——具体降幅为四分之三,即由Pascal P100、Volta V100和Ampere A100 GPU中的FP16格式转变为Blackwell B100中使用的FP4格式。如果忽略精度降低的部分,那么实际性能提升将只有263倍,但精度降低并不会对大语言模型的性能造成显著影响,而这要归功于数据格式、软件处理以及硬件层面的一系列数学“魔法”。另外这里要强调,相较于这八年以来CPU每代核心性能提升10%到15%、核心数量增加25%到30%的成绩,GPU的发展已经相当值得赞叹。毕竟如果按两年为一个升级周期计算,这八年间CPU的吞吐量仅仅增长了4到5倍。

从上图中可以看到,单位工作负载的功耗降低成为另外一项关键指标。因为如果没有足够的能源支撑系统,自然也就没有实用层面的价值。单个token的电力成本必须降低,也就是说大语言模型在生成每个token时所消耗电量的降幅,必须要比性能提升的速度更快。

在主题演讲中,黄仁勋公布了更加深入的背景信息。在Pascal P100 GPU上生成一个token需要1.7万焦耳,大致相当于将两只灯泡点亮两天的耗电量。而平均每个单词大约对应3个token。所以如果要生成大量单词,就相当于要点亮许许多多个灯泡!现在大家应该理解为什么八年之前,我们根本不可能在现实任务上拥有运行良好的大语言模型了。下面来看由1.8万亿参数、8万亿token数据驱动并训练的GPT-4混合专家大模型的当前运行功率:

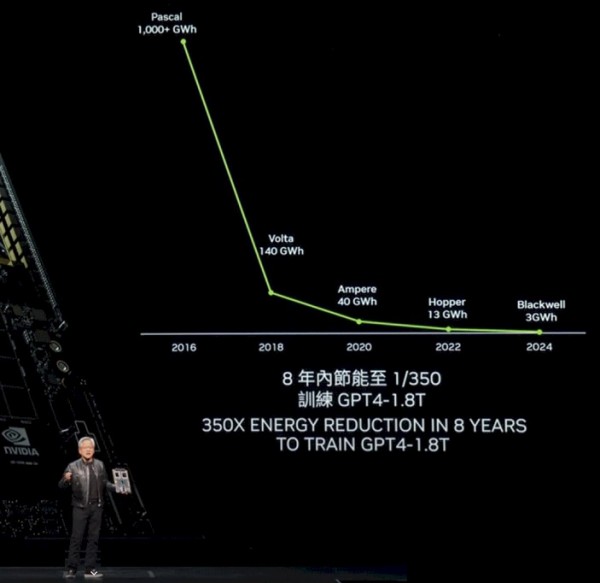

如果使用P100 GPU集群,那么这样的模型运转起来需要超过1000千兆瓦时,耗电量相当恐怖。

但黄仁勋解释道,在Blackwell GPU的帮助下,企业客户能够在约10000张GPU上用约十天时间就训练出这套GPT-4 1.8T混合专家模型。

而如果AI研究人员和英伟达没有发现降低精度的秘密,那么在这8年时间里,性能提升只能达到250倍左右。

另外,降低能源成本跟降低系统成本还不一样。在传统摩尔定律的末期,这两者的实现难度已经变得越来越高。所谓摩尔定律,是指每18到24个月晶体管的尺寸会进一步缩小,因此令芯片成本更低、性能更强。现如今,计算复合体的尺寸已经逼近光刻工艺的极限,单个晶体管的制造成本也变得越来越昂贵,自然拉动计算设备的价格水涨船高。而且除了先进封装技术之外,HBM内存也成为成本结构中的又一个大头。

以SXM版本的各代GPU(注意,不是PCI-E版本)为例,P100在初发布时的成本约为5000美元,V100成本约为10000美元,A100来到约1.5万美元,而H100的成本则在2.5万到3万美元之间。最新一代B100的成本预计将在3.5万至4万美元之间——黄仁勋本人曾在今年早些时候接受采访时,大致提到过Blackwell的这一价格区间。

黄仁勋并没有在演讲当中具体公布,各代产品需要多少张GPU来训练GPT-4 1.8T混合专家模型,包括这些GPU在运行期间产生的电力成本。但我们根据他提出的大约需要1万张B100、耗时10天训练GPT-4 1.8T混合专家模型的结论,推衍制作出了下面这份电子表格。我们一起来看:

在过去8年当中,GPU的价格上涨了7.5倍,但性能却提高了1000多倍。因此现在使用Blackwell系统能在十天左右时间里训练出GPT-4这样拥有1.8万亿参数的大语言模型,但短短两年前Hopper刚刚亮相之时,想在几个月时间里训练出拥有数千亿参数的模型都还十分困难。另外前后对比,两年之间GPU集群的系统成本和运行电力成本基本相当。(GPU约占AI训练系统成本的一半,因此采购1万张Blackwell GPU系统大约需要8亿美元,而运行10天的电费约为54万美元。如果减少GPU采购量,那么单位时间之内的电费当然可以相应降低,但总训练时长也会随之增加,同样会令成本继续上升。)

所以在客户来看,GPU升级就成一块既没便宜可占、又没办法直接放弃的“鸡肋”。

其实英伟达也面临着类似的难题。黄仁勋在本届Computex主题演讲中坦言,哪怕打造出了Hopper H100 GPU平台这款“有史以来最成功的数据中心处理器”,英伟达也一刻都不能停止前进的脚步。

旁注:我们不妨将Hopper/Blackwell的投资周期跟六十年前的IBM System/360进行一番比较。我们之前曾经解释过,IBM当时也押下了公司历史上规模最大的赌注。1961年,IBM着手推动的“下一产品线”研发在那整个十年之间共烧掉了超过50亿美元,而当时蓝色巨人一年的总收入也只有22亿美元。IBM之所以成为华尔街第一家蓝筹公司,就是因为其投入整整两年的收入和未来二十年的利润来开发System/360。没错,最终成果仍有缺憾和不足,但还是彻底改变了企业数据处理的基本思路。当时按IBM最乐观的想法,System/360应该能在60年代末为其带来600亿美元的销售额(以换算之后的2019年美元购买力计算),但实际销售额达到惊人的1390亿美元,利润则在520亿美元左右。

英伟达无疑为数据中心计算的第二阶段掀起了更大的波澜。而这位新时代下的最大赢家,会不会成为绿筹企业中的典范?

一切抗拒都虚弱无力

无论是英伟达还是其竞争对手、包括客户,都无法抗拒AI掀起的巨大引力以及潜在利润与生产力增长的可能性。而且如今的生成式AI已经不是在用耳畔低语的方式“蛊惑人心”,而是站在房顶上冲着全世界“疯狂布道”。

因此,英伟达必将加快步伐、突破极限。凭借手上250亿美元的现金流和年内预计超1000亿美元的销售额,还有未来大概率能够实现的500亿美元新增资金储备,相信英伟达能够引领我们开疆拓土、拥抱未来。

“在这个令人难以置信的增长时期,我们希望继续坚守性能提升路线,不断降低训练成本和推理成本,并努力扩展AI功能以供更多企业使用。性能水平越高,成本的下降幅度也就越大。”

而从我们前面整理的表格来看,情况的确如此。

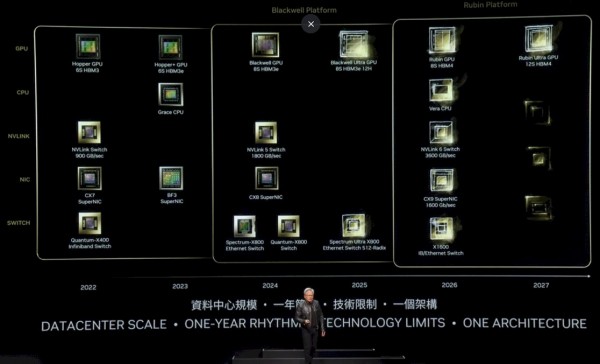

以下是更新之后的英伟达平台路线图:

可能不太好理解,让我们具体分析一番。

从Hopper一代开始,最早的H100发布于2022年,采用六层HBM3内存并配备一个拥有900 GB/秒端口的NVSwitch以实现互连,同时采用400 Gb/秒端口的Quantum X400(之前被称为Quantum-2)与ConnectX-7网络接口卡。到2023年的H200,则升级为具有更高容量和带宽的六层堆叠HBM3E内存,得以提高H200封装中底层H100 GPU的实际性能。其时BluleField 3 NIC也已经问世,为网络接口卡添加了Arm核心以执行部分附加工作。

到2024年,Blackwell GPU当然会采用8层堆叠HBM3e内存,同时辅以1.8 TB/秒端口的NVSwitch 5、800 Gb/秒的ConnectX-8,以及采用800 GB/秒端口的Spectrum-X800及Quantum-X800交换芯片。

而从现在的路线图中可以看到,2025年B200(即图中的Blackwell Ultra)将采用高度为12层裸片的8层堆叠HBM3e内存。据推测,B100中的堆叠高度为8层裸片,换算下来Blackwell Ultra上的HBM内存容量至少会增加50%,实际可能更多,具体取决于所使用DRAM的容量。此外,该HBM3e内存的时钟速率可能也会更高。英伟达对其Blackwell系列的内存容量一直含糊其辞,但从今年3月Blackwell发布会上的情况来看,B100估计将配备192 GB内存和8 TB/秒带宽。而对于未来的Blackwell Ultra,相信内存速率将进一步提升,实际数字甚至可能达到288 GB容量加9.6 TB/秒带宽。

我们还推测,Ultra版本在流式多处理器(SM)方面也将有所改进,因此其性能应该会略高于前代非Ultra产品。

英伟达还将在2025年推出基线性能更强的Spectrum-X800以太网交换芯片,可能配备6个ASIC来建立无阻塞架构,借助这种主流设计思路将总带宽再翻一倍。这意味着单一交换芯片所能支持的端口数量,或者每端口所能提供的带宽也将随之倍增。

2026年,我们将迎来英伟达的“Rubin”R100 GPU,这款产品在去年公布的路线图中被称为X100。当时我们就猜测,所谓X只是个临时占位符,并没有确切的含义。事实证明的确如此。Rubin GPU将采用HBM4内存并配合8层堆叠架构,每一层包含12个DRAM;而2027年的Rubin Ultra GPU将把HBM4内存堆叠数量提升至10层以上,甚至可能更高(但路线图中并未展示)。

2026年还将有“Vera”CPU问世。作为“Grace”CPU的继任产品,Vera代表英伟达推出的更加强大的Arm服务器CPU。与之匹配的将是NVSwitch 6芯片,采用3.6 TB/秒端口,ConnectX-9端口的运行速率为1.6 Tb/秒。有趣的是,路线图中还提到一款名为X1600 IB/以太网交换芯片的产品,这可能意味着英伟达正尝试将InifniBand与以太网ASIC融合起来,这几乎就是十年之前Mellanox的研发思路。又或者英伟达只是单纯想要勾起观众们的好奇心。继续将目光投向2027年,潜在的发展方向还包括Ultra Enthernet Consortium将全面支持NIC和交换芯片,甚至可能通过UALink交换机实现GPU在节点之内及跨机架间的连接。

作为八大科技巨头共同打造的、用于对抗英伟达的交换技术,让GPU巨头采用UALink当然有点荒谬。但谁知道呢,毕竟技术行业从来不缺少出人意料的故事。

好文章,需要你的鼓励

开源之光,AI之翼:我国如何抢占智能时代制高点?

全球主要国家纷纷将开源纳入国家级战略,开源生态呈现出一片欣欣向荣的景象。我国作为全球数字经济的重要参与者和建设者,自然不能置身事外。然而面对开源大潮,中国究竟准备好了吗?我们如何在激烈的国际竞争中抢占先机,打造属于自己的开源生态,并最终在智能时代占据制高点?

VSP One代表Hitachi Vantara对未来存储的理解和预测

VSP One不仅实现了设备和数据的统一管理,还极大提升了数据安全性和业务效率,为统一混合云存储提供了数据基础。

突破效率极限,JetBrains携手阿里云推出AI Assistant

在2024云栖大会上,全球软件开发工具提供商JetBrains发布了基于阿里云通义大模型的JetBrains AI Assistant,为开发者带来了全新的智能工具。

公用事业公司和超大规模企业如何应对“极端”数据中心电力需求

随着AI推动数据中心能源消耗的空前增长,公用事业公司和超大规模企业陷入了一种不稳定的、有时甚至是对抗性的合作关系以扩大产能。

西门子的生成式AI探索和绿色出海经验

开源之光,AI之翼:我国如何抢占智能时代制高点?

阿里云引领的SaaS进化论,AI加持的云端爆发

VSP One代表Hitachi Vantara对未来存储的理解和预测

亚马逊云科技连续三届支持世界技能大赛云计算赛项 助力职业院校培养云计算应用型技能人才

突破效率极限,JetBrains携手阿里云推出AI Assistant

云边融合 AI无界 SUSECON中国2024数字创新峰会隆重召开

公用事业公司和超大规模企业如何应对“极端”数据中心电力需求

视觉能力媲美OpenAI,Meta发布Llama 3.2

市场预测:到2032年AI服务器市场规模将突破1800亿美金

英特尔将“Granite Rapids”至强6处理器推向数据中心市场

深度丨立讯精密41亿收购亏损的Leoni AG,布局和底气在哪里