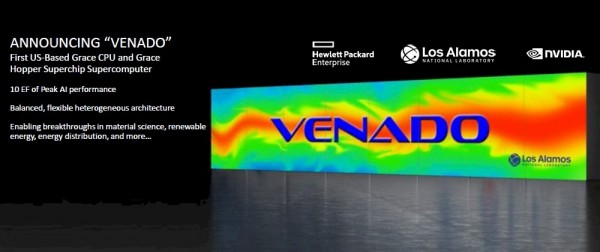

洛斯·阿拉莫斯国家实验室希望通过“VENADO”超级计算机打破内存墙

“Venado”超级计算机日前正式迎来启动剪彩仪式,其技术根基源自2021年4月英伟达宣布的第一项数据中心级ARM服务器CPU计划。而Venado本体的构建计划则由洛斯·阿拉莫斯国家实验室的研究员们于2022年5月公布,只是当时的相关细节还无法满足我们对于速度和馈送性能的大胆想象。

如今,我们终于迎来了关于Venado系统的更多具体指标,也对洛斯·阿拉莫斯实验室的运作方式有了更多了解。一言以蔽之,Venado让我们了解到这处实验室为什么比世界上其他高性能计算(HPC)中心更重视在内存带宽与算力之间求取平衡。

洛斯·阿拉莫斯国家实验室成立于1943年,这里是曼哈顿计划的故乡,全球首例核武器就诞生在这里。当然,彼时根本就不存在超级计算机,但洛斯·阿拉莫斯的研究人员一直在执行大量复杂计算。有些依靠手动方式完成,有些则通过IBM制表符以打孔卡这种早期模拟形式进行数据存储与操作。在洛斯·阿拉莫斯执行此类计算的第一台数字计算机被称为Maniac,于1952年安装到位。它每秒能够执行10000次运算,负责运行蒙特卡洛模拟,借此以随机方式模拟真实场景下的确定性过程。在接下来的四十年间,洛斯·阿拉莫斯实验室先后使用IBM、Control Data Corporation、Cray、Thinking Machines以及Silicon Graphics等一系列超级计算机,并于2008年安装了由AMD皓龙处理器与Cell加速器组成的IBM万亿次级“Roadrunner”系统,代表着CPU与加速器在历史上的首次集成协作。

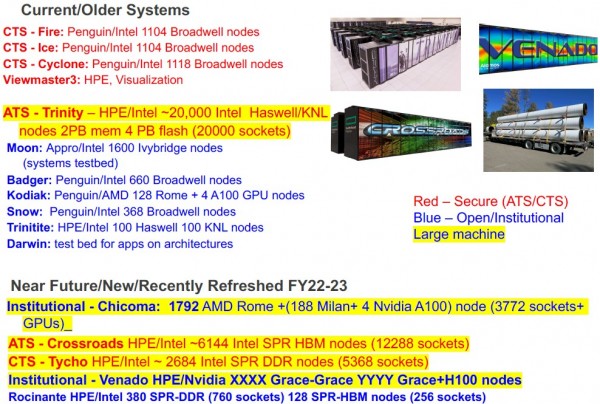

最近十年,洛斯·阿拉莫斯实验室于2015年安装了价值1.47亿美元的“Trinity”系统,其由英特尔至强与至强Phi CPU组成,配备有2 PB内存与英特尔100 Gb/秒Omni-Path互连机制。Trinity系统之所以值得关注,是因为其会将计算结果从内存中转移至突发缓冲区当中,以便设备能够继续执行计算。2023年8月安装的“Crossroads”超级计算机成为Trinity系统的继任者,这套超算设备采用英特尔“Sapphire Rapids”至强SP处理器,配备 HBM2e堆叠内存与HPE的Slingshot互连技术。

洛斯·阿拉莫斯实验室及其近邻桑迪亚国家实验室一直希望做出新的探索,利用ARM服务器构建超级计算机集群。洛斯·阿拉莫斯实验室曾长期研究如何借ThunderX4 Arm服务器(后来又转向Marvell)提升每核心对应的内存带宽。但由于实际表现不佳,无论是“Triton”ThunderX3两袖清风是ThunderX4都没能真正落地部署,因此洛斯·阿拉莫斯实验室说服英特尔为Sapphire Rapids开发了HBM版变体,并要求英伟达设计出能够与当前“Hopper”GH100及GH200 GPU加速器、乃至后续“Balckwell”GB100及GB200加速器相适配的“Grace”CG100 ARM服务器芯片。

最优内存解的探索之路

这套最新超算系统的名称Venado在西班牙语中为“鹿”或“牡鹿”之意,同时也指位于新墨西哥州的桑格雷-德克里斯托山脉。HPE成为系统的主要承包商,因此可以想见,这套系统并未采用英伟达用于建立共享内存GPU superpods的NVLink Switch共享内存互连技术。

两年之前,洛斯·阿拉莫斯实验室曾在Venado系统架构公告中提到,他们可能更倾向于在由Grace-Grace及Grace-Hopper计算引擎构建的Cray“Shasta”XE超级计算机系统内采用InfiniBand,而非HPE的Slingshot以太网变体。但从现在的实际情况来看,洛斯·阿拉莫斯实验室还是部署了200 Gb/秒Slingshot 11互连这既。根据我们的猜测,这是因为HPE Slingshot 11的200 Gb/秒端口要比英伟达的400 Gb/秒Quantum 2 InfiniBand端口便宜得多。

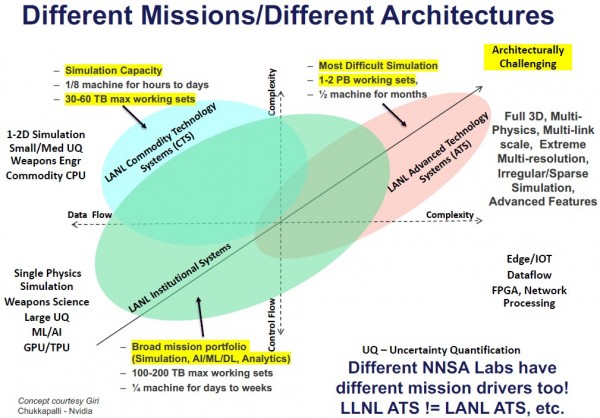

事实上,这套全新Venado系统并非洛斯·阿拉莫斯实验室计算设施中的骨干力量,而仅是其结合可用预算打造的固件研究型实验设备。洛斯·阿拉莫斯实验室部署的大多数设备都要经历提案、构建、核准后方可实际投入运行,以供负责管理美国军方核武器储备的国家核武器管理局使用。

下面来看2021年5月时,洛斯·阿拉莫斯实验室就Venado系统发布的正式公告:

我们还采访到洛斯·阿拉莫斯实验室高性能计算项目主管Jim Lujan及模拟与计算副总监Irene Colyters,其基本思路就是将计算负载以八比二的方式分配给这两种架构。其中80%的工作负载将由GPU运行(假设为FP64精度),而20%则交由CPU负责。

考虑到在常规GPU加速系统当中,约有95%到98%的算力来自GPU,因此Venado系统中CPU的算力贡献比例明显要更高一些。根据洛斯·阿拉莫斯实验室高性能计算部门负责人Gary Grider(担任该部门负责人已有两年半时间,同时也是突发缓冲区的设计者)的介绍,这样的计算负载划分方式有着充分的理由。

Grider解释道,“我们的应用程序属于复杂度极高的多物理场、多链路规模、极端高分辨率且极为繁复的程序包,其中包含高达数百万行代码。这些代码往往需要占据整个超算系统容量的一半,且要持续运行六个月才能得到答案。这类场景对我们来说很正常,但对多数其他能源部实验室而言却较为罕见。他们虽然也偶有类似体量的计算任务,但在频率上远远低于洛斯·阿拉莫斯。这些应用程序之所以需要持续运行六个月时间,是因为任务本身往往会以非常稀疏且不规则的方式访问内存,想要达成的目标也极为复杂——应用程序所运行的是一项体量相当于系统实际容量50倍的任务。因此,我们只能根据自身实际需求为模拟环境尝试各种设备组合与解决方案。最终,我们意识到完全依赖GPU并不可行,因为GPU只在密集线性代数运算中拥有强大的性能表现。而如果需要处理的任务稀疏且不规则,而且以索引、查找之类的操作为主,那么其表现并不会比CPU更好。通过多年的经验积累,我们意识到洛斯·阿拉莫斯实验室最需要关注的是每一块钱预算对应多少内存带宽,而非对应多少算力。”

好在市场给出了积极的回应:在GPU上运行深度学习推荐系统(DLRM)的超大规模基础设施运营商和云服务商们,同样需要一种方法来为推荐器提供远超GPU HBM内存容量的嵌入缓存,英伟达在这方面给出的答案就是Grace——其搭载一款出色的计算内存控制器,可额外支持480 GB LPDDR5内存容量。

与之对应的是,英伟达用两个72核Grace芯片通过NVLink端口连接成一块超级芯片,其中不单提供大量Arm“Demeter”V2核心,还配备960 GB内存容量与1 TB/秒内存带宽。由于每个V2核心拥有四个128位SVE 2向量引擎,Grace-Grace超级芯片能够自行提供7.1千万亿次的聚合峰值FP64算力。而对于更为常规的情况,即大部分计算任务由GPU负责执行,可以想见英伟达也在相应采用向量算力较弱的Arm“Perseus”N2核心。但根据我们的猜测,美国洛斯·阿拉莫斯和瑞士国家超级计算中心(CSCS)的“Alps”系统应该是选择了配备V2核心的英伟达系统。而且得益于Grace CPU中相对较少的核心数量、相对便宜且功耗更低的LPDDR5内存以及相对更大的480 GB可用内存,Grace在每核心内存带宽与单位内存带宽成本之间取得了很好的平衡。

其中Grace CPU拥有16个LPDDR5内存控制器,每个控制器的理论内存带宽总计为546 GB/秒,理论容量上限为512 GB。但Grace的实际交付版本只提供480 GB内存与500 GB/秒带宽。Grace-Grace超级芯片中的两块CPU通过900 GB/秒NVLink芯片到芯片实现(半导体行业称之为C2C)相互对接。这项NVLink C2C互连技术同样被用于将Grace CPU接入具有80 GB/96 GB HBM3或141 GB HBM3e内存容量的Hoppper GPU,具体视芯片型号而定。

总而言之,根据我们在2022年5月收集到的Grace及Hopper技术公告,以及洛斯·阿拉莫斯实验室官方确认的二八开负载分配原则,经过粗略计算可以大致认为:Venado超级计算机系统中可能包含3125个Garce-Hopper节点和大约1500个Grace-Grace节点。但考虑到Grace CPU的FP64性能其实超过很多朋友的想象——我们认为这肯定是有意为之,主要是为了照顾高性能计算客户(而非AI客户)的需求——实际Venado系统分别拥有2560个Grace-Hopper节点与920个Grace-Grace节点。

通过简单计算大家就会发现,Venado系统中共包含31.68万个Grace核心,峰值FP64性能可达15.62千万亿次。Venado节点中的Grace CPU共拥有2 PB主内存(内存容量与Trinity系统相同,我们认为这绝不只是巧合),LPDDR5内存的总带宽则为2.1 PB/秒。

系统当中共有2560个Hooper GPU,向量核心上的FP64性能合计为85.76千万亿次,张量核心上的FP64性能则为171.52千万亿次。如果使用H100上的张量核心,则Hopper上的FP64性能占比为92%,Grace CPU上的FP64性能占比为8%。但如果仅使用向量核心,则Ho之遥

上的FP64性能占比为85%。我们假设这些Hopper GPU各拥有96 GB的HBM3内存,则合计HBM3内存容量为240 TB、聚合带宽则为9.75 PB/秒。通过进一步计算,还会发现Venado系统中81%的内存带宽来自Hopper GPU,而余下19%由Grace CPU提供——几乎完美符合二八开原则。

作为与HPE合约中的一部分,Venado系统将采用配备Slingshot网络的Lustre并行存储集群。Grider还提到,洛斯·阿拉莫斯实验室还希望在Venado系统上尝试DeltaFS等更多其他文件系统。

Grider表示Venado系统现已安装并投入运行,但由于“偶尔会发生一些问题”,计划将在未来两个月内逐渐实现平稳交付。到今年7月左右,相信将有大量应用程序开始在这套实验性系统上运转起来。

好文章,需要你的鼓励

OpenAI实验模型在国际数学奥林匹克竞赛中获得金牌级表现

OpenAI研究科学家Alexander Wei宣布,公司一个未发布的实验模型在国际数学奥林匹克竞赛中解决了六道题目中的五道,获得42分中的35分,达到金牌水平。该模型展现出类似人类数学家的推理能力,能够构建复杂严密的论证。这标志着AI在创造性问题解决方面的重要突破,不过该技术预计数月内不会公开发布。

素描几笔就能找到关键点:加利福尼亚大学和萨里大学团队的跨模态AI识别突破

加利福尼亚大学和萨里大学研究团队开发了一种创新的AI系统,能够仅通过简单的手绘素描就在复杂照片中精确识别关键点。这项技术突破了传统机器学习需要大量同类数据的限制,实现了真正的跨模态学习。系统在动物关键点识别任务中达到了39%的准确率,超越现有方法约5个百分点,并且在真实手绘素描测试中表现稳定。该技术有望在生物学研究、医疗诊断、工业检测等多个领域找到广泛应用。

AGI和AI超级智能证明智能所需回答的问题数量

本文探讨了判断AI是否达到通用人工智能(AGI)和人工超级智能(ASI)水平所需的问题数量。目前缺乏确定的测试方法来评估是否达到顶级AI水平。基于图灵测试的分析,作者提出仅通过少量问题难以全面评估智能水平。参考美国国会图书馆主题标引(LCSH)的40万个主题领域,如果每个领域提出1万个问题,将需要40亿个问题来全面测试AGI。这种大规模测试虽然在逻辑上合理,但在实际操作中面临巨大挑战。

约翰霍普金斯大学推出DOTRESIZE:神奇的AI模型“瘦身术“让大模型既快又好用

约翰霍普金斯大学发布DOTRESIZE技术,通过最优传输理论实现AI大模型智能压缩。该方法将相似神经元合并而非删除,在保持性能的同时显著降低计算成本。实验显示,压缩20%后模型仍保持98%性能,为AI技术普及和可持续发展提供新路径。

OpenAI实验模型在国际数学奥林匹克竞赛中获得金牌级表现

AGI和AI超级智能证明智能所需回答的问题数量

AI在商业中的正确用量

AnyCoder:基于Kimi K2的快速Web应用开发工具发布

隐私安全需三思:AI获取个人数据权限的风险与挑战

备份工具Rescuezilla基于六个Ubuntu版本全面更新

Cursor收购企业初创公司Koala挑战GitHub Copilot

Soracom发布连接虚拟化管理器提升物联网灵活性

Cartken转向工业机器人:从末端配送到工厂自动化的商业策略转变

开发者对MCP协议应关注的5个核心问题

AI热潮下数据中心液冷技术的可持续发展趋势

从工具到队友:AI智能体将成为数字化劳动力