从决策式AI进阶到生成式AI,SSD将变得更为重要

在AI概念没有火热之前,无论手机还是PC都已经悄然引入人工智能加速相关的硬件和技术,目的是在部分功能上获得更好的体验,比如手机相册中的人脸智能识别和分类, PC和NAS在算力闲暇时对图像、视频的整理,以及视频通话时的背景虚化等等都是很好的例子。

这个时期的AI计算我们通常称为决策式AI,即在成熟的底层技术框架内,通过数据分类标签和辨别的形式,通过CPU、GPU、NPU等处理器合力,它们的特点是,具备一套成熟的判断机制,通过夜以继日的训练识别,不断提升精度,并具有很强的针对性。

随着大模型的火爆,另一种AI也推向了大众视野,即被称为生成式AI。无论是云端AI服务加速,还是近期能够本地运行200亿参数大语言模型的AI PC,它们的思维是发散且具有创造性的,同时对硬件也提出了更高的要求。

生成式AI背后的海量数据

生成式AI与决策式AI最大的不同在于模型的规模,大模型计算本身意味着高算力、高存储需求。正因为如此,LLM大语言模型才会成为推向应用层面的首要选择,原因很简单,相对于图像、视频而言,抽象的文字已经是最好整理的了。

但即便如此,大语言模型本身占用的数据量仍然巨大,以GPT-3为例,光是训练参数就达到了1750亿个,训练数据达到45TB,每天会产生45亿字内容,每次训练费用需要460万美元。而进阶到GPT-4之后,训练参数从1750亿个增加到1.8万亿个,训练成本进一步提升到6300万美元,训练数据量信息虽然没有公布,但可想而知增长也是指数级的。

有意思的是,大语言模型训练在当下似乎已经变成了日常,头部厂商已经将目光投向了图像生成和视频生成,近段时间火热的文字生成视频应用Sora,以及文生图Midjourney都是很好的例子。现在我们知道光是文字内容就可以占据海量的存储空间,如果将训练模型换成图像、视频,对内容存储和读写性能需求也注定指数级攀升。

SSD很重要

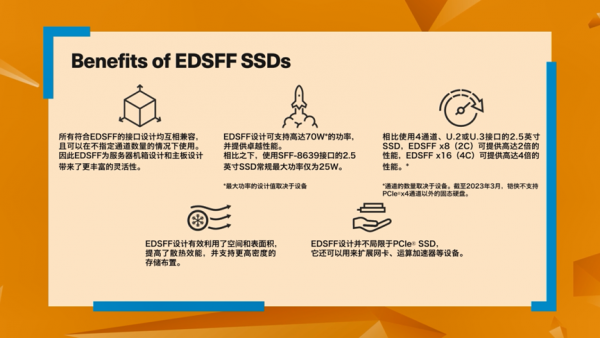

随着生成式AI深入到不同领域,能够提供高速存储性能的SSD变得至关重要。不仅如此,对于企业和数据中心而言,存储的可靠性、能效、性价比,以及对前沿技术的支持都变得至关重要。比如,企业级用户会考虑在有限的机房空间内获得更多的容量,即提升单位存储密度,并且还要考虑机架和机房的散热能力和供电能力,这时候EDSFF规格似乎就成为了不错的选择。

EDSFF,即企业与数据中心标准外形规格,特点是由头部企业引领并获得行业认可,针对物理尺寸、散热、性能、布局、安装便捷性等特性优化,从而达到更好的效果。

比如铠侠CD8P就配备了前瞻性的EDSFF E3.S版本,支持PCIe® 5.0和NVMe™ 2.0,可提供高达30.72TB的存储容量,拥有可达12,000MB/s顺序读取性能,并具备2000K IOPS的4K随机读取能力,在能耗与应用性能表现之间做到很好的平衡,为数据中心和企业级用户提供合理的扩容选择。

如果希望性能更进一步,铠侠CM7系列作为高性能企业级双端口固态硬盘同样值得参考,事实上CM7系列是较早提供PCIe® 5.0和NVMe™ 2.0支持,并已经充足释放PCIe® 5.0性能的产品,最大容量同样也达到了30.72TB。拥有高吞吐量和高密度存储的性能表现,非常适合大模型计算,大数据,深度学习加速、AIGC等人工智能应用场景。

而随着生成式AI的硬件需求越来越高,同时也不能忽视庞大的数据量需要高性能接口、大容量存储支持,铠侠企业级和数据中心级固态硬盘则早已为其做好了充足的准备。未来AI的发展路径中,也注定少不了铠侠SSD承担起存储与加速的重要角色。

*容量的定义:铠侠定义1兆字节(MB)为1,000,000字节,1千兆字节(GB)为1,000,000,000字节,1兆兆字节(TB)为1,000,000,000,000字节。但是计算机操作系统记录存储容量时使用2的幂数进行表示,即定义1GB = 230 = 1,073,741,824字节,因此会出现存储容量变小的情况。可用存储容量(包括各种媒体文件的示例)将根据文件大小、格式、设置、软件和操作系统(例如Microsoft®操作系统和/或预安装的软件应用程序)或媒体内容而异。实际格式化的容量可能有所不同。

*1千位字节 (KiB) 指 210, 或1,024字节,1兆字节(MiB) 指 220,或1,048,576 字节,1千兆字节(GiB)指230, 或1,073,741,824字节。

*IOPS:每秒输入输出(或每秒I/O操作数)

*读写速度可能因主机设备、读写条件和文件大小的不同而不同。

*信息随时可能更改:虽然铠侠在发布时已努力确保此处提供信息的准确性,但产品规格、配置、价格、系统/组件/选项等的可用性都可能发生更改,恕不另行通知。

*产品图像可以代表设计模型。图像仅用于说明目的。产品外观可能与实际产品不同。闪存组件的实际数量因硬盘容量而不同。

来源:业界供稿

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机