阿里云+英特尔 让大模型在CPU上也能“飞奔”! 原创

《2024 AIGC应用层十大趋势白皮书》显示,随着AIGC技术的发展,智能化应用将呈现爆发式增长。到2024年全球将涌现出超过5亿个新应用,这相当于过去40年间出现的应用数总和。

面对新应用不断涌现,不同算力需求接踵而至,如何去满企业对算力的需求,成为下一阶段的主要挑战。基于这种考虑,阿里云与英特尔进行了深度交流与产品化定制化创新,合作推出的第八代企业级实例——ECS g8i应运而生。

算力、网络、性能、应用 ECS g8i全面跃迁

1月11日,阿里云宣布,基于第五代英特尔至强的可扩展处理器的阿里云第八代企业级通用计算实例ECS g8i,正式上线商业化。

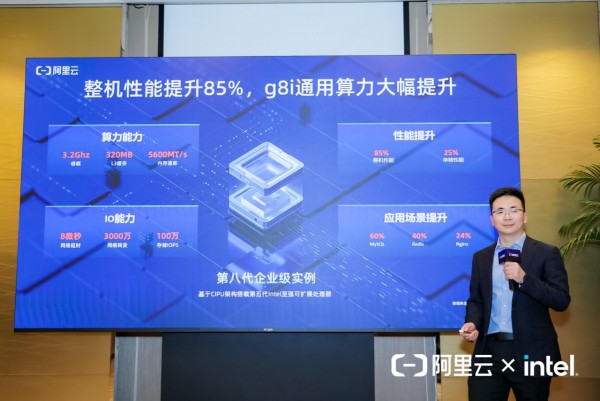

升级后的ECS g8i引入了国内首款代号为Emerald Rapids的第五代英特尔至强可扩展处理器。得益于阿里云自主研发的创新“飞天+CIPU”架构体系,ECS g8i实例在整机性能上实现了高达85%的显著提升,而在AI推理性能上更是实现了惊人的7倍飞跃。

此外,ECS g8i还提供了全方位的端到端安全防护,为企业打造可信赖的AI应用提供了强大且安全的算力支持。

“ECS g8i实例的卓越表现再次证明了以CPU为核心的计算体系在加速AI推理方面具有巨大的潜力。公共云平台不仅能够处理超大规模的AI模型,还为AI应用的快速部署和实现打开了新的大门。这一创新将推动整个行业向前迈进,开启AI技术新篇章。”阿里云弹性计算产品线总经理张献涛慷慨激昂地说。

事实上,升级后的ECS g8i,各方面的能力都获得了显著提升。在算力层面,将L3缓存容量扩展至320MB,同时它的内存速度更是飞跃至5600MT/s。在性能上,这款新实例“自信”地展示了它85%的整机性能提升和25%的单核性能提升。网络方面,它也展现了惊人的能力,PPS高达3000万,时延却低至8微秒。在应用场景的大舞台上,这款新实例让MySQL数据库的性能提升至60%,Redis和Nginx的表现也分别提升了40%和24%。

ECS g8i惊人的“段位升级”,离不开第五代英特尔至强可扩展处理器的加持。英特尔中国数据中心和人工智能集团至强客户解决方案事业部总经理李亚东表示:“最新上市的第五代英特尔至强 可扩展处理器每个内核均内置AI加速功能,完全有能力处理要求严苛的AI工作负载。与上代相比,其AI训练性能提升多达 29%,AI推理能力提升高达 42%。我们希望借由阿里云第八代企业级实例(ECS g8i)共同助力开发者实现技术普惠,让AI技术无处不在。”

英特尔中国数据中心和人工智能集团 至强客户解决方案事业部总经理 李亚东

AI应用“误解“了CPU?

然而这款基于CPU处理器进行AI推理的实例,却曾受到质疑——CPU也能跑AI应用?

如今,一提到AI计算,似乎总能联想到GPU这个“关键词”。然而,CPU在AI应用中的角色和重要性经常被低估。普遍的误解是,CPU由于其设计和构造,不适合处理AI任务。但是,随着技术的进步和创新,CPU正在逐步展现出其在AI领域中的潜力和有效性。

不可否认的是,尽管CPU通常被视为通用计算的服务器,它在执行并行计算和处理大型AI模型方面面临一些固有挑战。这些挑战包括首包时延、吞吐性能等,是评估大模型和业务体验的关键指标。在这些方面,CPU通常被认为不如GPU,后者在浮点计算、并行处理和内存带宽方面表现更出色。

阿里云弹性计算高级产品专家 姬少晨

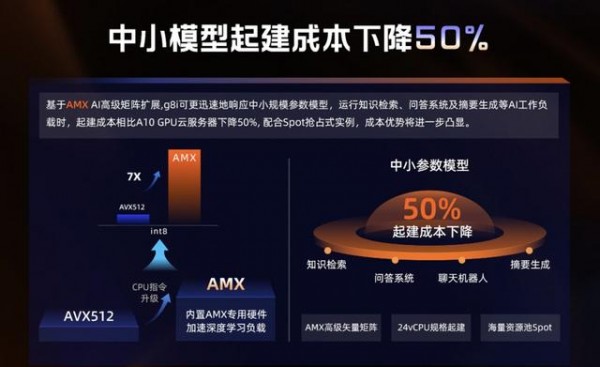

然而,阿里云ECS g8i实例却通过技术创新“逆转翻盘”。通过将内置指令集从AVX512升级到了Intel AMX高级矩阵扩展加速技术,让生成式AI更快地运行。阿里云弹性计算高级产品专家姬少晨解释说:“相对于AVX512指令集,启用AMX AI加速后,ECS g8i实例在int 8矩阵计算的性能最高提升7倍。”

此外,ECS g8i也在内存带宽和网络延迟方面进行了优化。利用云计算的弹性和可扩展性使得通过分布式计算和快速横向扩容,有效地解决单个实例中内存带宽不足的问题。同时配置eRDMA超低时延的网络,天然就解决了集群后效率的下降、调度影响等后续问题,与传统的VPC集群相比,集群效率提升近90%。

“通过这样的eRDMA超低时延把集群效率进一步提升,将异构计算或AI计算集群化的能力真正推向了可实用。再辅以多方面能力、算法,以及集群效率、弹性补充,和通用计算创新,使得原本不可能利用CPU处理的AI相关工作,变得有可能。”姬少晨如是说。

在成本和实践层面,ECS g8i可更迅速地响应中小规模参数模型,运行知识检索、问答系统及摘要生成等AI工作负载时,起建成本相比传统GPU服务器下降50%。

阿里云弹性计算产品线副总经理 王志坤

这一次,ECS g8i的推出,向业界澄清了对CPU的“误解”。正如阿里云弹性计算产品线副总经理王志坤所言:“阿里云独有的“飞天+CIPU”架构,加上英特尔强大的算力基础,让我们打破了过去固有的模式。大模型将不再只有“GPU+AI芯片”这一种组合。”

在产品开发和设计ECS g8i实例过程中,阿里云也持续秉承着“高性能、高安全、高稳定、高弹性、低成本“的理念,通过ECS g8i将”普惠AI”传递到千行百业。

“未来,我们将持续为AI提速,给安全加码。”姬少晨说。

好文章,需要你的鼓励

据报道,IBM对HashiCorp的收购即将达成

据《华尔街日报》近日报道,IBM公司正在就收购基础设施管理供应商HashiCorp公司进行深入谈判。

亚马逊云科技:将“构建块”蓝图与CodeCatalyst结合,实现DevOps等项目全面提速

亚马逊云科技已经将项目开发套件(PDK)蓝图引入其CodeCatalyst DevOps工具当中。

法国奢侈品巨头LVMH:AI挑战奢侈品行业的根源是人、而非技术

各大奢侈品牌一直广泛运用基础AI技术开展数据分析,借此预测需求、管理供应链并支持其他运营用例,但近期生成式AI的爆发式演进将AI技术提升到了新的水平,既带来种种前所未有的机遇、也造就意想不到的挑战。

中关村论坛盛大开幕,北电数智携三大AI硬核创新项目登场

据报道,IBM对HashiCorp的收购即将达成

亚马逊云科技:将“构建块”蓝图与CodeCatalyst结合,实现DevOps等项目全面提速

Fortinet斩获2024年Gartner安全服务边缘(SSE)魔力象限“挑战者”

浪潮商用机器2024 Power Start精彩上演 乘AI东风再绘生态新蓝图

MiniGPT4-Video:让大模型分析视频内容,依然有难度

2024中国移动算力网络大会主论坛议程抢先看!

法国奢侈品巨头LVMH:AI挑战奢侈品行业的根源是人、而非技术

五一促销季火热来袭,购联想AI PC一键快乐!

推动数字化智变发展 锐捷网络保持行业领先

深入洞察专科用户信贷需求 数禾科技以科技实力高效释放普惠、反诈力量

8000㎡数字世界,2024中国移动算力网络大会主题展区精彩剧透