市场分析:AI如何再次点燃人们对硬件的兴趣

长期以来,美国劳伦斯利弗莫尔国家实验室一直是全球最大的超级计算能力消费者之一。这个由美国能源部运营的机构拥有超过200 petaflops(每秒2000亿次浮点运算)的计算能力,运行着来自美国各大制造商的超级计算机系统。

过去两年中,该实验室采用的系统中增加了两个新来者:Cerebras Systems和SambaNova Systems。这两家初创公司总融资规模超过18亿美金,正试图颠覆迄今为止由x86 CPU和GPU主导的市场,由那些专门用于人工智能模型开发和推理处理的硬件来运行这些模型。

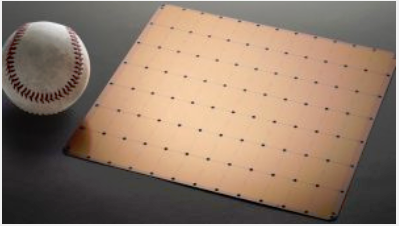

Cerebras表示,自己的WSE-2芯片建立在晶圆级架构上,可以提供2.6万亿个晶体管和850000个CPU核心来承载训练神经网络的任务,这大约是高端GPU上晶体管数量的500倍和核心数量的100倍。Cerebras声称,该架构凭借40 GB的板载内存和高达2.4 PB的外部内存,可以处理因为过于庞大而无法在基于GPU的设备上运行的AI模型。Cerebras以40亿美金的估值融资了7.2亿美元。

SambaNova表示,自己的DataScale集成软硬件系统可以训练深度学习模型(这种模型广泛用于语言处理和图像识别),比Nvidia人工智能优化的DGX A100计算机快6倍,一部分原因是该系统的内存容量增加了13倍。

劳伦斯利弗莫尔国家实验室正在使用美国国家核安全局的Lassen超级计算机(如图),以及Cerebras的专用芯片,该芯片的大小是标准数据中心GPU的57倍,因此可以容纳到超过1.2万亿个晶体管中。

美国劳伦斯利弗莫尔国家实验室的de Supinski。他看到,专用硬件可将性能提升5倍。图片来源:美国劳伦斯利弗莫尔国家实验室

美国劳伦斯利弗莫尔国家实验室首席技术官Bronis de Supinski表示,使用经过AI优化的设备所积累下来的经验非常有用。他表示:“很多人认为我们即将看到摩尔定律的终结,我们认为,通过引入机器学习模型,大大减少我们必须执行的计算量,可以显着提高速度。”他说,早期迹象表明,专有AI超级计算机的性能是基于GPU的系统的5倍。

芯片重生

多年来,计算机硬件一直是一个乏善可陈的市场。占主导地位的x86微处理器架构正在触达可通过小型化实现性能增长的极限,因此制造商们的目光聚焦于在芯片中封装更多核心上。

对于快速发展的机器学习和深度学习(这是当今主要的两种人工智能),GPU是一大救星。GPU最初是为图形处理而设计的,可以有数千个小型核心,非常适合提供AI训练所需的并行处理能力。

IDC全球基础设施实践研究副总裁Peter Rutten说:“人工智能的本质在于能够从并行处理中受益。”大约在10年前人们发现,原本设计初衷是把像素投放在屏幕上的GPU,很擅长做并行处理,因为GPU是并行处理引擎,你可以在GPU中放很多核心。”

这对Nvidia来说是个好消息,Nvidia在这个市场出现萎缩之前,市值从2015年不到180美金飙升到2021年的7350亿美金。一直到最近,Nvidia都几乎独占整个市场,但许多竞争对手正在力求改变这种状况。

Gartner分析师Detake认为,高性能计算和AI工作负载的融合,推动了对新型硬件加速的需求。图片来源:Gartner

对于AI工作负载,“到目前为止主要还是使用Nvidia GPU,但用户正在寻找其他技术可以将这类工作负载提升到一个新的水平上,”Gartner专门研究运营AI系统的分析师Chirag Dekate这样表示。“这并不意味着GPU已经终结,但是随着高性能计算和AI工作负载继续融合,你会看到更多种类的加速器涌现。”

市场里的所有玩家

大型芯片制造商并没有停滞不前。三年前,英特尔收购了Habana Labs,让这家以色列芯片制造商成为英特尔AI开发工作的重点。去年春天,英特尔推出了针对训练优化的Habana Gaudi 2处理器和Greco推理处理器,据称其速度至少是Nvidia旗舰产品A100 GPU的2倍。AMD一直对自己在AI抱负很低调,但也表示,新的Ryzen系列处理器将包含内置的机器学习功能。

今年3月,Nvidia推出了具有800亿个晶体管并Nvidia高速NVLink互连技术的H100加速器GPU。它配置了专用引擎,可以提升自然语言处理中使用的Transformer模型执行速度,与上一代相比提高6倍。MLPerf基准测试的最新结果显示,H100在大多数深度学习测试中的表现要优于Gaudi 2。此外,Nvidia也被认为在软件堆栈方面具有优势。

Dekate说:“很多用户选择GPU,是因为他们可以利用容器化软件的生态系统。Nvidia之所以如此成功,是因为他们建立了生态系统的战略。”

超大规模云厂商甚至比芯片制造商更早进入该行业。谷歌的Tensor Processing Unit是一种专用的集成电路,于2016年推出,目前已经是第四代了。AWS早在2018年推出了面向机器学习的Inferentia推理处理加速器,称性能是GPU加速实例的2倍多。上个月,AWS宣布基于Trainium芯片的云实例全面上市,并表示在深度学习模型训练场景中,在性能相当的情况下,其成本比同类基于GPU的EC2低 50%。谷歌和AWS的努力都主要集中在通过云服务进行交付的方式上。

当这些成熟的市场领导者专注于渐进式改进时,很多正在开发AI专用硬件的初创公司进行了越来越多有趣的创新。根据PitchBook Data的数据显示,去年他们给芯片初创公司投资的18亿美金中,这种类型的初创公司占了最大的份额,是2017年投资额的2倍多。他们正在追逐的可能是一棵巨大的摇钱树:根据市场研究公司Allied Market Research预计,到2030年,全球AI芯片市场规模将从2020年的80亿美金增加到近1950亿美金。

更小、更快、更便宜

很少有初创公司想要取代x86 CPU,但这主要因为这么做几乎没有什么影响力。Forrester首席分析师Mike Gualtieri说:“芯片不再是瓶颈,不同芯片之间的通信才是一个巨大的瓶颈。”

Cerebras使用“晶圆级”集成,将数万亿个处理器应用于神经网络。图片来源:Cerebras

CPU执行低级别操作例如文件管理和任务分配,但“纯粹的CPU专用方法已经不再适用于扩展了,”Gartner分析师Dekate说。“CPU专为各种活动设计,从打开文件到管理内存缓存,CPU必须是通用的,”这意味着CPU不太适合运行AI模型训练所需的大规模并行矩阵算术运算。

市场上大多数做法都是围绕着协处理器加速器、专用集成电路、以及在较小程度上针对特定用途进行微调的FPGA。“除了Arm和AMD之外,没有人试图取代CPU,”IDC分析师Rutten说,这里他指的是低功耗CPU参考设计创造者Arm。

Rutten说:“每个人都在遵循谷歌的说法,即开发与CPU协同工作的协处理器,通过把算法硬编码到处理器而不是作为软件运行的方式来应对AI工作负载中特定的部分。这些ASIC正是为做好一件事而专门打造的。”

加速方法

这基本上就是Blaize眼下正在做的事情。这家位于美国加州埃尔多拉多山的公司,是由三位前英特尔工程师创立的,到目前为止已经融资了1.55亿美金。Blaize打造了所谓的Graph Streaming Processor,用于自动驾驶汽车和视频监控等边缘计算场景。这种完全可编程的芯片组具有CPU的很多功能,但针对任务级并行性和流式执行处理进行了优化,运行功率仅为7瓦。

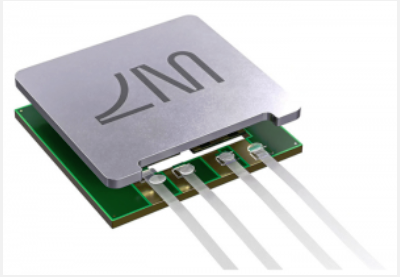

Blaize的Graph Streaming Processor使用图形数据结构来支持神经网络处理。图片来源:Blaize

Blaize的架构基于图形数据结构,在这种架构中,对象之间的关系呈现为相互连接的节点和边缘。Blaize公司联合创始人、首席软件架构师Val Cook说:“每个机器学习框架都使用了图形的概念,我们在整个芯片设计过程中保持相同的原则。我们可以执行整个图形,其中包括CMM,但是也可以包括自定义的节点。我们可以在这些图形中加速任何并行计算。”

Blaize表示,这种基于图形的架构解决了GPU和CPU在容量上的一些局限性,可以更灵活地适用于不同类型的AI任务,还让开发者把更多处理任务迁移到边缘以实现更好的推理性能。Blaize公司软件开发副总裁Dmitry Zakharchenko表示:“如果你摄像头设备上对80%的处理任务进行预处理,那么你就可以节省下大量的时间和成本。”

Blaize是瞄准了边缘应用的少数几家初创公司之一,在这些应用中,智能性被移动到更靠近数据的位置以实现瞬间决策。大多数都是针对推理场景(AI模型的现场部署)的,而不是计算量更大的训练任务。

Axelera AI B.V.正在开发一种芯片,芯片使用内存计算来降低延迟和对外部存储设备的需求。该公司营销和传播经理Merlijn Linschooten表示:“我们的AI平台将提供灵活性,能够在运行多个神经网络的同时保持高精度。”

Kalray公司将他们的数据处理单元系列称为“大规模并行处理器阵列”,具有可扩展的80核处理器,能够并行执行数十项任务。该公司首席执行官Eric Baissus在接受电子邮件采访时表示:“Kalray的关键创新,是把张量协同处理器紧密集成到每个处理元素中,支持元素之间直接交换张量数据以避免内存带宽瓶颈,可以实现高效的AI应用加速,因为预处理和后处理都是在相同的处理元素上执行的。”

总部位于以色列特拉维夫的Hailo Technologies公司,专注于使用一种缩略图大小的芯片组对深度学习模型进行推理,据称该芯片组每秒可执行26万亿次操作,功耗不到3瓦。为了做到这一点,Hailo将用于训练深度学习模型的每个网络层分解为所需的计算元素,并将这些元素全部整合到一个专为深度学习开发的芯片上。

Hailo公司业务开发副总裁Liran Bar表示,使用板载内存进一步降低了开销。“Hailo的整个网络都是在芯片内部的,我们没有外部存储器,”这意味着芯片可以体积更小,功耗更低。Hailo表示,这种芯片可以近乎实时地针对高清图片运行深度学习模型,从而让一台设备就能对四个车道上的车辆进行自动车牌识别。

游戏规则改写者

还有一些初创公司正在酝酿更多的创新计划,重新定义训练和运行AI模型的整个平台。

Graphcore的3-D芯片设计把近1500个并行处理核心封装到一个芯片上。图片来源:Graphcore

Graphcore表示,Graphcore的AI处理器针对机器学习进行了优化,每秒可管理多达350万亿次处理操作,具有近9000个并发线程和900MB的处理器内存Graphcore的Bow-2000 IPU Machine集成计算系统据称每秒可以实现1.4 petaflops的计算性能。

不同之处在于Graphcore的三维堆叠晶圆设计,使其能够在芯片中封装近1500个并行处理核心。Graphcore公司首席执行官Nigel Toon 接受电子邮件采访时说:“所有这些都能够运行完全不同的操作,这让Graphcore与其他主流GPU架构有所区分,后者更适合于运行大型数据块操作。”

Graphcore已经融资超过6.8亿美金,客户中包括美国能源部太平洋西北国家实验室、阿贡实验室和桑迪亚实验室。Toon表示,Graphcore的系统已经被用于训练蛋白质折叠模型和气候建模。

总部位于波士顿的LightMatter公司正在致力于解决互连问题(互连是将集成电路上的组件相互连接起来的布线)。随着处理器达到理论上的最大速度,移动字位的路径开始成为瓶颈,尤其是当多个处理器同时访问内存的时候。Forrester分析师Gualtieri说:“相比互连来说,现在芯片都不算是瓶颈了。”

LightMatter使用光子而不是电子来以低功耗的方式实现高速互连性能。照片:LightMatter

LightMatter的芯片在一个AI平台中使用纳米光子波导,据称该平台在低能耗的封装中同时实现了高速和大带宽,本质上是一个光通信层,可以连接多个其他处理器和加速器。

LightMatter公司首席执行官Nick Harris在电子邮件中表示:“AI结果的质量取决于能够同时支持非常大、非常复杂的模型,同时实现非常高的吞吐量响应,这两者我们都可以实现。这种芯片适用于任何可以使用线性代数完成的操作,”其中包括覆盖了大多数的AI场景。

LightMatter已经融资1.13亿美金,该公司重点强调了在能源效率方面的优势,这也许会和那些非常依赖GPU模型训练的企业组织产生共鸣,因为Nvidia的新型H100芯片最大功耗达到了惊人的700瓦。

Forrester分析师Gualtieri说:“相比互连来说,现在芯片都不算是什么瓶颈了。LightMatter可能具有非常巨大的颠覆力。”

独角兽

没有哪家初创公司像SambaNova那样引起了如此多的兴趣和投资。SambaNova拥有11亿美金的融资和50亿美金的市值,让人们对SambaNova的软硬件集成平台寄予厚望,而且SambaNova称,可以在数据中心一直到边缘的任何地方运行AI和其他数据密集型应用。

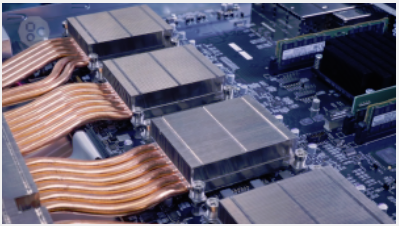

SambaNova的DataScale硬件平台使用专为机器学习和深度学习定制设计的7纳米芯片,该芯片可重新配置的数据流架构运行着一个AI优化的软件堆栈,其硬件架构旨在最大限度上减少内存访问,从而减少互连瓶颈。

Dekate说:“SambaNova的处理器可以针对AI或者高性能计算工作负载进行重新配置,旨在以更高的性能处理大规模矩阵运算任务,”这对于那些具有可变工作负载的客户来说是一个好处。

SambaNova公司产品高级副总裁Marshall Choy表示,他们正在采取一种全新的方法,因为CPU、GPU甚至FPGA“确实非常适合于交易系统和ERP等确定性软件”。然而,机器学习算法是概率性的,这意味着结果是无法提前知晓的。“为此需要一种完全不同类型的硬件基础设施,”他说。

SambaNova的平台把1TB高速双倍数据速率同步内存固定到处理器上,最大限度地减少了互连问题。Choy说:“我们基本上可以用增加20倍的片上内存来弥补DDR控制器的延迟问题,这对用户来说是透明的,这让我们能够训练更高参数计数的语言模型和最高分辨率的图像,而无需图像分块或者是向下采样。”

Tiling是图像分析中使用的一种技术,通过把图像切割成更小的块、分析每个块然后重新组合,来降低对计算能力的需求。向下采样则是在训练数据的随机子集上训练模型,以节省时间和计算资源。

SambaNova的Choy:“我们正在帮助人们做他们以前做不到的事情。”图片来源:SambaNova

SambaNova称,这么做的结果就是,系统不仅比基于GPU的系统更快,而且能够解决更大的问题。Choy说:“如果你尝试用512个立体图像训练GPU模型,结果会出现内存不足的错误;你就是无法做到,而现在,我们让人们能够做他们以前做不到的事情。”

一种新型的计算

有如此多的公司都在致力于解决相同的问题,因此市场洗牌也就不可避免了,只是不会很快来临。GPU还将存在很长一段时间,并且仍然是那些不需要极端性能的AI训练和推理项目最具成本效益的解决方案。

然而,随着高端市场的模型变得越来越大、越来越复杂,对特定功能架构的需求也将随之增加。Gartner分析师Dekate表示:“三到五年后,你可能会看到GPU和AI加速器体现出的多样性,这是我们能够扩大规模以满足本世纪末及未来需求的唯一途径。”

我们预测,那些领先的芯片制造商们将继续做他们擅长的事情,逐步巩固他们现有的技术基础。很多厂商还将效仿英特尔,收购专注于AI的初创公司。高性能计算领域也在关注AI的潜力,帮助解决大规模模拟和气候建模等经典问题。

Dekate说:“高性能计算生态系统始终在关注那些他们可以吸收的新技术,以保持领先地位,他们正在探索AI可以带来什么。”在这个背景下还有量子计算,一种理论性多于实践性的技术,但量子计算有可能彻底改变计算方式。

无论哪种新架构获得青睐,这股AI浪潮无疑重新点燃了人们对硬件创新开辟软件新领域潜力的兴趣。

SambaNova公司的Choy说:“你的系统每增长一个数量级,你都必须考虑对系统架构的完整重构,从exascale跃升到zettascale需要大量的硬件和软件优化,而芯片是其中一个重要的组成部分。在未来的十年中,芯片不会保持不变的。”

好文章,需要你的鼓励

从智能搜索到无缝医疗:AI 将如何改变 2025 年的体验

到 2025 年,人工智能将在生命科学行业带来重大变革。从智能搜索到无缝医疗服务,AI 将优化医疗专业人员和患者的体验。文章预测了 AI 在监管、安全、搜索、个性化服务等方面的具体应用,以及行业技术格局的变化。这些创新将为患者和医疗专业人员带来更高效、更有针对性的服务。

TenneT 在北海部署海上光纤网络以提升输出能力

TenneT 携手诺基亚在北海部署光纤网络,连接海上风电场,助力可再生能源增产。该项目将采用先进光网络技术,支持远程监控和管理,确保可靠的能源传输。这一创新模式有望推动欧洲能源转型,为实现 2050 年气候中和目标做出重要贡献。

联想携手新加坡圣淘沙物流打造智能仓储

新加坡物流公司ST Logistics与联想合作,通过新的仓库执行系统和AI算法自动化关键流程。该系统优化货物移动,自动规划最快捷安全的运输路线,加快订单处理。联想的高性能计算系统和AI算法还将优化货物存储,提高即时发货物品的可访问性。这一合作旨在提升供应链效率,增强新加坡在区域竞争力。

Coldago 发布三份文件存储供应商评估图谱

研究机构 Coldago 针对不同文件存储应用场景,发布了三份独立的供应商评估报告。报告采用四象限图形式,将供应商分为企业级文件存储、高性能文件存储和云文件存储三类。这种分类方法与 GigaOm 的圆形四象限雷达图有所不同,体现了两家分析机构对文件存储市场的不同见解。

AI时代的网络安全,企业要做好哪些准备?

游戏生命周期有多长?13年的《坦克世界》打响营销新战役

黄仁勋CES记者会实录:AI扩展没有物理限制,英伟达只专注做好两件事

从黄仁勋CES全程高能演讲,看英伟达庞大AI棋局:物理AI、AI PC、通用机器人

Alphabet运用AI科技加速抢隐救灾——企业应当从中吸取哪些教训

OpenAI权威报告!美国再不抓紧,1750亿美元将投资中国

2025年CIO的十大首要任务

当首席数据官成为业务战略家

2025年第四届AIGC中国开发者大会在北京圆满举行,发布2025年AI十大颠覆式行业发展趋势

360 AI负责人梁志辉:AI搜索不是"缝合怪",2025是从游击队转向正规军的关键一年