英伟达重磅发布性能最高的下一代H100 GPU芯片

在今天举行的2022 GPU Technology Conference大会上,英伟达宣布推出了强大的下一代GPU。

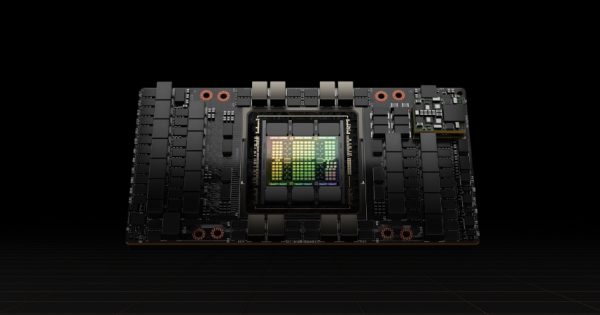

新款GPU基于Nvidia Hopper架构(如图),英伟达承诺该芯片与两年前推出的上一代Ampere芯片相比,性能提升了一个数量级。

第一款基于Hopper架构的GPU是Nvidia H100,一个强大的加速器,包含了800亿个晶体管和多项新功能,其中有Transformer Engine以及可扩展性更高的Nvidia NVLink互连功能,用于提升大型AI语言模型、深度推荐系统等等。

英伟达表示,H100 GPU非常强大,只需20个这样的GPU就可以承载全球所有互联网流量,这也让H100成为那些最先进的AI工作负载的理想选择,例如数据实时推理等。同时,这也是首款支持PCIe Gen5和使用HBM3的GPU,后者意味着H100拥有超过3TB的内存带宽。

重要的是,英伟达H100 GPU更新采用了新的Transformer Engine,可以将基于Transformer的自然语言处理模型速度提高到是上一代A100 GPU的6倍。其他改进还包括第二代安全多实例GPU技术,可将单个H100芯片划分为7个更小的、完全隔离的实例,也就意味着可以同时处理多个工作负载。

H100同时也是第一款拥有机密计算能力的GPU,可在AI模型及其运行时保护它们的数据。此外,H100拥有新的DPX指令,可以实现加速动态编程,一种在很多优化、数据处理和组学算法中常用的技术,英伟达称,其速度是现有最先进的CPU的40倍。因此,H100芯片可以用于加速自主机器人编队使用的Floyd-Warshall算法,或者用于DNA和蛋白质分类序列比对的Smith-Waterman算法。

英伟达表示,H100 GPU旨在为使用大规模AI模型的沉浸式实时应用提供动力,让更高级的聊天机器人能够使用有史以来最为强大的单片变压器语言模型——Megatraon 530B,且吞吐量比A100 GPU高出30倍。英伟达承诺,该芯片还能让研究人员更快速地训练其他大型AI模型。

英伟达表示,除了为AI模型提供动力之外,H100 GPU还将在机器人、医疗、量子计算和数据科学等领域带来重大影响。

H100将于第三季度上市,届时客户将有一系列可用的选项,例如英伟达表示,第四代DGX 系统DGX H100将包含8个H100 GPU,最高可以实现32 petaflops的AI性能。H100芯片也将通过云服务厂商提供,包括AWS、Google Cloud、微软Azure、Oracle Cloud、阿里云、百度AI云和腾讯云,所有这些厂商都计划提供基于H100的实例。

此外,戴尔、HPE、思科、Atos、联想等厂商还将提供一系列采用H100的服务器产品。

除了H100 GPU之外,英伟达还推出了首款基于Arm Neoverse的离散数据中心CPU,专为针对AI基础设施和高性能计算而设计。

这款名为Nvidia Grace CPU Superchip的CPU,包含了2个通过NVLink-C2C(一种新的高速和低延迟芯片到芯片互连技术)连接的CPU,是对英伟达去年推出的首款CPU-GPU整合模块Hopper Superchip的一个补充。Nvidia Grace CPU Superchip将144个Arm核心打包在一个插槽中,支持Arm新一代矢量扩展和英伟达所有计算软件堆栈,包括Nvidia RTX、Nvidia HPC、Nvidia AI和Omniverse。

这些芯片也将于第三季度推出,届时将为那些要求最为苛刻的高性能计算、人工智能、数据分析、科学计算和超大规模计算应用提供所需的性能。

来源:业界供稿

好文章,需要你的鼓励

Meta与特拉维夫大学联手打造VideoJAM:让AI生成的视频动起来不再是奢望

Meta与特拉维夫大学联合研发的VideoJAM技术,通过让AI同时学习外观和运动信息,显著解决了当前视频生成模型中动作不连贯、违反物理定律的核心问题。该技术仅需添加两个线性层就能大幅提升运动质量,在多项测试中超越包括Sora在内的商业模型,为AI视频生成的实用化应用奠定了重要基础。

Databricks完成10亿美元K轮融资,估值突破1000亿美元

数据分析平台公司Databricks完成10亿美元K轮融资,公司估值超过1000亿美元,累计融资总额超过200亿美元。公司第二季度收入运营率达到40亿美元,同比增长50%,AI产品收入运营率超过10亿美元。超过650家客户年消费超过100万美元,净收入留存率超过140%。资金将用于扩展Agent Bricks和Lakebase业务及全球扩张。

上海AI实验室重磅发布:让AI看图“说人话“的神奇训练法,解决多模态AI与人类价值观对齐难题

上海AI实验室发布OmniAlign-V研究,首次系统性解决多模态大语言模型人性化对话问题。该研究创建了包含20万高质量样本的训练数据集和MM-AlignBench评测基准,通过创新的数据生成和质量管控方法,让AI在保持技术能力的同时显著提升人性化交互水平,为AI价值观对齐提供了可行技术路径。

AI发展的幕后支柱:HDD如何助力中国及亚太地区的数字愿景

字节跳动发布 Seedream 4.0 图像创作模型,豆包、即梦可免费体验

2025年第十七届厦门国际动漫节“金海豚奖”游戏产业赛道征集

菁彩Vivid助力电影行业高质量发展,四方战略合作签约仪式在京举行

Databricks完成10亿美元K轮融资,估值突破1000亿美元

Predoc获得3000万美元融资,扩展AI健康信息管理平台

Google正式公布Gemini使用限制详情

OpenAI推出Critterz动画电影,AI技术正式进军好莱坞

微软与Nebius签署近200亿美元AI基础设施合同

AI将在2030年前渗透所有IT工作——但不会取代所有IT岗位

AI工厂引领产业变革:芯片巨头如何重塑计算基础设施

谷歌法庭文件承认开放网络正"快速衰落"