解析浪潮AI计算产品GX4:性能强大,随需扩展 原创

至顶网服务器频道 09月29日 新闻消息: 9月25-27日,在GTC China 2017大会上,浪潮展示了基于Tesla? V100的AI计算产品GX4 Box,成为现场的"明星"产品。浪潮的GX4的吸引人之处到底何在呢?今天,我们就来详细剖析一下这款浪潮自主创新的AI计算新品。

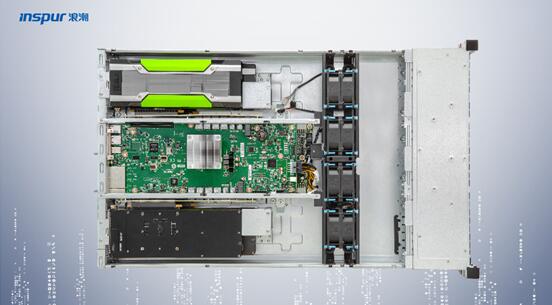

浪潮在GTC China 2017展出AI创新产品GX4

浪潮GX4并不是一台传统意义上的服务器产品,而是一台2U高度的AI box,其中没有CPU、内存,由4块GPU计算加速卡,扩展主板其他支撑部件组成。用户也可部署16块NVMe SSD硬盘替代计算加速卡,作为高密度热数据存储使用。

GX4承袭了浪潮SR-AI整机柜的设计理念,实现了CPU和GPU的物理解耦,使得计算加速单元能够以独立模块的形式进行灵活扩展。这种设计的好处显而易见,它能在保证高效的GPU跨节点通信效率的同时,以灵活的扩展形式敏捷支持不同级别的AI模型训练。有效降低IO冗余和系统购买成本,非常适合深度学习模型训练、科学计算、工程计算与研究领域的应用。

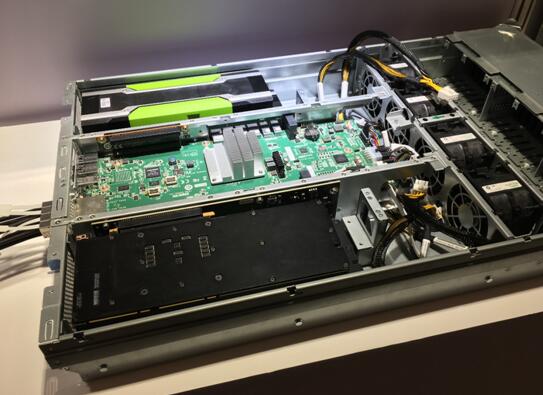

展区实拍浪潮GX4产品

随着训练样本量的指数级增长以及训练模型的复杂度不断提升,AI计算正面临的三大困扰。首先,不同应用需要不同硬件,带来采购和运维成本提升;其次,多机集群的延迟更高;第三,资源扩展不灵活、成本高。针对于此,GX4采用了一些创新的设计来解决这些困扰AI用户的难题。

灵活拓扑支持多类型AI应用需求

GPU与CPU计算资源的解耦和重构,让GX4拥有了更加多样的拓扑结构,可以通过灵活调整GPU拓扑,满足AI云、深度学习模型训练和线上推理等各种AI应用场景,使计算架构与上层应用更匹配,发挥出AI计算集群的最大性能。

目前,GX4可支持Balanced、Common、Cascaded三种不同的GPU拓扑结构。其中,云服务的用户需要做虚拟化,每个VM需要分配对应的GPU资源,为了保证VM的分配GPU的性能均衡性,需要采用Balance方式保证VM下GPU资源的性能均衡;Common模式和Cascaded模式均适合于深度学习模型训练使用,区别在于Common上行有两条X16链路,Cascade只有1条,但是Cascade P2P更优化,以上三种模式可以通过线缆来灵活调整拓补。

浪潮AI计算产品GX4

集群延迟降低50%以上

浪潮AI计算产品GX4能够实现极低的延迟。在传统的GPU集群中,比如单机4卡服务器组成的16卡集群,跨节点间的GPU通信会经过不同协议的转换,CPU、PCIe间的UPI或QPI以及网络的延迟,至少最早造成2us的数据传输延迟。而浪潮GX4能够实现16块GPU之间仅依赖PCI-E进行通信,延迟可降低50%以上,并且借助GPU Direct RDMA技术,使跨节点GPU与GPU实现直接的数据交互,而不再需要经由CPU的跳转,大幅降低跨节点GPU间的通信延迟,最终使GPU计算集群的延迟下降到ns级。

兼具高性价比和高扩展性

GX4组成的AI计算集群,由负责逻辑运算的SA5212M5机架式服务器和包含4块GPU卡的box组成,且单台SA5212M5能够挂接至少4台box。当业务需要更大的AI计算资源时,可以单独采购box来完成高性价比和高灵活性的扩展,最大可实现单物理集群16卡的资源扩展,单精度浮点运算能力最高可达192TFlops,成本可节省,000以上。

资源调配灵活

浪潮GX4组成的AI集群中,SA5212M5可以调用一台box中的1-4块GPU,也可以任意挂接1-4台box。当不同的业务部门有不同的配置需求时候,可以通过软件定义的形式灵活改变单物理集群的GPU卡数量,将资源调度最小颗粒度从服务器级升级为GPU卡级别。

支持多种数据中心环境

由于没有传统服务器架构中的CPU和硬盘等热源,浪潮GX4可以运行在不同的数据中心环境,并且冷风直接透过GPU散热,同样性能下功耗更低。此外,GX4 740mm的深度和传统的高密GPU服务器相比,外形更加小巧,为后部操作和维护提供足够的空间,而所有CPU和GPU通过箱子后部的线缆相连,也极大的方便计算空间的操作和运维。

总而言之,浪潮GX4是一款具有很强灵活性和扩展性的高性能GPU AI计算新品,能够很好的适应不同规模的深度学习模型训练和线上推理的需求以及不同类型AI应用对底层架构的要求,可谓是随需扩展神通广大的"金箍棒"产品。

好文章,需要你的鼓励

OpenAI与微软签署初步协议修订合作条款

OpenAI和微软宣布签署一项非约束性谅解备忘录,修订双方合作关系。随着两家公司在AI市场竞争客户并寻求新的基础设施合作伙伴,其关系日趋复杂。该协议涉及OpenAI从非营利组织向营利实体的重组计划,需要微软这一最大投资者的批准。双方表示将积极制定最终合同条款,共同致力于为所有人提供最佳AI工具。

如何让AI像电影配乐师一样创作完整的长篇音频故事——腾讯ARC实验室团队AudioStory突破性进展

腾讯ARC实验室推出AudioStory系统,首次实现AI根据复杂指令创作完整长篇音频故事。该系统结合大语言模型的叙事推理能力与音频生成技术,通过交错式推理生成、解耦桥接机制和渐进式训练,能够将复杂指令分解为连续音频场景并保持整体连贯性。在AudioStory-10K基准测试中表现优异,为AI音频创作开辟新方向。

国产R1人形机器人亮相,挑战特斯拉Optimus霸主地位

中国科技企业发布了名为R1的人形机器人,直接对标特斯拉的Optimus机器人产品。这款新型机器人代表了中国在人工智能和机器人技术领域的最新突破,展现出与国际巨头竞争的实力。R1机器人的推出标志着全球人形机器人市场竞争进一步加剧。

Meta与特拉维夫大学联手打造VideoJAM:让AI生成的视频动起来不再是奢望

Meta与特拉维夫大学联合研发的VideoJAM技术,通过让AI同时学习外观和运动信息,显著解决了当前视频生成模型中动作不连贯、违反物理定律的核心问题。该技术仅需添加两个线性层就能大幅提升运动质量,在多项测试中超越包括Sora在内的商业模型,为AI视频生成的实用化应用奠定了重要基础。

国产R1人形机器人亮相,挑战特斯拉Optimus霸主地位

智能化追踪研究:AI与人类智慧的融合

生命科学企业如何成功实施生成式AI

Microsoft 365 Copilot十月推出销售、服务、财务智能体套装

在线媒体品牌希望新协议能阻止未授权AI爬虫

Cisco收购Splunk后平台扩展显著加速

F5以1.8亿美元收购CalypsoAI强化AI安全能力

Storj推出媒体影视专用存储云服务Production Cloud

希捷豪掷超1亿英镑投资德里光子工厂押注AI数据中心

甲骨文收购Sun公司如何成就了今天的云计算巨头

Box推出智能体驱动的全方位内容管理平台

Oracle CTO:AI推理将超越AI训练成为主流