开箱 NVIDIA DGX Spark: 把一千万亿次算力,“塞进”ipad mini大小的盒子里 原创

几天前,一位在行业深耕多年的朋友问我:现在满市场都是AIPC,究竟什么样的机器,才配得上“生产力”引擎,而不只是把“本地端侧智能”当卖点?

这个问题的关键,并不仅在于某一代芯片性能是否足够强,更在于算力的组织方式是否发生了变化。过去二十年,计算资源不断向云端集中,个人设备逐渐退化为算力入口。但在大模型时代,这种结构开始显现出系统性张力——模型规模、数据私有性与推理频率,正在加速算力重新下沉。

AIPC的出现,解决了部分本地推理问题,却仍受限于显存规模、内存割裂和模型生命周期不可持续,难以形成完整的计算闭环。本质上,算力依然是被预设、被封装的。

真正的分水岭,或许不是“PC 能不能跑 AI”,而是——个人是否能够拥有可持续演进的AI计算系统,能在本地完成推理、微调与优化,并长期沉淀数据与模型资产。

从这个意义上看,是否“每个人都应该拥有一台 AI 超算”?

最近,我们正好拿到了一台不久前发布的NVIDIA DGX Spark——一台被压缩到桌面尺度的AI超算。

打开木质感的外包装,NVIDIA DGX Spark全金属的一体化机身便显露出来,表面经过细腻的香槟金阳极氧化处理,触感紧实,视觉质感高级且内敛。

机身“三围”是150mm x 150mm x 50.5mm,投影面积甚至比iPad mini还要小,但就是在这样紧凑的体积下,整机重量实打实地达到了1.2kg。上手的第一反应是非常“压手”,而这种“坠手感”直观地反馈了其内部极高的堆叠密度。

机身“前脸”覆盖着大面积的不规则的蜂窝状金属格栅结构,这一极具辨识度的工业设计,体现出独特工业美学张力。

从背后看,NVIDIA DGX Spark的接口非常丰富。

在供电与接口设计上,NVIDIA DGX Spark明显不是按“普通桌面级设备”的思路来设计的,机身背部的独立DC供电口,标配240W电源适配器,为整机在满负载状态下释放性能预留了足够余量。

外设接口同样充足,NVIDIA DGX Spark提供4个 USB Type-C接口用于连接各类外设,1个HDMI 2.1a可支持最高8K显示输出。

真正让这台设备具备“AI超算”气质的,是网络与高速互连能力。RJ-45万兆(10G)以太网口,可用于大模型权重与数据的高速传输。

同时NVIDIA DGX Spark还内置了NVIDIA ConnectX-7智能网卡,单卡带宽高达200Gbps。通过高速直连线缆,两台DGX Spark可以直接互联,构建成小型双节点系统,实现算力与显存资源的近线性扩展,而这曾经一度是服务器级集群互联的“玩法”。

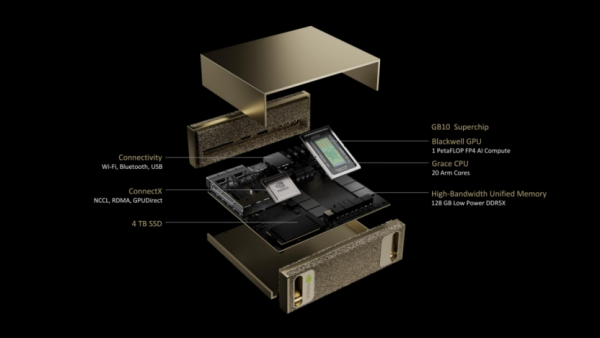

从性能上看,NVIDIA DGX Spark也拥有超强的“爆发力”,其搭载的NVIDIA Blackwell架构的GB10超级芯片。

GB10的CPU部分,搭载了专为数据预处理和AI任务优化的20核心ARM处理器。这颗CPU的核心调度策略采用“10+10组合”——10个Cortex-X925超大核,负责高负载的通用计算任务;10 个 Cortex-A725高能效核,负责处理后台进程和I/O 调度。

与之协同的,是基于 Blackwell架构的GPU核心。其集成了6144个Blackwell Generation CUDA 核心,搭载了第五代Tensor Core和第四代RT Core。

最令人惊艳的在于其张量性能(Tensor Performance):在 FP4精度下,这1.2kg的“小盒子”能爆发出的峰值算力高达1 PFLOP(此为基于 FP4精度并结合稀疏性加速的理论值)。这意味着其单机的理论性能,已经能够支撑起200B(两千亿)参数级别的AI推理任务,或70B(七百亿)级别的模型微调训练。

为了匹配这样的计算与互联能力,NVIDIA DGX Spark在存储I/O配置上标配4TB NVMe M.2 SSD,并支持自加密(Self-Encrypting),用于保护模型权重与数据资产的安全;网络侧除万兆以太网外,还支持Wi-Fi 7,覆盖从本地集群到无线办公的多种使用场景。

在如此激进的性能释放下,GB10芯片的TDP被控制在140W,整机满载功耗约240W。结合仅其紧凑的体积,NVIDIA DGX Spark给出了清晰的答案——桌面级AI计算不再只是靠堆功耗换算力,而是通过系统架构、内存模型和高速互连,把单位能耗下的有效算力密度推到新的高度。

对于LLM开发者而言,NVIDIA DGX Spark最具”爆发力”的能力,在于其配备128GB LPDDR5x统一系统内存。这套内存采用256-bit位宽,总带宽达到273 GB/s,由CPU与GPU 共享同一物理内存池。

与传统“CPU 内存+独立显存”的割裂架构不同,统一的内存从根本上绕开了24GB、48GB显存所形成的硬性上限。系统可以根据实际负载动态分配内存资源,模型参数、KV Cache,以及中间张量无需在 CPU内存与GPU显存之间反复搬运,不仅降低了内存拷贝带来的时延,也显著简化了大模型部署与调优的复杂度。

对开发者来说,这意味着可以在单机环境中承载更大的模型规模,并获得更稳定、可预测的推理性能。

回到最初的问题:什么样的机器,才配得上“生产力引擎”?

前文所拆解的,并不仅是DGX Spark的性能参数,更是整套计算范式的变化。从统一内存打破显存墙,到CPU与GPU在同一物理内存池内协同调度;从单机即可承载数百亿参数模型,到通过高速互连实现近线性的算力扩展。这些设计共同指向一个事实——AI计算正在从“被调用的资源”,转变为“可长期拥有、持续演进的系统”。

当模型可以在本地完成推理、微调与迭代,当数据与权重不再只是临时加载的消耗品,而是可以长期沉淀、不断增值的资产,计算设备本身的角色也随之发生改变——它不再是终端,而是个人级算力基础设施。

从这个意义上看,“每个人都应该拥有一台AI超算”或许是大模型时代对生产力工具提出的现实要求。

好文章,需要你的鼓励

至顶AI实验室硬核评测:HP Z2 Mini G1a工作站,仅30分钟还原毛利侦探事务所

真相只有一个:在AI与创意的交汇点上,HP Z2 Mini G1a确实是一台值得推荐的灵感引擎。

德国图宾根大学团队让2D材质预测瞬间“立体化“:MatSpray技术重新定义3D物体重光照

德国图宾根大学研究团队开发了MatSpray技术,能将2D照片中的材质信息准确转换为3D模型的物理属性。该技术结合了2D扩散模型的材质识别能力和3D高斯重建技术,通过创新的神经融合器解决多视角预测不一致问题,实现了高质量的材质重建和真实的重光照效果,处理速度比现有方法提升3.5倍。

我们希望AI有多智能?世界模型可能比我们更懂世界

近年来,AI学会了写作、生成图像、创建视频甚至编写代码。随着这些能力成为主流,研究重点转向更深层问题:机器能否真正理解世界运作方式?世界模型应运而生,从1950年代概念到2024年OpenAI的Sora、2025年英伟达Cosmos等突破性应用。与语言模型基于文本预测不同,世界模型专注预测环境变化,通过学习因果关系实现推理规划。在机器人、自动驾驶等物理AI领域前景广阔,但面临计算资源需求高、数据收集困难等挑战。

纽约大学发明“大脑翻译器“:让机器人读懂人类思维,精准操控语言AI

纽约大学研究团队开发出革命性"大脑翻译器"技术,首次实现用人类大脑活动模式精确控制AI语言行为。通过MEG脑磁图技术构建大脑语言地图,提取20个关键坐标轴,训练轻量级适配器让AI按人脑思维方式工作。实验证明该方法不仅能精确引导AI生成特定类型文本,还显著提升语言自然度,在多个AI模型中表现出良好通用性,为人机交互和AI可控性研究开辟全新路径。

至顶AI实验室硬核评测:HP Z2 Mini G1a工作站,仅30分钟还原毛利侦探事务所

冷板式液冷CDU系统

开箱 NVIDIA DGX Spark: 把一千万亿次算力,“塞进”ipad mini大小的盒子里

我们希望AI有多智能?世界模型可能比我们更懂世界

首席信息官角色将在2026年扩展的四种方式

Waymo正在测试Gemini在无人驾驶出租车中的车载AI助手功能

数据中心从幕后走向台前的转折之年

意大利要求Meta暂停禁止竞争对手AI聊天机器人使用WhatsApp的政策

让老旧Windows和macOS系统延续生命力

微软计划到2030年用Rust语言替换所有C和C++代码

2026年创客工具迎来重大升级,这些新技术值得期待

2025年十大网络故事盘点