Nvidia与Accenture合作率先推出定制的Llama大型语言模型

埃森哲近日宣布推出基于Nvidia新AI Foundry服务开发的Accenture AI Refinery框架。该产品旨在使客户能够使用 Llama 3.1 模型构建定制的大型语言模型,使企业能够使用自己的数据和流程完善和个性化这些模型,以创建特定领域的生成式 AI 解决方案。

生成式AI走向Nvidia AI Foundry的旅程

在一次简报会上,Nvidia公司AI软件副总裁Kari Briski表示,她经常被问及生成式AI相关的问题。

“这是一段旅程,是的,生成式AI是一项巨大的投资。企业会问,‘我们为什么要这样做?用例是什么?’当你想到员工生产力时,你是否希望自己一天有更多的时间?我知道我会的。也许如果有10个人,你可以完成更多的事情。这就是生成式AI的用武之地——自动执行重复、平凡的任务,例如总结、最佳实践和后续步骤。”

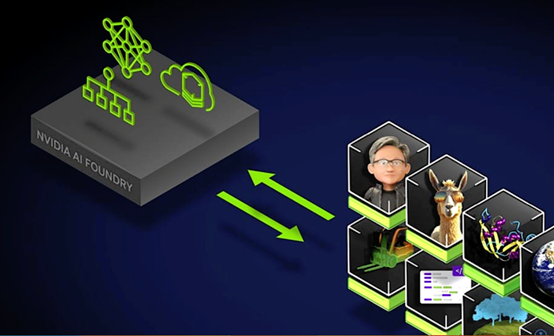

AI Foundry:全面的基础设施

“Nvidia AI Foundry是一项服务,使企业能够使用加速计算和软件工具,结合我们的专业知识来创建和部署可以为企业生成式AI应用增强的自定义模型,”Brisk说。

AI Foundry平台提供了用于开发和部署自定义AI模型的基础设施,包括:

- 基础模型:一套Nvidia和社区模型,包括Llama 3.1。

- 加速计算:DGX Cloud提供可扩展的计算资源,这对于大型AI项目来说至关重要。

- 专家支持:Nvidia AI Enterprise的专家协助开发、微调和部署AI模型。

- 合作伙伴生态系统:与埃森哲等合作伙伴的合作,为AI驱动的转型项目提供咨询服务和解决方案。

Brisk表示,一旦企业定制了模型,就必须对其进行评估。她指出,这正是一些客户陷入困境的地方。她提到了她从客户那里听到的一些话:“‘我的模型做得怎么样?我只是定制了它。它能做我需要的事情吗?’因此,NeMo为客户提供了多种评估方式,除了学术基准,你还可以上传自己的自定义评估基准,可以连接到第三方人工评估者生态系统,还可以使用大型语言模型来进行评判。”

行业采用

正如Brisk在简报中指出的那样,有几家公司正在使用AI Foundry,包括Amdocs、Capital One和ServiceNow。据Nvidia称,这三家厂商正在将AI Foundry集成到他们的工作流程中,而且他们通过开发结合行业特定知识的定制模型获得了竞争优势。

Nvidia NIM的优势

Nvidia的NIM具有Briski提及的一些独特优势。

她解释说:“NIM是一个通过标准API访问的定制模型和容器,这是我们多年工作和研究的成果。”她在Nvidia工作了八年时间,期间Nvidia也一直在研究它。

“它是基于云原生堆栈的,可以在任何GPU上开箱即用,其中涵盖了我们1亿多台Nvidia GPU的安装基数。有了NIM,你就可以非常快速地定制和添加模型。”

她补充说,NIM现在支持Llama 3.1,包括Llama 3.1 8B NIM(单GPU大型语言模型)、Llama 3.1 70B NIM(用于高精度生成)和Llama 3.1 405B NIM(用于合成数据生成)。

部署定制的大型语言模型

此外,埃森哲宣布与Nvidia合作开发AI Refinery框架,该框架是运行在AI Foundry上的。埃森哲表示,该框架推动了企业级AI领域的发展。该框架集成在埃森哲的基础模型服务中,承诺帮助企业开发和部署根据其需求量身定制的大型语言模型。据两家公司称,这个框架包括了四个关键要素:

- 领域节点定制和培训:这使企业能够使用自己的数据和流程来完善大型语言模型,从而提高模型对特定业务需求的相关性和价值。定制部门是运行在AI Foundry上的,让模型训练变得强大而高效。

- Switchboard Platform:使用户能够根据特定的业务环境或标准(例如成本和准确性)选择和组合模型。

- Enterprise Cognitive Brain:该组件会扫描和矢量化企业数据和知识,创建一个企业范围的索引,以增强生成式AI系统的能力。

- 代理架构:该架构旨在使AI系统能够自主运行,支持负责任的AI行为,同时最大限度地减少人工监督。

战略重要性和影响

埃森哲的AI Refinery框架有机会改变企业职能,从营销开始,然后扩展到其他领域,能够快速创建和部署针对特定业务需求的生成式AI应用,彰显了埃森哲对创新和转型的承诺。在向客户提供框架之前,埃森哲内部应用了该框架,展示了它所看到的潜力。

重塑企业

埃森哲董事长兼首席执行官Julie Sweet在公告中强调了生成式AI在重塑企业方面的变革潜力,强调了部署由定制模型驱动的应用以满足业务优先级和推动全行业创新的重要性。

此外,Nvidia公司创始人、首席执行官黄仁勋指出,埃森哲的AI Refinery将提供必要的专业知识和资源,帮助企业创建定制的Llama大型语言模型。

最后的一些想法

埃森哲推出的AI Refinery框架可能对企业采用和部署生成式AI至关重要。通过采用Briski在简报中大加赞赏的Llama 3.1模型和AI Foundry的功能,埃森哲使企业能够创建高度定制且有效的AI解决方案。

随着企业继续探索生成式AI的潜力,埃森哲AI Refinery等框架将在实现定制且有效的AI解决方案方面发挥关键的作用。

埃森哲与Nvidia之间的合作有望推动AI技术的进一步发展,为企业提供增长和创新的途径,也强调了所有AI道路都通向Nvidia。

好文章,需要你的鼓励

英伟达护城河难撼动,Gemini无法击败OpenAI

近期市场存在两种主流观点:英伟达的护城河因TPU等替代方案而受到侵蚀;谷歌及其Gemini模型将在AI搜索领域占据主导并击败OpenAI。研究显示这两种观点都被高估。英伟达的GB300和后续Vera Rubin将重塑AI经济学,凭借量产优势成为低成本生产商。谷歌面临创新者困境,将搜索转向聊天机器人体验会使查询服务成本增加100倍。OpenAI通过强调可信信息而非广告推送,正在颠覆现有在线体验模式,在企业市场获得更强地位。

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

IBM推出SAP迁移管理工具应对2027年系统升级截止期

博通AI硬件收入激增65%,VMware业务稳健增长

英伟达发布Nemotron 3开源模型助力可扩展多智能体系统

从AI到模拟对抗,网络安全桌面演练今年有了新变化

Equity 2026年预测:AI智能体崛起、重磅IPO与风投行业变革

英伟达护城河难撼动,Gemini无法击败OpenAI

山河为证,荣誉加冕,华为乾崑助传祺向往S9首次智行中国顺利收官

全国首批10城菁彩Vivid影厅启幕,《山河故人》重映见证影像新纪元

工业和信息化部人形机器人与具身智能标准化技术委员会成立大会暨第一次全体委员会议召开

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币