深入了解服务器液冷方式的多种选择

戴尔科技持续“以科技创新推动人类进步”的过程中,亦有障碍拖慢新的解决方案的应用。在数据中心层面,人工智能(AI)工作负载便是其中的最典型代表。AI和其他高要求的工作负载须使用最新的GPU和CPU来提供所需的应用性能,这意味着在部署规划过程中散热和功耗问题时常出现。为解决这些问题,戴尔科技的服务器散热工程团队多年如一,坚持提供以客户为中心的戴尔科技智能冷却(Dell Smart Cooling)创新解决方案,曾于2016年推出早期液冷服务器产品Triton。到2024年,戴尔科技提供的服务器冷却解决方案包括Verne Global正在使用的Dell DLC3000直接液冷机架、单机架功率高达115千瓦的戴尔科技模块化数据中心等。

当前的冷却选择

最新的CPU和GPU对冷却技术提出了新的要求,戴尔科技的PowerEdge产品组合支持不同的冷却方式。传统风冷在应对最新高功率服务器每个机架所产生的热量时颇显吃力,客户也正寻求以更加可持续且低功耗的方式运营数据中心。因此,如今的数据中心冷却方式和策略应能满足客户日益增长的多种冷却需求。

在构建数据中心冷却环境时最常用的技术包含以下几种:

- 直接液冷(DLC)使用冷板与CPU和GPU等内部服务器元件直接接触;然后依靠液体来冷却冷板并将热量从处理器中传递出去。

- 行内冷却解决方案设计用于部署在数据中心机架旁的通道中,以冷空气进行冷却并将其分配到精确位置。

- 背门散热(RDHx)通过安装在服务器机架后部的液冷式热交换器捕获服务器排出的热空气中的热量。

- 封闭式冷却指的是将热气封闭、冷却并循环,所有环节均与数据中心的任何其它冷却空气完全隔离。

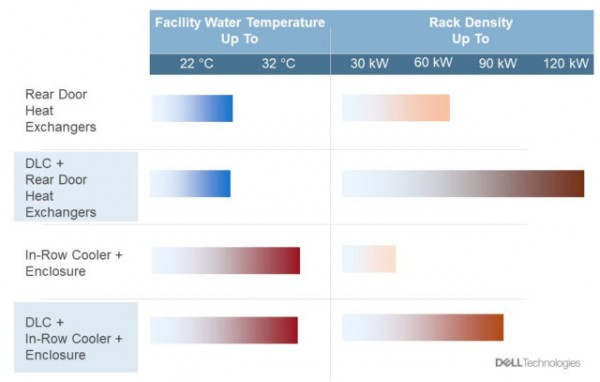

每种冷却技术支持的机架热密度和效率不同,为客户提供了多样的冷却方案匹配实际需求。这些解决方案的部署位置从单机架到多通道不等。结合行或机架封闭结构,行内冷却器可100%捕获机架上IT设备所产生的热量。如此一来,数据大厅内的空调部署就只需照顾到工作人员即可。RDHx同样也能捕获IT设备所产生的全部热量,用于机架上的设施水,并同时调节空间内的空气。由于这种空调式的功能,RDHx中设施水的水温必须比使用行内冷却器时更低,前者最高约为20℃,而后者最高可达32℃。采取较高的设施水温,能够降低冷却器的运行能耗,这一点虽然可喜,但冷却方案的整体效率并不止于此。

通过将这些热量捕获率可达100%的技术与DLC相结合,IT设备冷却所需的风扇功率得以降低,进一步提高了效率。

客户需求与戴尔科技建议的冷却解决方案

服务器冷却效率

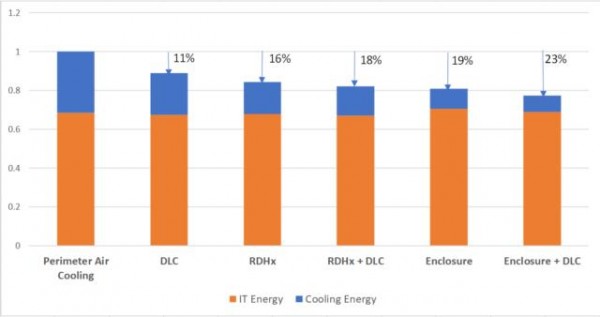

不同的解决方案和方式在冷却过程中所消耗的功率也不同。下图显示了在冷却典型的双CPU服务器机架时不同冷却方式的年能耗,分别包含了每种冷却方式的IT能耗和冷却能耗。IT能耗即包含内部风扇在内的服务器内部能耗总和;冷却能耗则代表服务器外部的冷却装置(如冷却剂分配单元,CDU和机房空气处理器,CRAH)和数据中心外部的风冷冷却器的能耗。

不同冷却方式的能耗

柱状图中第一根柱图表示的是典型数据中心的能耗情况,这种数据中心使用安装在数据大厅四周的空气处理器将空气吹向服务器。接下来,通过采用DLC来冷却每台服务器的CPU,可比仅使用周边空气处理器进行空气冷却节省约11%的总能耗。而如果用部署于每个机架上的RDHx取代周边冷却,则每年可减少16%的能耗,在此基础上再增加DLC可进一步减少2%的能耗。如上所述,如果将IT部署在带有行内冷却器的封闭式机柜内,则可使用温度较高的水,这也使得其能耗较周边空气处理器减少19%。最后,通过将封闭式冷却与DLC相结合,相较传统冷却机架可降低23%的能耗。

戴尔科技解决方案的优势

市场上有许多可供选择的冷却方式。例如一些厂商选择在其他内部服务器组件(如内存、网络接口、存储等)上使用直接液冷,让DLC解决方案触及服务器内部的几乎所有发热组件。通常情况下,这类解决方案需要定制化的铜制冷板并在服务器内部铺设额外的管道,使所有组件都与液体接触。在戴尔科技,昂贵且复杂的铜冷板冷却方式绝非最佳解决之道,将液体冷却和空气冷却同时加入到混合式服务器冷却解决方案中则可以给企业带来诸多优势:

- 服务器配置的灵活性显著提高。客户可自行决定服务器配置(内存、PCIe卡、存储等),而不必受制于某一种服务器冷板设计。

- 设计中的软管和接头数量大幅减少,降低发生泄露的概率。

- 现场服务程序简单,便于更换服务器组件。

- 服务器选择范围广泛。

戴尔科技的混合式冷却方式复杂性较低,能够在出现新的和不同的处理器和服务器平台时更加灵活迅速地为其提供冷却。

戴尔科技的内部模型分析表明,如果低水温解决方案的设计合理且管理完善,那么“风冷+DLC”混合冷却部署方式的冷却能耗仅比其他一些厂商使用的“全冷板冷却方式”高出3%-4%,并能够带来上述优势¹。

充分利用新一代智能冷却技术

戴尔科技延续其开放灵活的冷却策略,为客户提供具有多种选择,而非“一刀切”的冷却方式。目前,这些先进的数据中心冷却方式正在从高性能计算集群向主流部署发展,为支持AI和其他高强度工作负载的下一代顶尖性能服务器提供助力。戴尔科技的智能冷却解决方案已帮助许多PowerEdge客户提高了服务器的整体冷却能力、能效和可持续性。

来源:至顶网计算频道

好文章,需要你的鼓励

更高负载、更快建设:2026年数据中心六大趋势

随着人工智能和高性能计算持续推动需求增长,数据中心设计正以同样惊人的速度演进。曾经的高密度机架已成为标准配置,冷却系统在数月而非数年内完成重新设计,项目在各地区的规模和复杂性不断提升。全球工程设计咨询公司Black & White Engineering指出,液冷成为标准配置、极端机架密度管理、工业化规模交付、电网约束下的电力创新、AI驱动运营设计以及可持续性成为核心设计原则,将成为2026年塑造数据中心设计、建设和运营的六大关键趋势。

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

Snowflake数据库更新引发全球大规模服务中断

Snowflake本周推送的一次更新导致全球范围内的"重大故障",用户长达13小时无法查询数据、文件导入失败并收到错误信息。初步调查显示,最新版本引入了不向后兼容的数据库架构更新,导致版本不匹配错误。此次故障影响了全球23个区域中的10个,包括美国、欧洲和亚洲多个数据中心。这是Snowflake一周内第二次发生事故。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。