Groq的LPU将成为继NVIDIA GPU的又一“新宠”? 原创

几乎在你按下发送按钮的瞬间,大模型便以惊人的速度完成了回复的生成。这一次,Groq大模型以每秒500个token,彻底颠覆了GPT-4的40 tok/s的速度纪录!

Groq之所以“出圈”,缘于其惊人的速度,自称“史上最快大模型”!而让其冠绝大模型圈子的响应速度,来自驱动模型的新型AI芯片——LPU(Language Processing Units)。

Groq家的LPU“不走寻常路”

LPU旨在克服两大大语言模型(LLM)的瓶颈——计算密度和内存带宽。与GPU和CPU相比,LPU在处理LLM方面具有更大的计算能力。这减少了每个单词计算所需的时间,使文本序列能够被更快地生成。此外,消除外部内存瓶颈使得LPU推理引擎能够在性能上实现数量级的提升。

与专为图形渲染而设计的GPU不同,LPU采用了一种全新的架构,旨在为AI计算提供确定性的性能。

GPU采用的是SIMD(单指令多数据),而LPU采取了更为直线化的方法,避免了复杂的调度硬件需求。这种设计允许每个时钟周期都被有效利用,确保了一致的延迟和吞吐量。

简单来说,如果把GPU比作一支精英运动队,每个成员都擅长处理多任务,但需要复杂的协调才能发挥最佳效能,那么LPU就像是一支由单一项目专家组成的队伍,每个成员都在他们最擅长的领域中以最直接的方式完成任务。

对于开发者而言,这意味着性能可以被精确预测和优化,这在实时AI应用中至关重要。

在能效方面,LPU也展现出其优势。通过减少管理多线程的开销并避免核心的低效利用,LPU能够以更低的能耗完成更多的计算任务。

Groq还允许多个TSP无缝连接,避开了GPU集群中常见的瓶颈问题,实现了极高的可扩展性。这意味着随着更多LPU的加入,性能可以线性扩展,简化了大规模AI模型的硬件需求,使开发者能够更容易地扩展他们的应用,而无需重新架构系统。

举例来说,如果把GPU集群比作一座由多条桥梁连接的岛屿,尽管可以通过这些桥梁访问更多的资源,但桥梁的容量限制了性能的提升。而LPU则像是设计了一种新型的交通系统,通过允许多个处理单元无缝连接,避免了传统瓶颈问题。这意味着随着更多LPU的加入,性能可以线性扩展,大大简化了大规模AI模型的硬件需求,使得开发者能够更容易地扩展他们的应用,而无需重新架构整个系统。

快如闪电的Groq到底好不好用?

尽管LPU的创新举措令人瞠目,但对于通用大模型而言,好不好用才是关键。

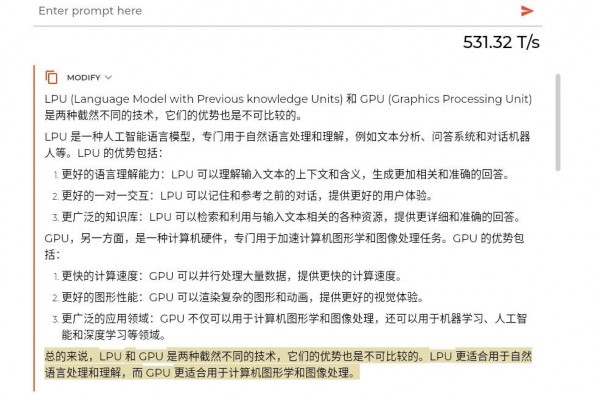

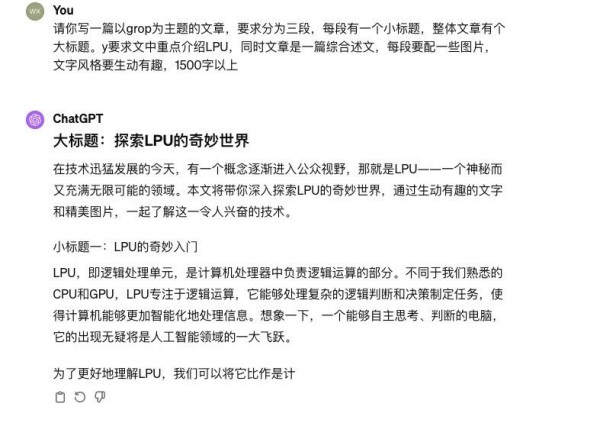

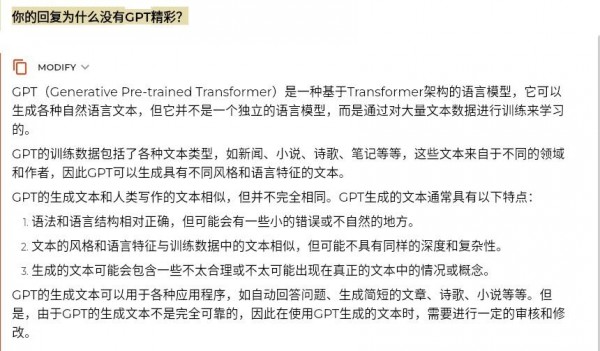

我们对于chatGPT和Groq 提出了相同的需求,且没有经过二次对话。

不论内容正确与否,单从语言风格上看,从两款模型给出的反馈不难发现,Groq 的回复一板一眼有些生硬,很浓的“AI味”,而chatGPT则相对自然,对于人类语言(中文)习惯的“领悟”更加透彻。

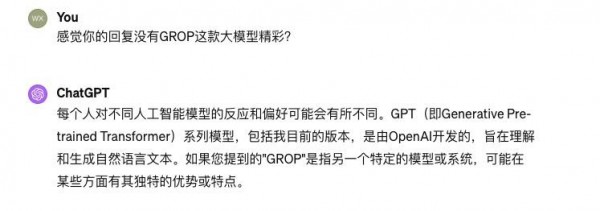

接着我们又问了几乎同样的问题,它们的回答这这样的:

GPT的语言风格把“人情世故”吃的透透的,而Groq依旧是“AI味”浓厚。

能不能取代英伟达的GPU?

伴随着Groq极速狂飙的同时,出现了一票声音——英伟达的GPU是否已经落后了?

然而,速度并不是AI发展的唯一决定性因素。在讨论大型模型推理部署时,7B(70亿参数)模型的例子很能说明问题。

目前,部署这样一个模型大约需要14GB以上的内存。以此为基础,大概需要70个专用芯片,每个芯片对应一张计算卡。如果采用一种常见的配置,即一个4U服务器装载8张计算卡,那么部署一个7B模型就需要9台4U服务器,几乎占满了一个标准的服务器机柜。总共需要72个计算芯片,这样配置下的计算能力在FP16模式下达到了惊人的13.5P(PetaFLOPS),而在INT8模式下更是高达54P。

以英伟达的H100为例,其拥有80GB的高带宽内存,可以同时运行5个7B模型。在FP16模式下,经过稀疏化优化的H100的计算能力接近2P,在INT8模式下则接近4P。

一位国外的博主作了对比,结果显示:以INT8模式进行推理,使用Groq的方案需要9台服务器。而9台Groq服务器的成本远高于2台H100服务器。而Groq方案的成本超过160万美金,而H100服务器的成本为60万美金,这还未包括机架相关费用和电费开销。

对于更大的模型,如70B参数模型,使用INT8模式可能需要至少600张计算卡,接近80台服务器,成本更是天文数字。

事实上,于Groq的架构来讲,或需要建立在小内存,大算力上,让有限的被处理的内容对应着极高的算力,导致其速度非常快。

而对于部署推理能力的大模型,性价比最高的,依旧是英伟达的GPU。

好文章,需要你的鼓励

亚马逊推出Alexa网页版:生成式AI助手的新选择

亚马逊在CES期间宣布推出Alexa.com网站,用户可像使用其他AI聊天机器人一样与Alexa交互。经过数月早期体验,Alexa+已获得数千万用户。新网站支持语音和文本交互,需登录使用以确保跨设备功能连续性。76%的Alexa+交互为独特任务,包括智能家居控制和第三方集成。Alexa+兼容七年来的设备,正式版将收费每月20美元或包含在Prime会员中。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

AI笔记公司Plaud在CES 2026推出新款可穿戴设备NotePin S,可夹在衣领、戴在手腕或挂在脖子上记录对话。该设备通过蓝牙连接手机,配备双麦克风,录制范围约3米,支持一键高亮标记重要时刻。同时发布的还有Plaud Desktop桌面AI记录工具,可原生捕获线上会议内容,无需机器人加入通话。两款产品将所有笔记、会议和对话整合到统一平台管理。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

亚马逊推出Alexa网页版:生成式AI助手的新选择

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

机器人初创公司推出现实版瓦力机器人及其他伴侣产品

VisIC宣布完成2,600万美元B轮融资

CES 2026 | AMD扩张“边缘统治力” “芯片级异构”塑造汽车、工业边缘应用“新法则”

CES 2026 | NVIDIA新风向: Rubin平台面市 ,系统级“AI工厂”成型,物理AI加速落地

英伟达Vera-Rubin平台推出前六月已淘汰现有AI硬件

英特尔推出首批18A工艺制程的Core Ultra处理器

Rokid在CES 2026推出无屏AI智能眼镜

英伟达物理AI模型为新一代机器人铺路

微软发布 GitHub Copilot 的 C++ 代码编辑工具

至顶AI实验室硬核评测:戴尔Precision 5690移动工作站,部署DeepSeek+LobeChat打造个人超级智能体

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币