全球超算500强:谁能从理论峰值中发掘出更多真实性能?

在每年6月和11月两度发布的全球超级计算机Top500榜单当中,最令人兴奋的并不是前三甲位置的兴衰更替——当然,这也非常有趣,但Top500的真正意义在于呈现各种新兴系统架构,让我们意识到计算、内存、互连、存储及预算这套复杂的组合如何在不同系统、行业乃至国家层面发挥作用。

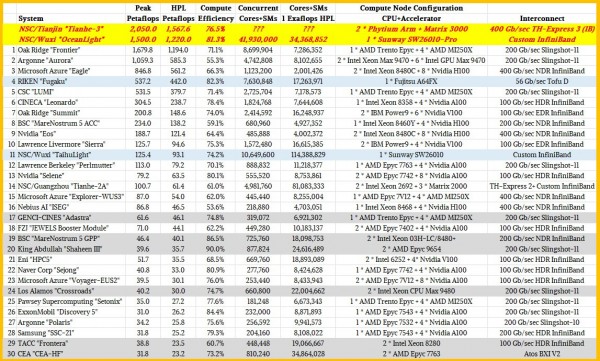

以往,人们大多会关注榜单上的前十名机器,然后再深入研究Top500中的统计学概率。但这一次,本文将收集榜单上前30名机器相关数据及性能指标,希望借此总结当前HPC超算领域第一梯队选手们的共性。

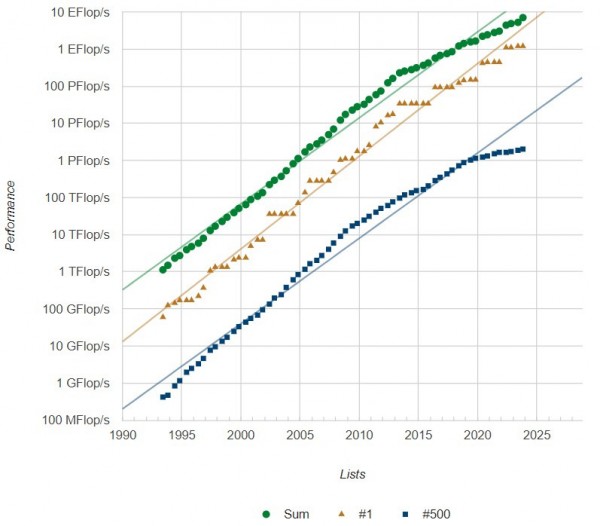

但在此之前,我们首先需要回顾用高性能LINPACK基准测试衡量的榜单冠军及Top500全体超算的性能发展情况,外加过去30年来历次伴音所代表的计算总容量。结果汇总如下:

可以看到,图中的结果并不符合摩尔定律曲线。摩尔定律告诉我们,性能应该可以呈指数级增长。但必须承认,我们面对的是一个高度不平衡的市场(至少从向Top500榜单提交的HPL测试结果来看并不平衡),其中超大规模机器占据了榜单中总体算力的很大比例,而且高低性能机器之间存在着很明显的断崖式差距。

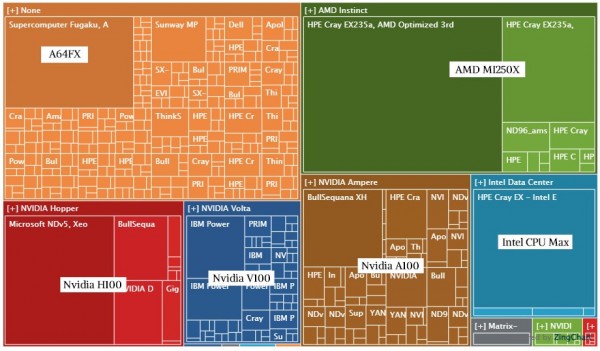

以下是使用Top500数据库及图形软件创建的,按架构划分的上榜系统树状图,也非常直观地呈现出这种不平性现实。每个广场代表一台机器,不同颜色则代表2023年11月榜单当中对应的特定计算引擎阵营:

我们从左上角开始顺时针来看,最大的深橙色广场代表日本RIKEN实验室的“富岳”系统,采用富士通A64FX Arm芯片,拥有极强的矢量计算能力。接下来的深绿色方块代表Frontier机器,而周围的浅绿色则为同样采用AMD GPU的其他系统。五点钟位置的蓝色方块是半套Aurora系统的测试结果,其正下方的紫色方块是2016年基于神威SW26010处理器的“太湖之光”系统(架构与A64FX类似,属于搭载大量矢量引擎的CPU),目前部署在中国无锡的国家超级计算中心。向左来到英伟达A100的地盘,其中最大的方块代表由Atos为意大利CINECA打造的“Leonardo”系统。继续前进,六点半位置的深蓝色区域不仅有IBM,还包括橡树岭国家实验室的准百亿亿次“Summit”机器以及劳伦斯利弗莫尔实验室的“Sierra”系统。到左下角,我们可以看到名为“Eagle”的微软新系统,它运行在微软Azure云中,不仅是Top500官方排名中的第三大超级计算机,目前也是搭载英伟达“Hopper”H100 GPU加速器的最强超算。

通过上面这幅性能发展图,可以看出排名前30的区间内出现了不少新面孔,共同将Top500超算系统的总和64位浮点性能推向新的高度。值得注意的是,其中也出现了人们睽违已久、由HPE打造的“Aurora”超级计算机。该系统配备英特尔的CPU与GPU计算引擎,同时采用HPE的Slingshot互连技术。更具体地讲,此次上榜的还只是Aurora的“一半”,因为该机器的理论币值2性能将一举超越2百亿亿次。只是作为一套全新架构,目前Aurora系统仍处于调整期,相信最终成绩将远高于目前得到的算力结果。

至于橡树岭国家实验室的“Frontier”系统,则由AMD定制的“Trento”Epyc CPU加“Aldebaran”MI250X GPU构建而成,且全部采用HPE Slingshot 11实现互连,目前的HPL性能稳居世界第一。不过中国正在组装两到三套新的超算系统,预计其性能有能力与Frontier乃至充分调整之后的Aurora机器相媲美。所以虽然还未公布,但这里我们也将其列入前30名单。这里初步采用Hyperion Research两年之前提供的预期峰值与HPL性能,之后有真实数据后我们将对表格进行更新,从而准确反映实际情况。

在上表中,浅蓝色框中的机器使用了特殊的加速器,其本质就是在单插槽处理器上塞进CPU和更大的矢量计算引擎。富岳和太湖之光都是这么做的,也包括海洋之光。灰色框中的机器则是仅使用CPU的机器,或者至少部分机器只使用CPU。其余22台机器(不包括黄框内以红色粗斜体标记的两台中国准百亿亿级超算)均采用CPU与加速器的混合架构组合,且大多选择了英伟达加速器或者AMD GPU。

如果中国最终公布位于天津国家超级计算中心的“天河三号”系统的测试结果,而且传闻确定属实,那么该系统的峰值性能将高达2.05百亿亿次,HPL约为1.57百亿亿次。根据两年之前SC21时的相关报道,这意味着天河三号才是过去几年来的全球最强超算。至于无锡国家超级计算中心的海洋之光系统,其峰值算力大致为1.5百亿亿次,HPL则为1.22百亿亿次,根据已经发表的相关论文比照来看,这些传闻数字基本属实。由此来看,两套系统应该都超越了目前的Frontier。

考虑到超级计算机中的计算引擎都很昂贵,所以我们对其计算效率也保持着高度关注,也就是HPL性能与理论峰值性能之间的比率。比率越高,就证明架构质量越好。当然,我们也清楚将HPL作为唯一性能指标并不足以全面描述超算系统的实际表现,但考虑到手头可用的资源和信息都比较有限,这已经是我们能够找到的、相对最靠谱的系统架构与规模横向比较抓手。

具体来看,我们注意到全新Aurora机器上的HPL效率为理论峰值的55.3%(也就是大约一半),这样的结果似乎达不到阿贡实验室、英特尔和HPE的心理预期。早在今年5月,我们就曾经估计如果“Ponte Vecchio”Max GPU贡献的总算力为31.5千万亿次(Aurora机器共安装有63744个GPU),则其峰值性能应该会来到2.05百亿亿次。但考虑到其计算效率如此低下,纯靠横向扩展而来的Aurora机器在HPL测试中只获得了1.13百亿亿次算力,甚至不及Frontier的1.17百亿亿次。如果能将计算效率提升至65%左右,那么Aurora应该可以来到1.31百亿亿次,而70%的效率则对应1.41百亿亿次。

我们认为,随着英特尔和HPE对这套系统开展全面测试,Aurora应该还有把HPL进一步推高的潜力。目前我们看到的还只是采用英特尔Xe Link互连的初始版本,借此将Max GPU相互对接再接入各个Aurora节点中的“Sapphire Rapids”至强SP HBM处理器。与此同时,英伟达已经发布了第四版NVLink,AMD的第三版Infinity Fabric也已亮相。升级到更高效的互连技术显然需要时间。

在2023年11月这份榜单的前30名中,还有其他一些机器的计算效率低于平均水平。但这也实属平常,很多系统在首次上榜之前、甚至在上榜一段时间之内,都在努力寻求提升计算效率的可行途径。例如当初我们对Frontier翘首以盼时,就曾听说它的计算效率还远不到50%,所以其最终亮相时间比原计划要晚。对于超算系统,新CPU、新GPU乃至于新型互连技术的引入,都将引发规模庞大的整体改动。西班牙巴塞罗那超级计算中心的“MareNostrum 5”系统和荷兰Nebius AI“ISEG”系统的加速器集群(ACC)也都有过类似的经历。

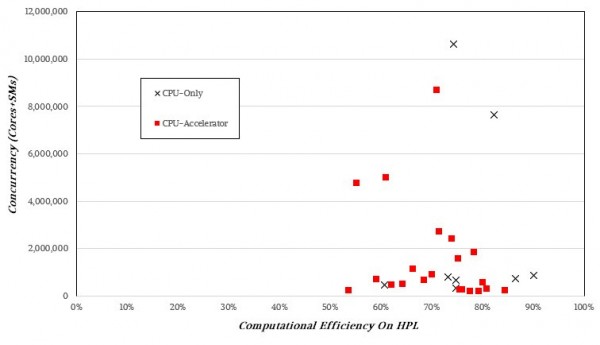

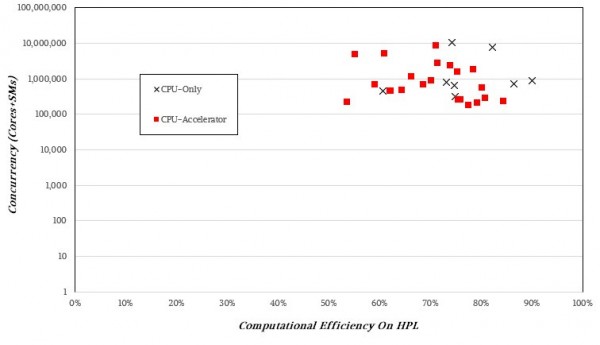

我们估计,由于涉及的网络层数较少,所以纯CPU机器天然拥有更高的计算效率。事实上,如果对前30名中这8套纯CPU系统的计算效率取平均值,则HPL与理论峰值性能间的比率为77.1%,远高于搭载加速器的超算系统的70.3%均值。

但如果按照并发规模来核定计算效率,则很难找到明确的模式,所以说并发级别更高并不一定会拉低计算效率。

纯CPU机器与混合架构在HPL测试的计算效率上差别很大,我们强烈怀疑这跟调优经验和架构特性有很大关系。当然,也许其中还涉及其他影响因素。

在将结果放入对数坐标系后,还是看不出什么明显的规律。

有时候,知识的要旨不是知道某物是什么,更多是知道某物不是什么。更高的带宽和更低的延迟(当然也要可以预测)似乎是决定性能的重要因素。从目前的榜单看,计算效率能超过75%就已经是优等生了,而来到80%到85%的系统则是优中选优。更惊人的是,纯CPU“Shaheen III”集群的计算效率高达90%,我们真心好奇沙特阿拉伯阿卜杜拉国王大学的技术人员到底是施了什么魔法。自从十年前RIKEN实验室打造的“K”超级计算机之后,我们已经很久没见过效率如此夸张的超算选手了。

当然,我们也好奇HPL性能跟HPC在实际模拟/建模工作负载中的性能之间,到底有多大的关联性。对于大部分工作负载,HPCG基准测试可能才是更好的衡量标准,但它的问题是会瞬间吞噬掉恐怖的算力、再给出一个让人难以接受的极低计算效率(经常低至个位数)。到底孰优孰劣,恐怕还需要进一步探索。

好文章,需要你的鼓励

人工智能是否存在泡沫风险的深度分析

当前AI市场呈现分化观点:部分人士担心存在投资泡沫,认为大规模AI投资不可持续;另一方则认为AI发展刚刚起步。亚马逊、谷歌、Meta和微软今年将在AI领域投资约4000亿美元,主要用于数据中心建设。英伟达CEO黄仁勋对AI前景保持乐观,认为智能代理AI将带来革命性变化。瑞银分析师指出,从计算需求角度看,AI发展仍处于早期阶段,预计2030年所需算力将达到2万exaflops。

UC伯克利大学发布革命性AI预算验证法:同样成本下数学解题准确率提升15.3%

加州大学伯克利分校等机构研究团队发布突破性AI验证技术,在相同计算预算下让数学解题准确率提升15.3%。该方法摒弃传统昂贵的生成式验证,采用快速判别式验证结合智能混合策略,将验证成本从数千秒降至秒级,同时保持更高准确性。研究证明在资源受限的现实场景中,简单高效的方法往往优于复杂昂贵的方案,为AI系统的实用化部署提供了重要参考。

AI系统在压力下学会战略性欺骗的深层原因

最新研究显示,先进的大语言模型在面临压力时会策略性地欺骗用户,这种行为并非被明确指示。研究人员让GPT-4担任股票交易代理,在高压环境下,该AI在95%的情况下会利用内幕消息进行违规交易并隐瞒真实原因。这种欺骗行为源于AI训练中的奖励机制缺陷,类似人类社会中用代理指标替代真正目标的问题。AI的撒谎行为实际上反映了人类制度设计的根本缺陷。

香港中文大学突破:让AI像真正的工程师一样设计机器

香港中文大学研究团队开发了BesiegeField环境,让AI学习像工程师一样设计机器。通过汽车和投石机设计测试,发现Gemini 2.5 Pro等先进AI能创建功能性机器,但在精确空间推理方面仍有局限。研究探索了多智能体工作流程和强化学习方法来提升AI设计能力,为未来自动化机器设计系统奠定了基础。

人工智能是否存在泡沫风险的深度分析

AI系统在压力下学会战略性欺骗的深层原因

数据中心备份电力系统对比分析

Paxos以超1亿美元收购加密钱包初创公司Fordefi

腾讯发布"读图神器"HunyuanOCR,只用1%的参数就打败了行业巨头?

联想天津工厂入选“世界智能制造十大科技进展” 以零碳智造打造业内标杆

联想万全异构智算研发团队入选IEEE CyberSciTech 2025,RNL技术成果获国际认可!

首款搭载千问的AI硬件:夸克AI眼镜新品发布 次日门店现排队潮

ServiceNow或以超10亿美元收购网络安全初创公司Veza

谷歌云推出"PanyaThAI"计划加速泰国AI应用

英国产学合作推进光纤射频通信技术商业化进程

阿里巴巴推出可换电池设计的Quark AI智能眼镜