英特尔Innovation 2023:核心主题,唯有创新

英特尔正凭借至强等一系列处理器产品重回巅峰。

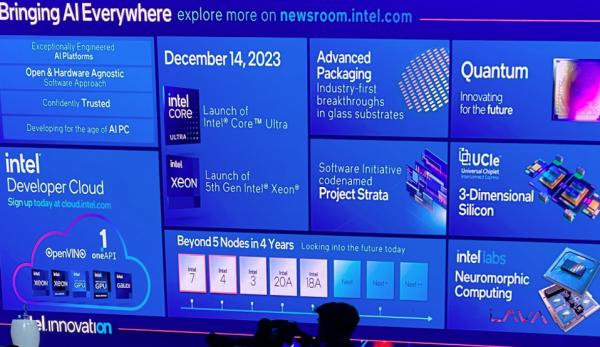

在本届英特尔Innovation创新大会上,芯片巨头正全力聚焦AI科技。会上,英特尔CEO Pat Gelsinger给出了我们迄今为止看到过的,关于AI如何为日常生活提供支持的最完整的发展愿景。

AI已经无处不在,相信很多朋友都已经感受到了这股力量的崛起。但具体要如何落地,我们可能需要结合AI在日常场景中的演示才能体会到其能量。Innovation主题演讲期间,Gelsinger就多次将这个抽象概念转化为现实,从AI驱动型“智能”且听器到帮助生物科技公司更快、更便宜、更准确地开展研究,这届以“AI无处不在”为主题的英特尔Innovation 2023确实给我们留下了深刻印象。

英特尔创新引擎已经回归

几周之前,我们曾经发文就Hot Chips放出的消息介绍了英特尔最新动态。而Innovation大会则更进一步,将这些动态与更宏观的AI背景联系起来。

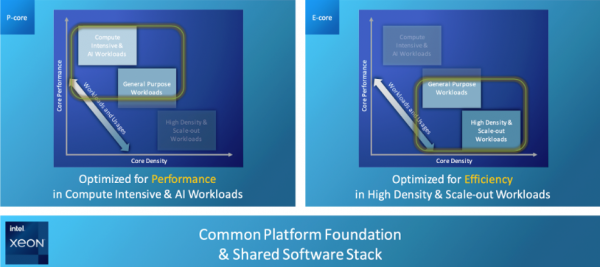

在Hot Chips上,英特尔公司透过了其下一代(即第五代)至强系列处理器的更多细节。对于这个声名显赫的产品家族,英特尔将在同一通用计算复合体上提供两种不同核心。首先是Granite Rapids,搭载英特尔的性能核(P核),旨在满足企业客户运行分析、电子设计自动化(EDA)、HPC、AI等高性能工作负载的需求。

其二则是Sierra Forest,采用至强能效核(E核),专为横向扩展所设计,重点关注每瓦性能。围绕此架构设计的服务器主要用于支持虚拟化和云原生类工作负载,相信能够在AWS、微软Azure、Google Cloud Platform和Oracle Cloud Infrastructure等云服务商的超大规模基础设施中找到不少受众。

Granite Rapids和Sierra Forest可全方位满足各类计算需求。

在Hot Chips上,英特尔还公布了Granite Rapids和Sierra Forest的设计规格。虽然关于Granite Rapids的细节还很模糊,但英特尔强调Sierra Forest的每个插槽可容纳144个核心,意味着该芯片的核心数量将高于AMD Bergamo(128核心),但低于Ampere在AmpereOne上提供的192核心。

时间快进三周,英特尔在Innovation 2023上带来了更多惊喜。官方确认Sierra Forest芯片最多可支持288核心,而非144核。于是Sierra Forest不仅是成功领先于AMD和Ampere,而且是遥遥领先。虽然关于性能、功耗、I/O等指标还有很多不明之处,但公布的成果仍然堪称震撼人心。仅用了一次迭代的时间,英特尔公司就在核心数量的军备竞赛中从落后者变成了领先者。

Sierra Forest的公告也回应了我们对英特尔重新回归创新巅峰的期待,而且更直接的体现应该在该公司推出的Sapphire Rapids第四代至强处理器这边。虽然这款CPU由于制造问题而被推迟,但英特尔在设计中引入了新颖方法。它没有选择与竞争对手展开“核心竞赛”,而是专注于在计算复合体中作为独立引擎以推动工作负载加速。这是一项相当明智的战略,随着英特尔奋力缩小核心数量/核心性能的差距,至强将在市场上获得更强大的竞争地位,并在Granite Rapids这代芯片中完成临门一脚。

驱动“芯片经济”需要的不仅仅是芯片

在主题演讲当中,Gelsinger创造了“芯片经济”一词,指的是技术对于现代经济的驱动作用。在他看来,这标志着当前全球经济驱动力已经与过去几十年出现了显著区别。

但芯片经济所关注的绝不仅仅是芯片,也不是为高级工作负载设计的CPU、GPU和其他定制芯片。其中涉及支持软件生态系统的一切芯片和基础设施——包括语言、模型、框架和部署等各种元素。最后,它让架构师和开发人员能够根据自己的特定需求试验、构建和优化AI。

在今年的Innovation大会上,英特尔宣布将全面推出Intel Developer Cloud,这是一个专为上述用例而生的虚拟实验室。在这套功能齐全的环境中,开发人员可以在全系英特尔技术(CPU、GPU、FPGA以及英特尔全套软件库与工具)之上构建、测试并高速以数据为中心的各类应用。

英特尔提供各种元素,帮助客户乘上“芯片经济”东风。

除了Developer Cloud之外,英特尔还展示了其对AI无处不在前景的全面支持——从CPU到制造,再到UCIe(在同一芯片上支持不同厂商元件间的互连)和玻璃晶圆。即使对于长期关注半导体行业的分析师,要想完全理解英特尔在芯片级别完成的所有工作和支持AI等复杂工作负载的研发进展,仍然不是件容易的事情。更遑论本届大会上还发布了平台、工具、软件和数据等上游(或栈上)需求,以及这些需求将如何反过来影响芯片设计。总而言之,英特尔在推动AI进入各个领域方面所做出的努力着实令人印象深刻。

借“芯片经济”大势化敌为友

目前的AI环境当中,存在各种专用型硬件支持训练(机器学习)和推理环境。虽然英特尔已经掌握着能够满足AI技术栈中各类具体需求的解决方案,但组织客户往往会使用不同的技术模块来搭建适合自己的性能与成本配置组合,包括使用其他厂商的CPU和加速器。于是乎,训练环境往往与推理环境完全不同,具体元素的排列组合也将无穷无尽。

但这就是我们生活的世界。虽然英特尔、AMD、英伟达、Ampere及其他Arm厂商都在积极争夺市场份额,但互操作性和开放标准仍然在逐步形成,也只有这样才能让客户放心大胆地予以采用。芯片经济体量庞大、而且正在呈指数级增长,相信每家厂商在其中都将拥有自己的生存空间。

写在最后

英特尔Innovation大会已经闭幕,也让我们对于芯片巨头打算如何在数据中心的设计的构建领域重回巅峰有了新的认识。最近一段时间,英特尔公司已经在全球芯片制造领域投入1000亿美元,新厂遍及俄勒冈州、亚利桑那州、新墨西哥州和俄亥俄州。

但各位竞争对手也绝不会退缩。AMD正通过EPYC发布一代又一代处理器产品,Ampere凭借Altra和AmpereOne带来强劲表现。这场激烈的对抗帮助英特尔巩固了自身实力,加快了创新引擎的重启。最终,这一切将给每个人带来助益,既包括开发者和数据科学家、也包括每一位在日常生活中或多或少接触到AI的普通民众。竞争吧,合作吧,共同塑造新的AI时代吧!

好文章,需要你的鼓励

亚马逊推出Alexa网页版:生成式AI助手的新选择

亚马逊在CES期间宣布推出Alexa.com网站,用户可像使用其他AI聊天机器人一样与Alexa交互。经过数月早期体验,Alexa+已获得数千万用户。新网站支持语音和文本交互,需登录使用以确保跨设备功能连续性。76%的Alexa+交互为独特任务,包括智能家居控制和第三方集成。Alexa+兼容七年来的设备,正式版将收费每月20美元或包含在Prime会员中。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

AI笔记公司Plaud在CES 2026推出新款可穿戴设备NotePin S,可夹在衣领、戴在手腕或挂在脖子上记录对话。该设备通过蓝牙连接手机,配备双麦克风,录制范围约3米,支持一键高亮标记重要时刻。同时发布的还有Plaud Desktop桌面AI记录工具,可原生捕获线上会议内容,无需机器人加入通话。两款产品将所有笔记、会议和对话整合到统一平台管理。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

亚马逊推出Alexa网页版:生成式AI助手的新选择

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

机器人初创公司推出现实版瓦力机器人及其他伴侣产品

VisIC宣布完成2,600万美元B轮融资

CES 2026 | AMD扩张“边缘统治力” “芯片级异构”塑造汽车、工业边缘应用“新法则”

CES 2026 | NVIDIA新风向: Rubin平台面市 ,系统级“AI工厂”成型,物理AI加速落地

英伟达Vera-Rubin平台推出前六月已淘汰现有AI硬件

英特尔推出首批18A工艺制程的Core Ultra处理器

Rokid在CES 2026推出无屏AI智能眼镜

英伟达物理AI模型为新一代机器人铺路

微软发布 GitHub Copilot 的 C++ 代码编辑工具

至顶AI实验室硬核评测:戴尔Precision 5690移动工作站,部署DeepSeek+LobeChat打造个人超级智能体