AMD这一把算是把AI玩明白了 原创

AMD已经不止一次使用“together we advance_”这个前缀作为主题,希望可以在各个层面都可以实现“同超越,共成就_”。

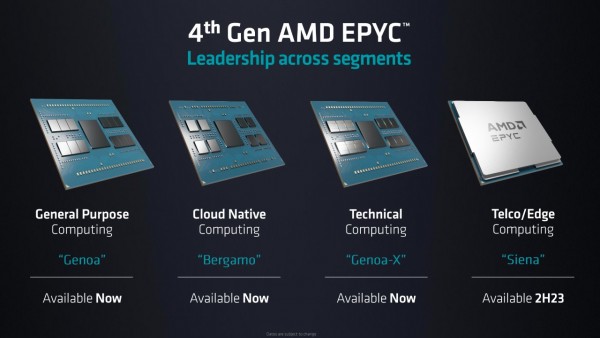

自2017年AMD回归数据中心处理器,到去年已经提供了第四代AMD EPYC(霄龙)处理器,帮助云、企业和高性能计算等关键应用负载。今年,AMD首席执行官苏姿丰(Lisa Su)也没有让我们失望,抢先带来了包括CPU和GPU在内的一系列更新。

迎来专注云原生的Bergamo

2022年,AMD发布了Zen 4架构的AMD EPYC处理器“Genoa”,Genoa在市场上一直有良好的表现,云工作负载中的性能是竞品处理器的1.8倍,企业工作负载中的速度是竞品处理器的1.9倍。

从2018年开始,亚马逊云科技就与AMD展开了合作,这次亚马逊云科技不仅展示了AMD实例在成本和性能上的优势,同时还宣布正在使用AWS Nitro和第四代EPYC Genoa处理器构建新实例Amazon EC2 M7a,目前Amazon EC2 M7a实例已经提供预览版,性能比M6a实例高出50%。AMD也会使用Amazon EC2 M7a实例处理内部的工作负载,包括芯片设计 EDA软件等。

今年,AMD在计算基础设施上又针对数据中心工作负载进行了优化,因为越来越多的应用都是云原生,AMD也带来了以吞吐量为导向,拥有最高终端密度和效率的AMD EPYC 97X4处理器“Bergamo”。

如果说Genoa是专注于通用的工作负载,Bergamo则专注于云服务器和数据中心,适用于云原生工作负载。

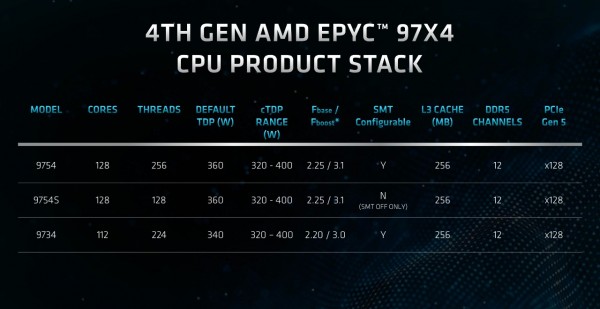

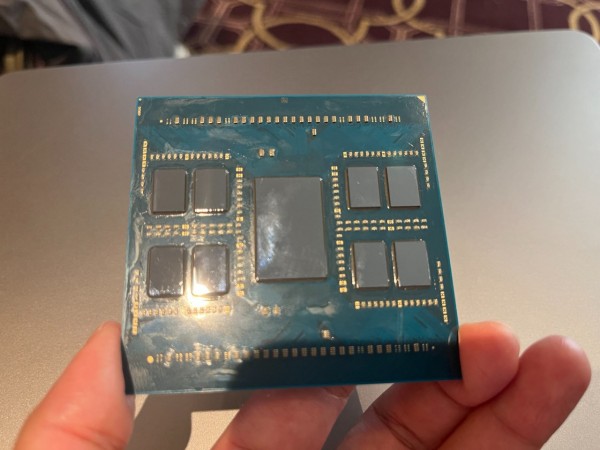

AMD EPYC Bergamo有高达128个内核,每个插槽有多达256个线程,一个普通的2U 4节点平台将有2048个线程。其是由820亿个晶体管组成,在尽可能小的空间内容纳尽可能多的计算能力,可提供一致的x86 ISA支持,最高的vCPU密度。AMD预计Bergamo在5年内将占所有数据中心处理器销售额的25%以上。

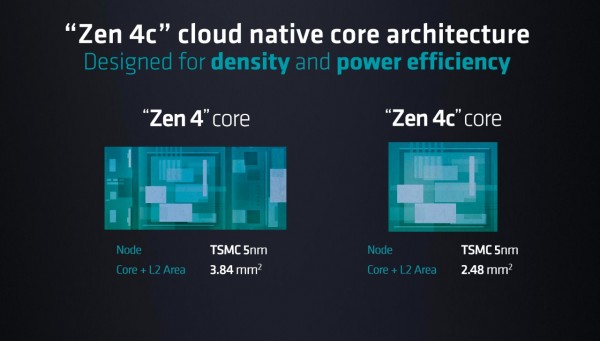

此次AMD EPYC Bergamo将Zen 4核心替换为Zen 4c,Zen 4c提供比Zen 4更高的密度,同时保持100%的软件兼容性。AMD优化了高速缓存层次结构,并进行了其他调整,从而节省了35%的裸片面积。CCD核心数量从8个增加到16个,CCD总数从12个减少到8个。

基于Zen 4c的Bergamo EPYC 9704系列处理器现已上市,目前包括EPYC 9754、EPYC 9754S、EPYC 9734三个型号。戴尔PowerEdge系列服务器已经实现支持,同时Bergamo处理器正在向大型云计算客户批量出货,Meta就计划在基础架构中使用 Bergamo,它的性能比上一代Milan芯片高出2.5倍。

除了Bergamo,AMD还带来了更针对技术计算的“Genoa-X”,以及针对电信和边缘计算的“Siena”,预计在下半年上市。

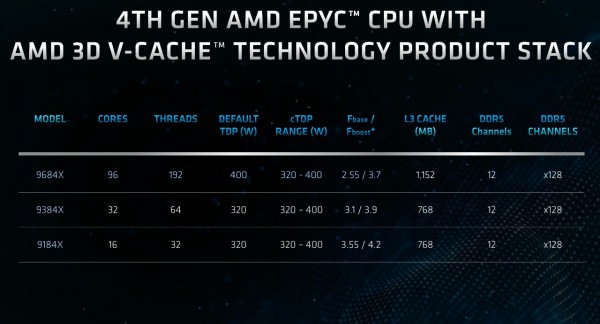

Genoa-X配备了3D V-Cache技术,通过在每个CCD顶部堆叠一个64MB L3 V-Cache芯片增加L3 缓存容量,让Genoa-X可以提供高达1152MB的总L3缓存。Genoa-X与具有相同内核数的友商处理器比较,在各方面都显示出了更强的优势。

目前Genoa-X系列三个型号分别是,96核的EPYC 9684X、32核的EPYC 9384X、16核的EPYC 9184X。

Microsoft Azure也宣布最新高性能计算用虚拟机HBv4与Azure HX使用Genoa-X,内存将是前一代3倍,工作负载的性能提升最高达到5.7倍。

1530亿晶体管芯片现世MI300X

对于生成式AI,可能现在每个人、每个企业都在关注。Lisa Su说,AI是目前技术的决定性大趋势。她概述了由大型语言模型 (LLM) 驱动的AI市场存在着巨大的市场机会,导致数据中心AI加速器的TAM到2027年将会达到1500亿美元,CAGR将超过50%。

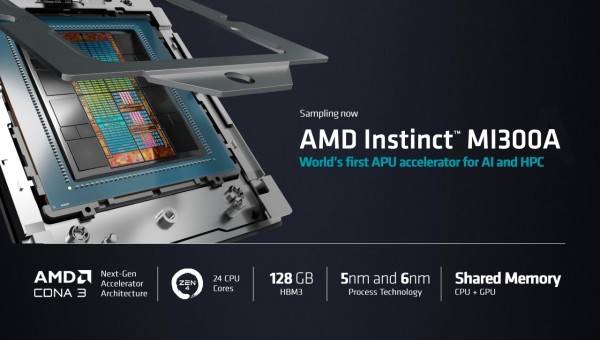

其实在2023年第一季度,AMD就推出了CPU+GPU架构的Instinct MI300正式进军AI训练端。MI300结合AMD的Zen 4 CPU与CDNA 3 GPU,通过“统一内存架构”突破GPU与CPU之间的数据传输速度限制,满足未来AI训练和推理中,海量数据计算和传输的需求。

今天万众瞩目的Instinct MI300系列产品又发布了MI300A和MI300X。

MI300A是全球首个为AI和HPC打造的APU加速卡,目前已出样。其拥有13个小芯片,总共包含1460亿个晶体管,采用了24个Zen 4内核、CDNA3 GPU内核和128GB HBM3内存。与 MI250 相比,其提供了8倍的性能和5倍的效率。

MI300X是AMD针对大语言模型优化的版本,拥有12个5nm的小芯片,晶体管数量达到了1530亿个。MI300X没有集成CPU内核,采用了8 个CDNA3 GPU内核和4个IO内存内核设计。内存达到了192GB,内存带宽为5.2TB/s,Infinity Fabric带宽为896GB/s。

MI300X提供的HBM(高带宽内存)密度约为英伟达H100的2.4倍,HBM带宽则为1.6倍,这让运行更大的模型成为可能,从而降低成本。

现在在单个GPU上运行一个400亿参数的模型,已经不在是幻想。MI300X可以支持400亿个参数的Hugging Face AI模型运行,最多可以运行800亿个参数的模型,而且使用多个MI300X叠加可以处理更多的参数。

现场Lisa Su演示了在单个MI300X上运行拥有400亿个参数的Falcon-40B大型语言模型,写了一首关于旧金山的诗。

MI300X将在第三季度出样,第四季度加大生产,以挑战英伟达在市场重的领先地位。

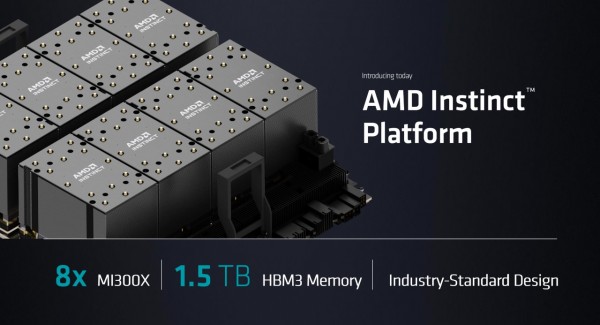

AMD还发布了新的Instinct平台,可以加快客户的上市时间,并降低总体开发成本。其基于OCP开放计算标准,将8块MI300X加速卡并行,可提供总计多达1.5TB HBM3内存。

而且为了突破CUDA这个护城河,AMD正在不断发展ROCm,这是一套完整的库和工具,可以优化AI软件堆栈。不同于专有的CUDA,ROCm软件栈可与模型、库、框架和工具的开放生态系统兼容。AMD总裁Victor Peng也希望,未来在AI软件生态系统开发中持续采用“开放(软件方法)、经过验证(AI能力)、就绪(支持AI模型)”的理念。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元