Nvidia公布MGX开放服务器规范 支持自身硬件以及传统x86

Nvidia创建了一项服务器开放设计以支持其加速器,并认为,以CPU为中心的服务器设计无法容纳多个GPU和SmartNIC。

Nvidia公司首席执行官黄仁勋本周一举行的Computex 2023大会上公布了名为“MGX”的设计,并表示这是必要的,因为现有的服务器设计无法应对Nvidia加速器产生的热量和消耗的功率。

他认为,从1965年IBM System 360首次亮相之日开启的计算历史时代如今已经结束。在 他的讲述中,System 360曾赋予了CPU的全球主导地位以及扩展系统的能力。

他认为,自那以后这种架构一直主导着世界,但CPU性能的提升已经趋于稳定,加速器辅助计算才是未来。

当然,这一论点是Nvidia的核心宗旨。

但黄仁勋用有关生成大型语言模型(LLM)所需工作量这一数据来支持他的观点,他引用了一个例子,假设有960台服务器系统,该系统耗资1000万美元,它需要消耗11Gwh来训练一个大型语言模型。

他断言,只需一对成本为40万美元的、Nvidia驱动的服务器以及封装的GPU就可以完成同样的工作,而功耗仅为0.13 GWh。他还表示,价值3400万美元的、Nvidia驱动的172设备可以用来训练150个大型语言模型,消耗11GWh。

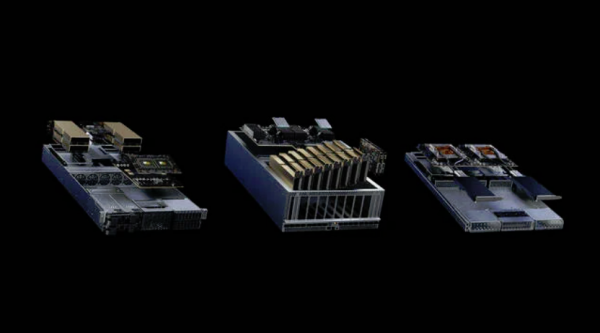

即将推出的、基于Nvidia MGX规范的服务器

黄仁勋的理论是,这种设备很快就会出现在很多企业组织的购物清单上,因为虽然数据中心的建设速度是惊人的,但大家对机架空间和电力的竞争依然很激烈,所以很多用户会想办法重新设计他们的数据中心以提高效率和密度。

这就是MGX规范的用武之地,MGX提供了一种设计,可以在更小的空间内使用更多的Nvidia产品,而不是将其硬塞进仅由CPU驱动的机器中。黄仁勋表示,MGX提供了用户所需的密度。如果需要,它可以愉快地容纳旧的x86 CPU,以及所有Nvidia的加速器。

华擎科技、华硕、技嘉、和硕、QCT和Supermicro都已签约生产这种服务器,黄仁勋表示,这些服务器可以部署为100多种配置中,具有1U、2U和4U等外形规格。

8月,QCT将交付名为S74G-2U的MGX设计,该设计将提供GH200 Grace Hopper Superchip。同月,Supermicro将推出ARS-221GL-NR,采用Grace CPU Superchip。

黄仁勋还宣布,Grace Hopper的生产正在如火如荼地进行中。他表示,Grace Hopper可以用于运行5G网络的家庭环境,以及用于一些生成式AI中,在视频聊天通过网络时对其进行训练,而不是让客户端设备完成所有压缩和解压缩视频的工作。

他还介绍了一款大型交换机Spectrum-X Networking Platform,以提高以太网在运行AI工作负载的大规模云中的效率。

他提到,Nvidia改进了对AI软件堆栈的支持,使其更适合企业使用。

黄仁勋也在考虑机器人技术,因为Nvidia已经开放了Isaac平台,该平台结合了软件和芯片,可以打造用于工业用途的自主机器人,特别是可以用于在仓库里四处搬运货物。

之所以能够做到这些,是因为Nvidia使用封装了全部Nvidia加速硬件的服务器上创建真实世界的数字孪生,从而打造出了这种机器人。

这再次说明了Nvidia为什么要构建MGX服务器规范。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元