自动驾驶感知能力比试,浪潮信息算法团队再创nuScences成绩新高

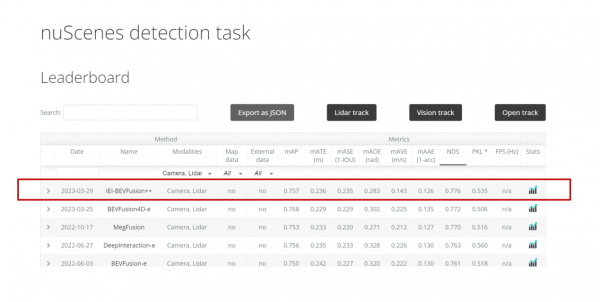

近日,在全球权威的自动驾驶nuScenes竞赛最新评测中,浪潮信息算法团队所提交的“IEI-BEVFusion++”算法模型在关键性指标nuScenes Detection Score(NDS)得到77.6%的高分,创造了3D目标检测全赛道迄今最高成绩。继去年以“DABNet4D”登顶纯视觉3D目标检测榜单后,该算法团队在面向融合感知自动驾驶领域再一次实现突破。

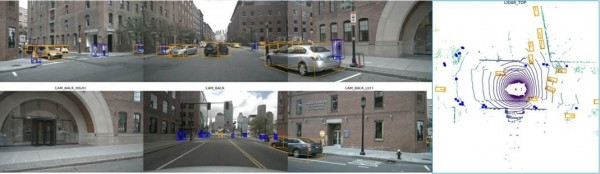

nuScenes数据集是目前自动驾驶领域中最流行的公开数据集之一,数据采集自波士顿和新加坡的实际自动驾驶场景,是第一个集成摄像头、激光雷达和毫米波雷达等多种传感器,实现360度全传感器覆盖的数据集。nuScenes数据集提供了二维、三维物体标注、点云分割、高精地图等丰富的标注信息,包含1000个场景,拥有140万帧图像、39万帧激光雷达点云数据、23个物体类别、140万个三维标注框,其数据标注量比KITTI数据集高出7倍以上。

犹如人类的眼睛为大脑提供了70%以上的信息,在自动驾驶领域,作为感知系统的主流模式架构,Lidar与Camera融合的3D多模态架构则为实现高鲁棒、高精度的3D目标检测提供了至关重要的信息输入,为业内提供更具通识性的解决方案。此次创nuScenes榜单成绩新高的“IEI-BEVFusion++”算法模型正是应用了3D多模态融合架构的思路,将Lidar与Camera形成有效的交互融合。

l Lidar与Camera的多模态交互融合,面临巨大挑战

3D目标检测作为自动驾驶至关重要的核心任务,面向强大的环境感知,自动驾驶车辆通过广泛车载传感器的信息输入,实现精准的目标检测。以Lidar为例,它可以有效精准地捕捉空间信息,点云数据所具备的天然3D优势,最大程度地提升了检测目标的测距精度、速度及方向;而Camera的优势则在于,它具备丰富的纹理信息,强大的语义及图像上下文理解能力使得它可以有效地识别行人、交通指示牌等具象化的路面信息。因此,Lidar与Camera融合的3D多模态架构将深度信息与纹理信息形成有效的交互融合,为更精准的3D目标检测提供了一种全新思路。

然而,将两种截然不同的模态几何和语义特征在一个表示空间内相结合,这是一个巨大的挑战。 一方面,预估检测目标的深度信息是提升3D目标检测精度的关键,现有模态的融合通常关注于点云雷达及Camera虚拟点间的交互,但由于点云雷达远比Camera数据稀疏得多,传统的融合方式无法解决固有模态间的深度信息差距。另一方面,在跨模态的融合交互中,点云雷达涉及体素的精细划分及大量的3D卷积计算,图像则由于多摄像头、高分辨率,复杂的特征提取网络,两者计算复杂且耗时长。因此,不同形态的数据整合也为多模态融合模型的训练速度和检测精度带来了新一层算力压力。

l NDS 77.6%, 多模态融合模型“IEI-BEVFusion++”刷新全赛道记录

IEI-BEVFusion++多模态融合模型,通过更有效的多模态训练架构、更精细的特征提取网络、更强大的数据预处理能力,实现Lidar与Camera的高效特征提取与融合优化。激光雷达点云特征为Camera数据提供检测目标的精确3D信息,Camera发挥其纹理轮廓及语义理解优势,进一步精细化点云区域特征,形成Liar与Camera的数据最大化互补,大幅优化了模型的检测精度。

基于Lidar与Camera的多模态融合模型架构,实现了三大核心技术突破:

- IEI-BEVFusion++ 多模态融合模型架构图 -

a)首先,基于更有效的多模态训练架构,使得mAP(全类平均正确率,mean Average Precision)平均提升2%+

Transformer的多模态数据融合架构,通过引入基于Camera数据的BEV检测头,辅助融合模型训练,在不增加过多计算量的同时,进一步增强语义信息特征,使得mAP(全类平均正确率,mean Average Precision)平均提升2%+。

b)其次,精细的特征提取网络,大幅提升目标的3D检测能力

一方面,采用多尺度Lidar的特征融合技术,进一步增强其特征提取的感受野,提升其对于检测目标,尤其是大目标的表征能力;另一方面,Lidar信息可直接辅助优化Camera的深度预测,采取级联深度辅助策略,大幅提升图像的3D检测能力。

c) 同时,强大的数据预处理能力,实现模型精度与训练速度双突破

创新设计Lidar与Camera同步贴图,替代了业内传统的cbgs(类平衡分组和采样)技术。一方面增强了样本的均衡性与多样性,另一方面保证了不同模态间的数据协调、同步,在提升目标定位检测精度的同时,保障目标速度、方位、缩放等相关指标的提升,训练速度更是较业内基准提升了4.5倍。

基于BEV融合算法的创新,“IEI-BEVFusion++”算法模型成功登顶3D目标检测任务(nuScenes detection task)全赛道榜单,将关键性指标NDS提升至77.6%。未来,浪潮信息算法团队将践行多角度切入,发挥算法、算力融合的全栈解决方案能力,推动自动驾驶领域的技术创新发展。

备注:文内所涉术语解释如下

1)BEV:Bird’s Eye View,是指将特征信息转化至鸟瞰视角

2)多模态融合:也称多源信息融合或多传感器融合,是指综合两个或多个模态的信息进行预测的过程

3)鲁棒(Robust): 是指系统在一定的参数摄动下,维持其它某些性能的特性

来源:业界供稿

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元