浪潮信息助力淮海智算中心,千亿参数AI大模型训练算力效率超50%

近日,淮海智算中心携手浪潮信息进行了超大规模参数AI大模型训练性能测试,实测数据表明,千亿参数规模的自然语言AI单体大模型在淮海智算中心计算平台上的训练算力效率达53.5%,刷新了业内AI大模型训练算力效率新高。这意味着淮海智算中心将可为国内生成式AI创新团队提供高性能、高效率的AI大模型训练算力服务。

生成式AI需要基于海量的自然语言或多模态数据集,对拥有巨大参数的超大规模AI模型进行训练,其训练所需AI算力当量非常高,如以PD(Petaflops-Day)为单位来衡量,OpenAI的GPT-3大模型训练的算力当量为3640PD,而浪潮“源1.0”大模型的算力当量则为4095PD。

超大规模AI大模型的训练一般必须在拥有成百上千加速卡的AI服务器集群上进行,如何在AI计算集群上获得更高的训练算力效率则会直接影响到模型训练时长以及算力消耗成本,这对于提升生成式AI研发创新效率有着非常重要的影响。据公开资料表明,GPT-3大模型在其V100 GPU集群上的训练算力效率为21.3%,而浪潮“源1.0”的训练算力效率则达到了44.8%。

针对AI大模型训练的计算特点,浪潮信息AI团队对淮海智算中心算力系统进行了专业设计,对集群架构、高速互联、算力调度等方面进行全面优化,在系统架构上,采用单节点集成8颗加速器的AI服务器,节点内加速器间实现超高速P2P通信,节点间建立极低延迟、超高带宽的Infiniband通信网络。在大模型训练技术层面,成功运用了中文巨量AI模型“源1.0”的训练优化经验,对分布式训练策略进行了针对性优化,通过合理设计张量并行、流水并行和数据并行,精准调整模型结构和训练过程的超参数,最终实现了千亿参数规模AI大模型的训练算力效率达到53.5%。

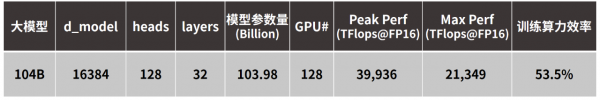

千亿参数AI模型结构及其实际性能表现

淮海智算中心由安徽省宿州市与浪潮共同推进建设,目标是建成技术先进、架构开放、应用丰富、生态完善的国内领先智算枢纽。淮海智算中心将依靠领先的算力、算法基础设施,开放的技术架构,成熟丰富的生态应用,面向全国提供智能算力、数据和算法服务,打造良好的智算产业生态。

来源:业界供稿

好文章,需要你的鼓励

斯坦福大学团队突破性发现:AI智能体终于学会了如何聪明探索!

斯坦福大学、苏黎世联邦理工学院和Idiap研究所的研究团队开发出LAMER框架,首次让AI智能体学会了在陌生环境中巧妙平衡探索与利用。该框架通过跨回合训练和自我反思机制,让智能体能从失败中学习并改进策略。在四个测试环境中,LAMER分别取得了11%、14%和19%的性能提升,并在面对更困难或全新任务时展现出卓越的适应能力,为开发能自主学习的通用AI智能体奠定了重要基础。

特斯拉和苹果,谁也没想到最后是这群学者率先攻克了用摄像头“看见“雷达的难题

以色列理工学院联合MIT、英伟达等机构研究团队开发出RadarGen技术,能够仅通过摄像头画面生成逼真的汽车雷达数据。该技术采用扩散模型架构,将稀疏雷达点云转换为鸟瞰视图表示,结合深度估计、语义分割和光流信息指导生成过程,还支持场景编辑功能。实验表明生成数据可被现有检测器有效使用,为自动驾驶训练数据获取提供了新方案。

至顶AI实验室硬核评测:本地部署Step-Audio 2 mini

至顶AI实验室硬核评测:智谱AI Open-AutoGLM开源了,系统级AI Agent免费玩

高性能 AI 边缘推理服务器MIC-743-AT

Instagram长视频内容和个性化订阅可能即将到来

NVIDIA DGX Spark

Dell Pro Max with GB10

至顶AI实验室硬核评测:戴尔 Precision 5490移动工作站搭建Open Deep Research,打造专属于你的全流程AI研究助手

惠普ZBook Fury G1i高性能移动工作站

至顶AI实验室硬核评测:夸克 AI 眼镜全链路"无切换体验",当AI助手真正走进日常

夸克AI眼镜

至顶AI实验室硬核评测:据说这就是AI手机的形态,贴脸开大,豆包手机上手评测

OpenFlex(TM) Data24 NVMe-oF(TM) 存储平台