浪潮分布式存储:让数据融合互通,为“云数智”应用构筑新平台

数字时代,数据共享互通成为刚需

数字经济时代,云计算、大数据、人工智能等新技术快速发展,非结构化数据爆发式增长,数据类型变得愈发复杂多样。在自动驾驶、基因测序、气象预报等云数智应用场景中,一次数据处理可能会涉及到文件、对象、大数据等多种协议,数据间的互通转换成为数据存储中至关重要的一环,具备平台化能力的融合存储成为数字基础设施建设的核心。

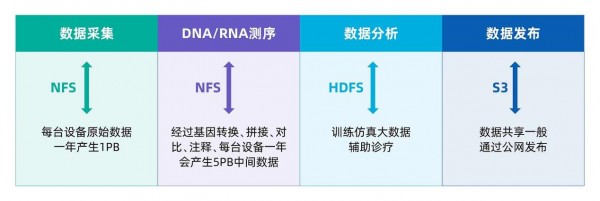

以基因测序场景为例,一次完整的基因测序涉及到数据采集、格式化、脱敏、压缩、分析、发布等操作,其过程可以大致分为样本采集、DNA/RNA测序、数据分析和发布四个步骤。在不同的处理阶段,需要使用不同的数据协议进行操作。其中在样本采集和DNA/RNA测序阶段采用NFS文件协议,数据分析阶段采用HDFS大数据协议,数据发布阶段则是通过公网数据共享采用S3对象协议。整个数据处理过程涉及三种协议格式,这就意味着完成一次基因的测序流程需要在NFS、HDFS和S3之间进行两次数据拷贝和数据格式的转换。传统存储仅支持单一的访问协议,这就会造成两个问题:一是数据格式转换和数据拷贝会降低整个数据处理流程的效率;二是多套存储副本增加存储空间成本。

基因测序应用需要使用多种数据协议

百川入海:浪潮基于一套存储 承载多样化数据

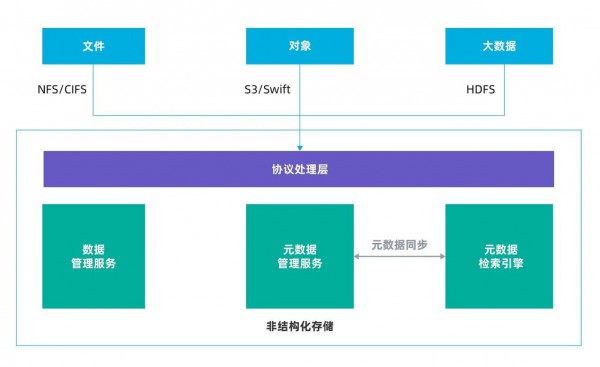

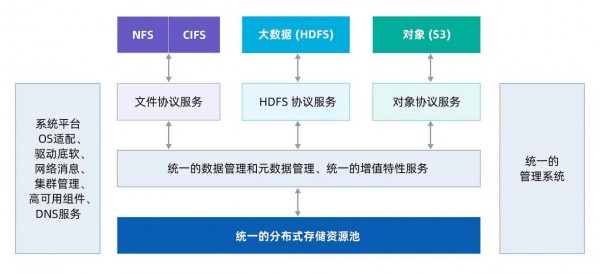

浪潮分布式存储平台AS13000基于对非结构化数据协议(NFS/CIFS/HDFS/S3)融合互通的研究进行技术创新,采用统一的数据管理和元数据管理、统一的增值特性服务、统一的分布式存储资源池和统一的管理软件系统,保证各种协议共享同一份数据和元数据。访问过程中无需数据转换和拷贝,并且为每种协议提供原生语义服务,每种服务均可直接访问,无需安装网关、插件或在计算侧或应用层进行改造。

AS13000非结构化数据融合架构

基于“多合一”极简架构,浪潮分布式存储得以实现四个“统一”。

首先,提供统一的数据管理和元数据管理。

数据管理和元数据管理是非结构化数据存储的关键,浪潮分布式存储平台AS13000根据NFS、CIFS、HDFS和S3的语义和元数据特点,抽象各协议的数据和元数据操作,通过一套统一的非结构化数据和元数据管理架构有效地保证各协议的原生访问。

其次,提供统一的增值特性服务。

基于统一的数据访问接口和元数据管理的架构设计,浪潮AS13000对外提供统一的增值特性服务,包括统一配额、QoS、加密、压缩、快照、回收站、分级存储、远程复制、元数据检索等等。

以下图为例:同一个元数据检索服务ElasticSearch支持NFS、CIFS、S3、HDFS多种协议,并且各协议为同一配置入口和查询入口。

统一增值特性示例:元数据检索服务

再次,构建统一的分布式存储资源池。

AS13000支持NFS/CIFS/HDFS/S3等多种服务协议共享非结构化存储资源池,并且同一个文件不同协议访问的数据和元数据为同一份。例如,通过文件NFS协议写入的一个文件,通过对象存储AWS S3协议、大数据HDFS协议和文件CIFS协议均可读取;每个节点都可以启动文件NAS、大数据HDFS和对象存储S3服务。

最后,打造统一的管理系统。

管理软件负责集群的安装、部署、业务配置、设备管理、监控、告警等功能。浪潮分布式存储平台AS13000打造了融合互通的管理系统,可同时支持NFS/CIFS/HDFS/S3等多种服务协议,增值特性通过统一的配置入口对所有非结构化存储协议同时生效,减少了企业的管理成本。

浪潮分布式存储平台AS13000通过多年来的持续技术创新,以一份数据支持多种协议访问,实现了非结构化数据融合互通,在提升数据处理效率的同时降低了存储购置和运维成本,保障各协议的语义无损和性能无损,构筑了面向“云数智”应用的融合存储平台,助力企业数字化转型,加速释放数据价值。

来源:业界供稿

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。

稚晖君发布全球最小全身力控人形机器人,上纬启元开启个人机器人时代

2026年软件定价大洗牌:IT领导者必须知道的关键变化

Linux 在 2026 年将势不可挡,但一个开源传奇可能难以为继

CES 2026趋势展望:全球最大科技展五大热门话题预测

人工智能时代为何编程技能比以往更重要

AI颠覆云优先战略:混合计算成为唯一出路

谷歌发布JAX-Privacy 1.0:大规模差分隐私机器学习工具库

谷歌量子AI发布新型优化算法DQI:量子计算优化领域的重大突破

缓解电动汽车里程焦虑:简单AI模型如何预测充电桩可用性

Titans + MIRAS:让AI拥有长期记忆能力

Gemini为STOC 2026大会理论计算机科学家提供自动化反馈

夸克AI眼镜持续升级:首次OTA,支持89种语言翻译