NVIDIA加速计算助力基因测序突破极限,实现百万倍加速

自从生命的“密码”— 基因组被科学家破解以来,人类追求速度更快、成本更低的基因测序技术的脚步一直都在继续。

在1月13日刚刚结束的摩根大通医疗健康大会上,NVIDIA发布了与初创公司 InstaDeep、慕尼黑工业大学(TUM)在基因组学大型语言模型方面的联合研究成果。研究团队使用NVIDIA超级计算机 Cambridge-1,在各种基因组数据集上,训练了参数规模从500M到2.5B不等的各种大型语言模型(LLM),经过基因组学训练的大型语言模型可将应用扩展到大量基因组学任务, 这些任务有助于了解DNA如何转录生成RNA和蛋白质,从而开启新的临床应用。

基因测序 梦想照进现实

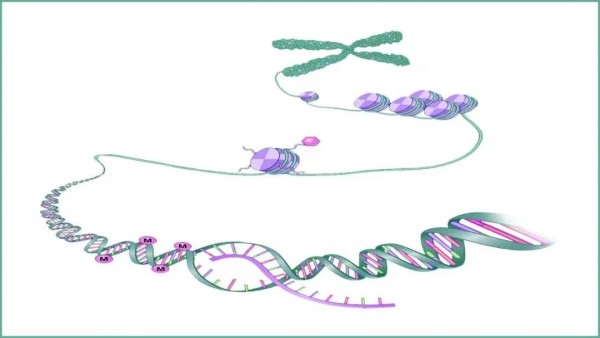

作为人类医疗技术发展的重要一步,基因测序可通过提取人体血液或唾液,对人类的DNA、RNA、蛋白质及代谢物进行分析,从而锁定个人病变基因,以诊断、预测或预防遗传性疾病的发生。基因蕴含了人类诸多病症的秘密,使人类有机会尽早预防疾病,并多元化治疗疾病。

2001年,被誉为生命科学“登月计划”的“人类基因组计划”(HGP)历时13年,耗资近30亿美元,发布了首张人类基因组草图。此后二十年中,以数字生物学为基础的基因组测序技术取得巨大进步,将全基因组测序的成本逐步降低至不到1000美元。一时间,全球对基因测序与分析的需求量出现暴涨。

加速计算突破基因分析算力瓶颈

随着基因组测序和分析需求的激增,由此产生的数据也迎来爆发式增长。过去十年间,基因测序的数据量平均每七个月就会翻一倍, 2025年全球测序能力预计将达到Zb级别,其中,仅人类全基因组存储的数据量就将达到每年2-40Eb。

要实现精准医疗,就需要对大量基因数据做出精确的计算和分析,这意味着巨大的计算成本和时间。因此,必须有创新的技术,打破全基因组测序数据医疗应用的主要瓶颈,推动行业进一步向前发展。

基因组测序与分析属于标准的计算密集型任务,而GPU擅长并行计算,可以将复杂计算问题分解为很多小任务,在多个CUDA内核上同时运行,从而大幅减少处理计算任务的时间,让基因组测序分析的速度获得大幅提升。NVIDIA以GPU为核心构建出“全栈加速计算平台”,与人工智能相结合,在全球包括基因测序在内的多个领域掀起一场加速革命。

除了具有全球领先的硬件加速计算平台,NVIDIA还推出了基于GPU的基因测序分析加速软件—— NVIDIA Clara Parabricks。Clara Parabricks是一款GPU加速的计算基因组学工具包,可提供多种生物信息学工具和功能,如序列比对、预处理和质量指标、变异检测、UMI以及用于胚系、体细胞和RNA分析的端到端工作流程。与仅使用CPU的解决方案相比,Parabricks速度提升高达80倍,计算成本降低高达50%。借助Clara Parabricks和GPU,将深度学习的强大功能应用到基因组分析,可为测序中心、临床团队、基因组学研究人员以及新一代测序仪器开发者提供快速准确的分析,进而助力更快速、更准确的基因组学分析。

此外,为了更好地帮助科学家了解疾病,为患者找到治疗方法,NVIDIA还推出了BioNeMo框架,用于训练和部署超算规模的大型生物分子语言模型。该大型语言模型框架可支持化学、蛋白质、DNA和RNA数据格式,还可提供云API服务,用于未来支持越来越多的预训练AI模型。

基因测序领域降本增效创造新记录

在NVIDIA加速计算平台、人工智能与基因测序专业软件的赋能下,来自全球的学研机构、政府组织以及相关企业,正在不断突破基因测序与分析领域的速度与成本极限,创造出一项项新的记录:

- 斯坦福大学、NVIDIA、牛津纳米孔科技公司、谷歌、贝勒医学院和加州大学圣克鲁兹分校的研究人员共同合作推出DNA测序技术,实现了创纪录的测序速度。该方案使用NVIDIA Clara Parabricks计算基因组学应用框架,以及GPU加速版本的PEPPER-Margin-DeepVariant流程,在谷歌云上使用NVIDIA GPU加速碱基判定和变体识别,将基因诊断时间从数周缩短到5.2小时,使医生能够快速判断如何治疗危重病人。

- 麻省理工学院与哈佛大学旗下的博德研究所与NVIDIA合作,为拥有超过2.5万用户的Terra云平台提供快速分析海量医疗数据所需的AI能力和加速工具。通过GPU加速的NVIDIA Clara Parabricks工作流,可助力从事各种基因组数据分析的研究人员降本增效。在博德研究所的GATK最佳实践——生殖细胞突变检测分析流中,Parabricks在GPU上进行分析的速度提高了24倍,而成本减半。

- 阿里云与NVIDIA达成合作,成为国内首家在基因分析平台集成和部署NVIDIA Clara Parabricks的公有云厂商。Clara Parabricks为阿里云基因分析平台的行业标准基因组分析工具包以及基因调用器等工具带来了GPU加速,据测算用户可以在30分钟内完成一个30x测序深度的全基因组分析,且与GATK的最佳实践结果 99.99% 一致,而在过去基于 CPU环境中这项工作需要20多个小时才能完成,并且计算成本可降低40%-80%。

- 普渡大学首席研究员Carpi博士和团队将Clara Parabricks的表现和疟疾学界使用的鉴定变体和跟踪疟疾传播的现有方法进行了对比,并使用1000个疟疾基因组监测抗疟药物的耐药性。与只使用CPU的传统方式相比,基于GPU加速的Clara Parabricks分析速度提高了27倍,成本降低了5倍,同时准确率达到 99.9%。

- 圣路易斯华盛顿大学的Tychele Turner博士与团队使用基于GPU加速的Clara Parabricks开发出一种快速基因组学工作流,用于在自闭症患者中发现de novo 变异(DNVs)。通过将三重分析整合到 NVIDIA Clara Parabricks中,Turner博士将生成DNV初始分析的时间从原来的800 小时(在CPU上进行)缩短至8.5小时(在GPU 上使用只有4个GPU的服务器),加快了100 倍。

- 为推广基因组医学计划,泰国国家生物库采用NVIDIA DGX A100系统和NVIDIA Clara Parabricks来打造IT基础设施,以加速基因组测序。加速方案将全基因组测序的数据处理时间缩短了4个月,每位用户的处理时间也从30多个小时缩短到1到2小时。

- 生物技术领军企业Regeneron高通量测序中心与大规模的生物医学数据库和研究资源平台英国生物样本库合作,在DNAnexus平台上使用NVIDIA Clara Parabricks运行分析对超过50万名生物库参与者的外显子组进行了测序和分析,5分钟内完成了在32-vCPU机器上需要花费一小时计算的全外显子组分析,同时成本降低约40%。

凭借加速计算领域的全栈能力以及深耕行业所积累的专业知识,NVIDIA现在已经推出了智能计算平台NVIDIA Clara,全面布局医疗健康行业。该平台涵盖了用于医学影像的Clara Holoscan、基因组学的Clara Parabricks、患者监控的Clara Guardian以及药物研发的Clara Discovery,并可端到端部署至本地、嵌入式系统、边缘以及云端等任何地方,助力行业实现无缝创新,加快实现精准医疗的目标。

NVIDIA 通过持续完善的NVIDIA Clara平台,在为AI落地医疗场景提供了更大的动能。随着深度学习进入越来越多的领域之中,NVIDIA在为众多开发者提供算力支持的同时,也为其搭好了强有力的“基底”,在这之上,开发者能够将更多的精力放在知识的探索之上,而非受制于如何使用数据分析工具。

无论是尖端医学研究、大规模基因组分析还是日常应用检测,NVIDIA Million-X百万倍计算性能飞跃的愿景已经在基因测序的各个领域结出累累硕果,并将持续为人类消除疾病、促进健康做出贡献。

来源:业界供稿

好文章,需要你的鼓励

Plaud推出新款AI可穿戴设备,有望取代Otter.ai

Plaud在CES上推出两款AI笔记新品。NotePin S延续简约设计,可作为手环、项链或胸针使用,新增即时高亮按钮功能,售价179美元。同时发布的Plaud Desktop可录制在线会议,支持Zoom、Google Meet等平台,采用原生录制方式而非机器人参会。两款产品均可通过Plaud生态系统统一管理录音内容。

ByteDance联手顶尖学府重新定义AI思考:当机器学会分层理解世界

ByteDance等机构联合提出DLCM模型,通过学习语义边界动态分配计算资源,将AI从统一令牌处理转向层次化概念推理。该模型引入压缩感知缩放定律,在12项零样本测试中平均提升2.69%准确率,为构建更智能高效的AI系统开辟新路径。

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

Instagram负责人亚当·莫塞里发布深度分析,指出我们正进入"无限合成内容"新时代,AI生成的照片和视频与真实内容越来越难以区分。他表示,人们需要从默认相信眼见转向保持怀疑态度,关注内容发布者身份和动机。莫塞里认为相机公司发展方向错误,过度追求完美效果。平台需要构建更好的创作工具,标记AI生成内容,验证真实内容,并提供发布者可信度信号。

香港中文大学团队突破:让AI有了“超级记忆“,多步推理能力飙升!

香港中文大学团队突破AI记忆瓶颈,提出HGMEM超图记忆机制。该技术让AI具备类似人类的联想思维,能将分散信息整合成高阶理解。通过动态记忆演化和智能检索,显著提升了复杂推理能力,在长文本理解任务中全面超越现有方法,为AI向"知识理解者"转变开辟新路径。

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

派拓网络安全官:智能体将成2026年最大内部威胁

Subtle发布搭载降噪模型的无线耳机

Xreal发布新款AR眼镜和电源集线器,革新工作娱乐体验

纳瓦尔Flow 2扫地机器人问世:配备AI识别技术能找到丢失物品

7个家庭AI技巧让智能聊天机器人相形见绌

Mac成为企业环境中最可持续设备的原因调查显示

首次独居必备的10款实用智能设备推荐

OpenAI重组团队开发语音AI硬件产品,2026年推出新模型

AI重塑工作格局:Mercor如何连接人才与智能体训练

科技巨头在股价飙升中套现160亿美元

联想问天 WR5215 G5服务器重磅发布:以能效和性能树立单路服务器新标准

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币