Triton推理服务器03-开发资源说明

大部分要学习Triton推理服务器的入门者,都会被搜索引擎或网上文章引导至官方的https://developer.nvidia.com/nvidia-triton-inference-server处(如下截图),然后从“Get Started”直接安装服务器与用户端软件、创建基础的模型仓、执行一些最基本的范例。

这条路径虽然能在很短时间内跑起Triton的应用,但在未掌握整个应用架构之前便贸然执行,反倒容易让初学者陷入迷失的状态,因此建议初学者最好先对Triton项目有比较更完整的了解之后,再执行前面的“Get Started”就会更容易掌握项目的精髓。

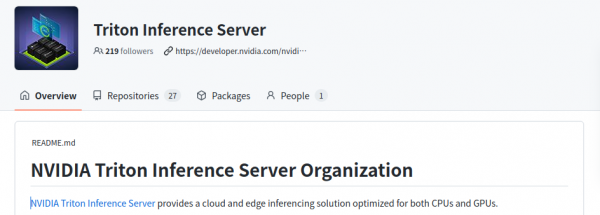

要获得比较完整的Triton技术资料,就得到项目开源仓里去寻找。与NVIDIA其他放在https://github.com/NVIDIA或https://github.com/NVIDIA-AI-IOT的项目不同,Triton项目有独立的开源仓,位置在https://github.com/triton-inference-server,进入开源仓后会看到如下截屏的内容:

下面列出四大部分的技术资源:

- Getting Start(新手上路):

这里提供三个链接,比较重要的是“Quick Start(快速启动)”的部分,提供以下三个步骤就能轻松执行Triton的基础示范:

- Create a Model Repository(创建模型仓)

- Launch Triton(启动Triton服务器与用户端)

- Send an Inference Request(提交推理要求)

- Production Documentation(生产文件):

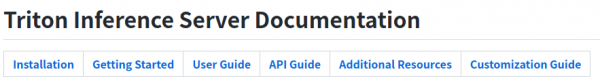

这里最重要的是“server documents on GitHub”链接,点进去后会进入整个Triton项目中最完整的技术文件中心(如下图),除Installation与Getting Started属于入门范畴,其余User Guide、API Guide、Additional Resources与Customization Guide等四个部分,都是Triton推理服务器非常重要的技术内容。

因此这个部分可以算得上是学习Triton服务器的最重要资源。

例如点击“User Guide”之后,就会看到以下所条例的执行步骤:

- Creating a Model Repository [Overview || Details]

- Writing a Model Configuration [Overview || Details]

- Buillding a Model Pipeline [Overview]

- Managing Model Availablity [Overview || Details]

- Collecting Server Metrics [Overview || Details]

- Supporting Custom Ops/layers [Overview || Details]

- Using the Client API [Overview || Details]

- Analyzing Performance [Overview]

- Deploying on edge (Jetson) [Overview]

每个步骤都提供[Overview]与[Details]两种说明内容,能够更完整地掌握Triton推理服务器的创建步骤与调试重点,适合初学者的入门使用。

- Examples(范例):

这里的范例,比较重要的是指向https://github.com/NVIDIA/DeepLearningExamples链接,列出针对NVIDIA Tensor Core计算单元的深度学习模型列表,包括计算机视觉、NLP自然语言处理、推荐系统、语音转文字/文字转语音、图形神经网络、时间序列等各种神经网络模型细节,包括网络结构与相关参数的内容。

对于未来要在Triton服务器上,对于所使用的网络后端进行性能优化或者创建新的后端,会有很大的助益,但是对于初学者来说是相对艰涩的,因此现阶段先不做深入的说明与示范。

- Feedback(反馈):

这里会链接到https://github.com/triton-inference-server/server/issues问题中心,是Triton项目中最重要的技术问题解决资源之一,后面执行过程中所遇到的问题,都可以先到这里来查看是否有人已经提出?如果没有的话,也可以在这里提交自己所遇到的问题,项目负责人会提供合适的回复。

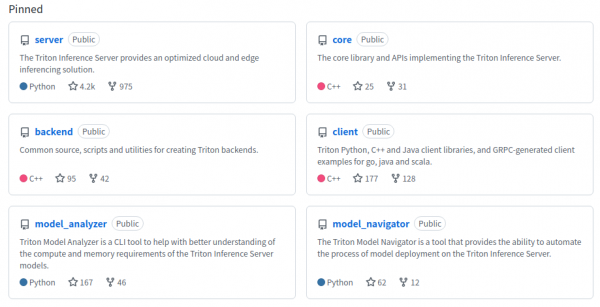

以上第2、4两项资源,对初学者来说会有最大的帮助。接着看一下项目里“钉住(Pinned)”的6个仓(如下图),是比较重要的基础部分,涵盖了Triton架构图中的主要板块。

主要内容如下:

- server仓:

这里集成整个项目的主要内容,包括几部分:

- deploy(部署):提供在阿里巴巴、亚马逊等云资源的部署方式,以及基于NVIDIA Fleet指令集、GKE(Google kubernets Engine)、k8s、Helm等应用平台的各种部署方法;

- docker(容器):修正一些创建容器脚本的错误;

- docs(使用说明):就是前面“生产文件(Production Documentation)”的内容,这里不重复赘述;

- qa(质量优化):由于Triton推理服务器有非常多优化的环节,在这个目录下提供上百个不同状况的优化测试脚本;

- src(源代码):目录下存放整个Triton推理服务器的开源代码(.cc)、头文件(.h)与编译脚本(CMakeLists.txt);

- 其他代码与脚本

- core仓:

此存储库包含实现Triton核心功能的库的源代码和标头。核心库可以如下所述构建,并通过其C API直接使用。为了有用,核心库必须与一个或多个后端配对。您可以在后端回购中了解有关后端的更多信息。

- backend仓:

提供创建Triton服务器后端(backend)的源代码、脚本与工具。“后端”是用来执行不同深度学习模型的管理模块,以深度学习框架进行封装,例如PyTorch、Tensorflow、ONNX Runtime与TensorRT等等,用户也可以为了性能目的,自行定义C/C++封装方式。

- client仓

提供Triton用户端的C++/Python/Java开发接口、能生成适用于不同编程语言的GRPC开发接口的protoc编译器,以及对应的用户端范例;

- model_analyzer仓:

深度学习模型(model)是Triton推理服务器的最基础组成元件,因此对分析模型的计算与内存需求是服务器性能的一项关键功能。这个model_analyzer模型分析工具是一种CLI工具,这款新工具可以自动化地从数百种组合中为 AI 模型选择最佳配置,以实现最优性能,同时确保应用程序所需的服务质量,能帮助开发人员更好地了解不同配置中的权衡,并选择能够最大化Triton的性能配置;

- model_navigator仓:

这个model_navigator模型导航器是一种能够自动将模型从源移动到最佳格式和配置的工具,支持将模型从源导出为所有可能的格式,并应用Triton服务器的后端优化。使用模型分析器能找到最佳的模型配置,匹配提供的约束条件并优化性能。

以上是Trtiton开源项目里比较核心的6个仓,另外还有20多个代码仓,其中大约15个是项目提供的后端(backend)扩充应用,例如tensorrt_backend、fil_backend、square_backend等等,以及一些额外的管理工具,并且不断增加中。

本系列后面的内容都会基于这个server仓的docs目录下的内容为主,按部就班地带着读者循序渐进创建与调试Triton推理服务器的运作环境。【完】

来源:业界供稿

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机

分析:NVIDIA第二季度财报再次超出预期背后的新问题

Jetson百万开发者故事 | 校企合作推动实现多项工业场景下AI边缘计算应用

Jetson百万开发者故事 | NVIDIA Jetson助力水产养殖企业打造自动化流水线

Jetson百万开发者故事 | 基于Jetson Nano的便携式岩石分类检测系统:地质学家的新利器

Jetson百万开发者故事 | 让AI成为铁路客运站自动扶梯安全管控的关键

Jetson百万开发者故事 | Jetson开发者突破百万,从TK1到Orin我都经历了啥

百万Jetson开发者故事

Jetson百万开发者故事 | NVIDIA Jetson如何成为可移动智能脑机交互平台

全新NVIDIA Jetson Orin NX 16GB大幅提升边缘AI性能

Triton推理服务器13-模型与调度器(3)