捉对厮杀:一场数据中心GPU竞赛

如果说半导体行业的发展史教会了我们点什么,那就是市场接纳度远比架构本身更重要。如果设计中的知识产权无法由大量客户承接、处理足够广泛的工作负载,那么出色的设计本身将毫无意义。

如今,我们已经数不清有多少亮点满满、精巧优雅的计算引擎,因为无法在市场上获得庞大的客户受众与部署规模,而倒在降低成本、推动软件生态建设的半途之上。对于这样的系统,消亡就是它们的终极归宿。

虽然英特尔早已是GPU市场上的老玩家,甚至很难在过去几十年来找到比英特尔更热衷于整合GPU业务的厂商,但芯片巨头的这条探索之路仍然走得步履蹒跚。

单在过去十年间,英特尔就经历了基于“Larrabee”x86的GPU振兴计划,然而最终成果无法与英伟达和AMD(ATI)的竞品相抗衡。就连沿用设计方案的英特尔HPC计算核心处理器“Knights”系列也在短短两代之后,就被彻底淘汰。此外还有酷睿i5、i7和i9 PC处理器中的Iris系列集成图形电路。这项设计随后被重新封装进至强E3服务器CPU系列,成为针对视频流和VDI工作负载的集成GPU。英特尔其实一直在刻意模糊掉Iris为这些增强型服务器CPU贡献的强大GPU计算能力,但其客观存在不容忽视。

如今,英特尔正使用基于Xe架构的独立GPU家族再度冲击市场,希望能让自己拥有一套广泛且具有深度的GPU计算平台。很明显,那些掌握着至强服务器CPU权柄的决策大佬们已经意识到,如果英特尔不主动出击用GPU吃掉一部分自家CPU份额,那AMD和英伟达两大主要GPU加速器制造商也会做出同样的举动,而且做得更狠更绝。

英特尔,好久不见

Xe GPU策略属于第11代Iris PC显卡的延续,首次亮相于2018年12月的英特尔创新日活动。当时英特尔表示将建立一套新型架构,基于相同的Xe架构推出独立与集成两类GPU方案,其算力将在“万亿次至千万亿次”之间。具体产品也将涵盖从面向PC客户端优化的低端GPU,到面向AI与HPC工作负载等的数据中心系统优化大型计算引擎。

如今近两年过去,在本届Hot Chips大会上,英特尔详细列举了这一全新GPU系列的设计思路,并谈到将针对特定工作负载调整Xe GPU微架构,甚至会在其中采用不同的制程工艺、封装乃至小芯片组合。其中Xe LP是一款低功耗GPU,最初登陆于“Tiger Lake”CPU,而后又被引入面向服务器类负载的独立SG1和DG1 GPU。英特尔还曾在2020年11月发布过一款与中国系列制造商H3C共同设计的服务器XG310 GPU加速器,其中也使用到Xe LP SG1的变体。

Xe HPG系列针对的是高性能游戏和数据中心流媒体/图形计算工作负载。其中Xe HP将HBM2e内存引入GPU复合体,并在单一封装中扩展至四块小芯片(英特尔称之为tiles),借此实现更强大的媒体与AI工作负载处理能力。最后,Xe HPC系列则强调浮点与混合精度计算能力,填补因Knights系列退市而留下的AI训练与HPC模拟/建模负载空白。

Xe HPC系列包括“Ponte Vecchio”独立GPU。英特尔方面上周表示,相关产品已经开始向阿贡国家实验室发货,将作为“Aurora”百亿亿级超级计算机第二套设计方案中的主计算引擎。

英特尔新近公布的Flex系列140与170 GPU加速器隶属于Xe HPG系列,也被称为Artic Sound-M系列。命名如此混乱,实在没什么必要。总之,这些数据中心GPU的消息从几个月前开始传出,并在8月被确定为Flex系列,但相关架构细节还有很多未明之处。

下图所示,就是对英特尔目前GPU体系的基本概括:

但千万别被图中不同系列所占版面的尺寸所迷惑。Flex系列140基于两个DG2-128 GPU,其各自配备八个主频为1.95 GHz的Xe图形核心,外加两个媒体引擎与八个共享12 GB GDDR6内存的光线追踪单元。Flex系列170则采用单DG2-512 GPU,搭载32个主频为2.05 GHz的Xe核心、两个媒体引擎外加32个共享16 GB GDDR6内存的光线追踪单元。

Xe HPG核心具有16个256位矢量引擎和16个1024位XMX矩阵数学引擎,能够在AI推理应用中发挥重要作用,此外配备192 KB的共享L1缓存。对于关注媒体转码和云游戏的朋友,这两种引擎绝对值得关注,能够在数据中心场景下发挥良好表现,帮助英特尔直接与英伟达开展竞争。当然,也许AMD也在悄悄酝酿,最终拿出自己的数据中心GPU技术组合。如果下定决心参与这场比拼,英特尔也有能力打造出更强的Xe HPC GPU加速器,例如将“Rialto Bridge”独立GPU引入Ponte Vecchio和“Falcon Shores”混合CPU-GPU设备。

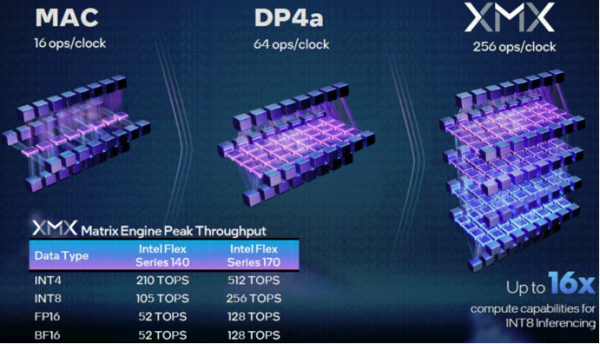

Xe HPC核心上的矢量引擎在每个时钟周期内能处理16个 FP32、32个FP16和64个INT8运算,并提供一个专用的浮点执行端口和另外一个用于整数及扩展数学函数的端口。XMX矩阵引擎则是一个四深脉动阵列,在设计思路上类似于谷歌的TPU与亚马逊云科技的Inferentia芯片。Xe HPC核心上的矩阵引擎每个时钟周期可以处理128个FP16或BF16浮点运算,256个INT8或512个INT4运算。该GPU能够同时将工作负载分派给矢量与矩阵引擎,大大提高运算效率。

英特尔还整理出一份漂亮的图表,展示了数学累加与计算2吞吐量增幅间的差异,能帮助我们明确理解乘法累加单元(MAC)、矢量及矩阵引擎之间的区别。

Flex系列140配备两个DG2-128 GPU,其媒体处理性能要比配备单DG2-512 GPU的Flex系列170高出近一倍,但运算能力却仅为后者的41%。我们还未找到这些设备的确切定价,所以无法做出准确的性价比分析,但预计Flex系列140的价格会比Flex系列170低得多,因此二者在AI负载方面的性价比差距可能不会像媒体处理那么大。如果事实果真如此,那这样的结果一定是英特尔有意为之。这样的设计思路能让数据中心GPU既可用于媒体处理,也能用于云游戏,同时在AI推理中也有不错的表现。毕竟AI推理在数据中心内的占比正持续提高,甚至成为在各类应用程序中广泛嵌入的工作负载类型。

还有很多未解之谜

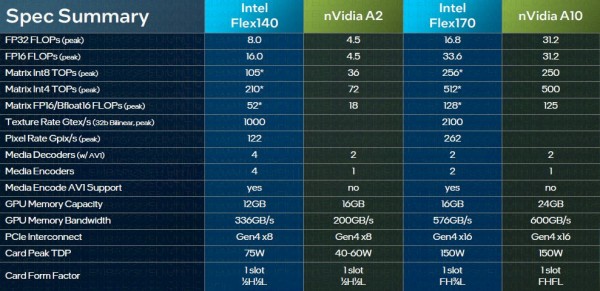

英伟达刚刚发布了支持光线追踪、视频编码和AI推理处理功能的“Lovelace”AD102数据中心GPU。此外,新款英伟达L40 GPU加速器的细节尚未披露,所以英特尔没办法拿来跟Flex系列140和170做直接比较。但结合已知信息,英特尔还是把自家数据中心GPU同英伟达的A2和A10设备摆上了擂台:

AI在应用程序内的一大典型嵌入案例,就是在流视频中使用AI推理进行对象分类与对象检测。英特尔拥有一款名为DLStreamer的新工具,能够优化至强SP CPU和Flex系列GPU的使用方式,从而在视频流输入中实现对象识别,如下图所示:

从上图下方可以看到,当DLStreamer在CPU和GPU上运行部分代码时,解码视频并在流上运行Yolov5对象检测模型的吞吐量规模提升了67%。CPU-GPU组合合计驱动150个流,其中Flex系列GPU负责驱动90个流。

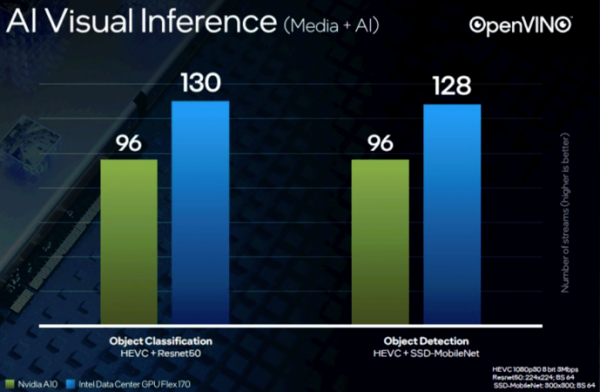

但真正有说服力的,还是英伟达加速器与Flex系列GPU在同类工作负载上的直接比较。这里英特尔选择了Resnet50进行对象分类,并使用SSD-MobileNet进行对象检测:

其中Flex系列170在视频流中的对象分类性能比英伟达A10高35.4%,视频流内对象检测的性能则高出33.3%。

在明确了英特尔设备的定价之后,我们就能对两大阵营的产品做出可靠的价格/性能分析。这里,我们就先以倒推的方式预测一下英特尔可能设置的产品价格。

如果是从HPE和CDW那边购买英伟达A10,那么售价约为8400美元;而在戴尔这边则可低至5700美元。如果按同等视频推理能力计算,那英特尔可以将Flex Series 170的价格设定在11200美元——不过我们很难相信芯片巨头会定下这么离谱的价位。而如果把Flex系列170也按8400美元计算,那么英特尔产品的性价比将高出25%,按6400美元计算其价格/性能比更是高出43%。

作为刚刚重返GPU计算市场的“新玩家”,英特尔比较合理的作法肯定是降低收费、提供更高性能,所以客户应该能在这场供应商比拼中迎来值得期待的收益。

好文章,需要你的鼓励

Cyera获得4亿美元融资专攻AI数据安全,估值达90亿美元

人工智能和数据安全公司Cyera宣布完成4亿美元后期融资,估值达90亿美元。此轮F轮融资由贝莱德领投,距离上次融资仅6个月。随着95%的美国企业使用生成式AI,AI应用快速普及带来新的安全挑战。Cyera将数据安全态势管理、数据丢失防护和身份管理整合为单一平台,今年推出AI Guardian扩展AI安全功能。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

SAP推出全新AI功能助力零售业数字化转型

SAP在2026年全国零售联盟大展上发布了一系列新的人工智能功能,将规划、运营、履约和商务更紧密地集成到其零售软件组合中。这些更新旨在帮助零售商管理日益复杂的运营,应对客户参与向AI驱动发现和自动化决策的转变。新功能涵盖数据分析、商品销售、促销、客户参与和订单管理等领域,大部分功能计划在2026年上半年推出。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

SAP推出全新AI功能助力零售业数字化转型

Gmail推出个性化AI收件箱与智能搜索等多项新功能

CISA警告HPE OneView和微软Office漏洞正被活跃利用

谷歌削减Android开源代码发布频率至每年两次

高通CES 2026:扩展IE-IoT产品组合推进边缘AI发展

恩智浦发布S32N7处理器系列,加速AI驱动汽车发展

n8n自动化平台严重漏洞可让攻击者完全控制服务器

微软将在Copilot中直接集成购买按钮功能

Snowflake收购Observe拓展AI驱动监控能力

丰田升级SUV产品线,RAV4新增信息娱乐系统

可信开源软件现状报告:AI重塑技术栈基线

思科修复ISE安全漏洞,公开概念验证代码已发布