英伟达展示设计蓝图,硅光连接GPU系统初步成形

近年来,硅光技术已经成为行业讨论中的热点话题,很多朋友也急切盼望着它能尽快普及、服务市场。十年前关于实用性硅光互连的讨论曾陷入困境,好在如今信号传输技术重新迈开发展的脚步,在我们最需要它的时候渐渐发展成形。

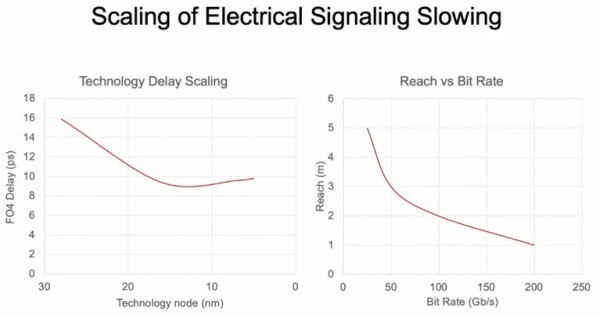

当初纯电路互连具有压倒性的成本优势,相当于占据了“价格/性能”等式中的分子部分,而硅光技术的亮点则主要体现在性能这个分母上。随着时间推移,传输带宽越来越大,电信号波长则变得越来越短,于是噪声问题日益严重。转折性的一天终于到来,我们开始将电磁信号载体由电子转换为光子,信号传输介质也由铜导线转为光纤导线。

下图中的曲线来自英伟达首席科学家Bill Dally在今年3月光纤通信会议上发表的演讲,很好地反映了这种趋势:

这些曲线本身代表着客观规律,但我们也可以通过一点材料学魔法再稍做改变。

几周之前,英伟达刚刚与Ayar Labs签署了合作研发协议。为此,我们有幸采访了这家硅光初创公司CEO Charlie Wuischpard,讨论英伟达和Ayar接下来的工作计划。英伟达还参与了Ayar Labs今年年初进行的C轮融资,期间他们筹集到1.3亿美元,用于开发带外激光器与硅光互连方案。HPE也在今年2月与Ayar Labs签署一项协议,共同研究如何将硅光技术引入自家的Slingshot互连系统,而且HPE同样参与了今年4月Ayar 的C轮融资。就连英特尔也提供了不少早期支持,只是芯片巨头希望将激光器嵌入到芯片内部,而不是像Ayar Labs那样从芯片外部泵入激光信号。顺带一提,目前英特尔的运营形势相当不妙,几乎可以说是不容有失,所以用硅光技术来对冲风险应该是个好选择。

在今年4月融资期间,我们曾与Wuischpard详细探讨过硅光技术在现代系统中的适用区和不适用区。根据最近得到的消息,英伟达似乎也在为此专门规划设计蓝图。

之后就是Dally在2022年光纤通信会议上发布的上述演示了,其中非常详尽地阐述了使用密集波分复用(DWDM)技术的共封装光学器件,以及如何利用硅光传输实现机架间及GPU计算引擎间的交叉连接。

演示文稿中还展示了一台没有正式定名的概念设备,类似于Dally团队早在2010年就设计出的“Echelon”百亿亿次概念系统。这台设备采用特殊的数学引擎、而非GPU,各引擎间采用高基数电气交换机和克雷“Aries”设备机架间的光学互连设计。当初的Echelon设备一直未能商业化,英伟达于是转而选择Dally在英伟达研究院中设计出的NVSwitch内存互连,并很快将其投入生产,希望制造出基于胖多端口InfiniBand互连通道的大型NUMA GPU处理器。

在最初基于NVSwitch的DGX系统中,英伟达可以通过“Volta”V100 GPU加速器在单一图像中使用16个GPU;而到“Ampere”A100 GPU加速器时,为了让每个GPU实现带宽翻倍,他们只能将NVSwitch的基数削减一半,所以单一图像中只能使用8个GPU。但伴随着今年早些时候公布的NVSwitches叶/脊网络以及将于今年晚些时候出货的“Hopper”H100 GPU加速器,英伟达已经可以将256个GPU融入统一内存结构,由此实现巨大的性能改进。

但归根结底,作为DGX H100 SuperPOD的核心,NVSwitch结构在本质上仍然是一种对NUMA直接放大的方法,而且必然受到线缆布局的限制。而且即使是到了Hopper这一代,NVSwitch的规模也不可能支持超大规模厂商将数万个GPU捆绑在巨型AI工作负载当中。

Wuischpard在采访中笑道,“我暂时还不能透露太多细节。简单来讲,这是一个物理层面的解决方案,在此之上还有软件,还要对GPU、内存和CPU进行编排。这里我们不谈具体细节,总之你可以把它理解成我们对于未来支持需求的物理性探索。这将会是一项长期、多阶段的探索,我们的目标就是用参数证明自己,逐步跨过一个个发展里程碑。”

虽然了解不到更多细节,但我们不妨回归Dally在光纤通信会议上的演讲,看看英伟达如何谋划未来基于硅光互连的GPU加速系统。

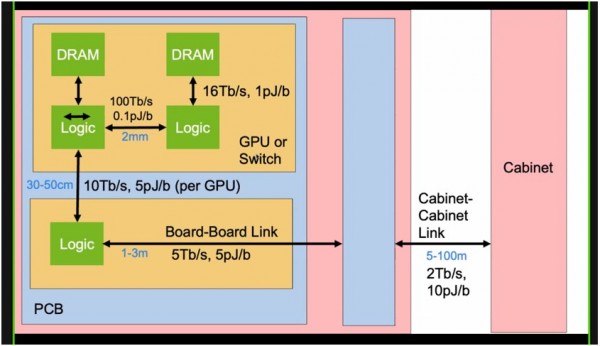

在进入正题之前,我们先来看看GPU或交换机之间的带宽和功率限制,二者接入的印刷电路板,以及承载它们的机柜。正是这些现实因素,为硅光互连的出现奠定了基础:

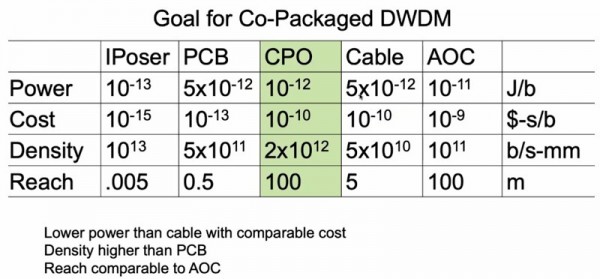

这里的规律非常简单。链路越短,传输带宽就越大,数据转移消耗的能量也越小。下表列出的中介层、印刷电路板、共封装光学器件、线缆及有源光缆各自对应的功率、成本和密度,这些都是现代系统中不同层次所使用的线缆:

使用DWDM共封装光学器件的目的,是在保持相似的成本、与有源线缆相当的传输范围以及与印刷电路板类似的信号密度的同时,获得比线缆更低的功耗。

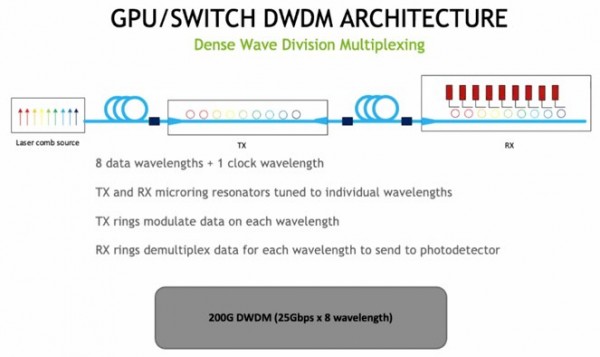

Dally还公布了下面这份DWDM信号传输草图:

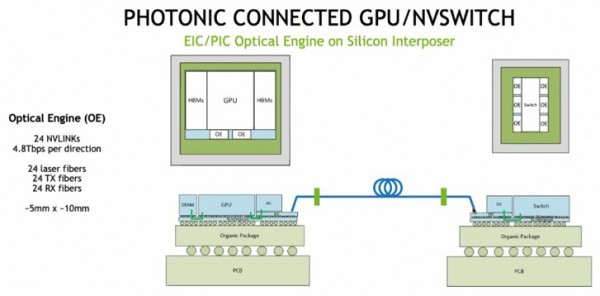

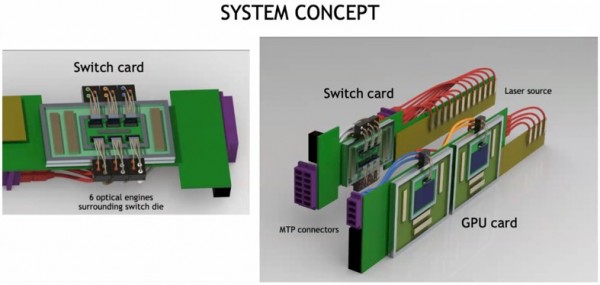

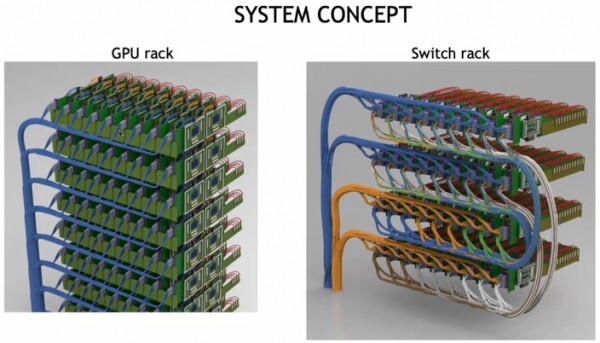

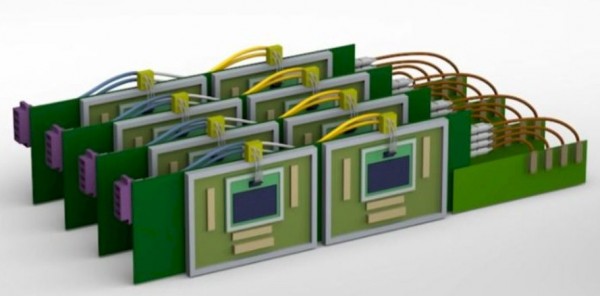

以下框图,展示了GPU与NVSwitch如何使用光引擎将电信号转换为光信号,借此为GPU创建NVSwitch网络:

每个光学引擎包含24根光纤,初步信号传输速率为200 Gb/秒,总带宽为4.8 Tb/秒。每个GPU对应两个光学引擎,用以提供基于NVSwitch结构的双工传输带宽。因此,包含6个光学引擎的NVSwitch初始速率为28.8 Tb/秒,去除编码占用的带宽后为25.6 Tb/秒。

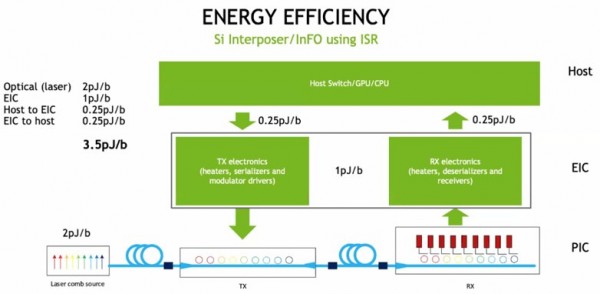

下图所示,为英伟达硅光概念设备中各组件间的能耗计算方式:

GPU与交换机之间的数据移入与移出操作,每比特消耗3.5皮焦耳能量,与Dally在上表中设定的目标完全一致。但我们怀疑功耗成本还要再低一些,才能让计算引擎接受这种将光学器件纳入封装的设计思路。英伟达正在为此积极努力,相信后续还会有更多亮眼表现。

目前DGX-A100系统上嵌入的NVSwitch结构,使用的电信号传输范围约为300厘米,数据传输功耗则为每比特8皮焦耳。下阶段的发展目标是用硅光传输将功耗降低一半,并将设备间的传输距离提高到100米。

在达成以上目标后,架构中的GPU跟交换机就可以彼此拆分。虽然英伟达的概念机并没有提及这一点,但CPU也可以匹配光学引擎,实现同样的拆分效果。

下图为带有共封装光学器件的GPU与交换机外观:

下图则为GPU与采用CPO链路的NVSwitch的连接方式:

虽然外部激光源会占用不少空间,但这也意味着设备间的连接距离可以放大,让机架密度显著降低。这样冷却系统更易于部署,激光器也能实现更换。于是,整套系统的运行温度将有所下降,激光器工作效果提升。以DGX系统为例,目前的设备密度其实已经太高,导致机器运行温度过热。为了匹配大部分数据中心的功率密度和冷却部署能力,机架内的实际安装空间恐怕只能用掉一半。

细心的朋友可能还注意到,上图中的GPU和交换机是垂直放置的,这样同样有助于冷却。而且它们也没有安装在带插槽的巨型印刷电路板上,这样可以降低系统整体成本,省下来的钱也许可以抵消额外的光互连开支。

好文章,需要你的鼓励

CES 2026最佳科技产品盘点:三折手机与超薄电视

CES 2026展会上发布了多款创新产品:三星Galaxy Z TriFold三折叠手机在韩国发布,Q1将登陆美国;GE智能冰箱配备包装扫描功能,售价4899美元;Clicks推出BlackBerry风格的安卓通讯设备;LG发布Gallery电视和CLOiD家用机器人;三星Family Hub冰箱支持语音开关门;SwitchBot推出球形RGB台灯;LG推出9mm超薄无线OLED电视。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

亚马逊Alexa+向公众开放早期体验网站

亚马逊宣布通过Alexa.com网站向所有用户开放Alexa+生成式AI助手的免费早期试用。此前用户需要支持设备才能使用Alexa+,现在可直接通过浏览器访问,与ChatGPT等竞品看齐。试用期结束后,Alexa+将包含在Prime会员服务中或单独收费20美元/月。网页版支持跨设备同步聊天记录和个性化设置,主打家庭管理功能如行程规划、待办清单和智能家居控制。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

AI智能宠物健康监测站:竟说我是生病的猫

CES 2026最佳科技产品盘点:三折手机与超薄电视

亚马逊Alexa+向公众开放早期体验网站

Infinidat创始人破产问题影响联想收购进程

苹果Journal应用登陆iPadOS 26,iPad用户迎来完整日记体验

MacBook Pro即将迎来重大改版,超薄设计引发争议

AWS悄然上调GPU价格15%,云计算定价逻辑生变

六成美国成年人用ChatGPT问诊,OpenAI嗅到商机

第三代英特尔酷睿Ultra处理器,CES 2026正式发布

CES 2026 | 撕碎“显存墙”,重塑“光追梦”,打通“生态路” AMD开启全新“统治力”

英伟达推出Alpamayo开源AI模型,让自动驾驶汽车"像人类一样思考"

HPE Unix系统HP-UX正式终结42年历史