Orin开发套件07-配置DS容器Python开发环境

对于熟悉C++的开发人员来说,前一篇文章将DeepStream Samples版容器的范例搬到本机上,再搭配Docker路径映射方式就能轻松搭建开发环境。但这种方式只适用于C/C++范例,并不适用于DeepStream的Python环境,因为还需要安装Gstreamer的Gst-Python与DeepStream的PyBinding与两个元件。

我们可以在容器内安装这两个元件,但是前面提供的Docker指令中使用“--rm”参数,一旦退出容器之后就会销毁这个调试好的环境,这对于使用来说是非常不方便的,因此必须做出调整,将调试好的环境保留下来,甚至于存成一个独立的镜像文件,就能方便日后的重复使用或移植工作。

- 将容器调整为“后台运行”执行:

在NGC官方提供的指令中使用“--it”与“--rm”是为了能快速启用容器,并且在使用完毕后删除容器以避免占用不必要的资源,现在我们来做以下调整:

- 将“-it”参数改成“-id”参数:这样虽然不会第一时间进入容器内执行,但是会让这个容器在后台运行,并且打印容器ID,后面在使用“docker exec”指令来进入容器操作,这是个非常实用的方式,大家可以好好学习使用方法;

- 去除“--rm”参数:退出容器之后自动移除;

- 添加“--name”参数:为了便于管理,不需要去面对长达12码的容器编号,我们可以用这个参数去指定容器名称,方便后面的操作。

- 为了配合Python的iot应用范例,建议选择iot版容器的适用性会比较高。

现在试着执行以下指令,创建一个要配置Python开发环境的DeepStream容器:

|

$ |

docker run -id --name=ds_python --net=host --runtime=nvidia -e DISPLAY=$DISPLAY \ -w /opt/nvidia/deepstream/deepstream -v /tmp/.X11-unix/:/tmp/.X11-unix \ -v ~/deepstream/sources:/opt/nvidia/deepstream/deepstream/sources \ -v ~/deepstream/samples:/opt/nvidia/deepstream/deepstream/samples \ nvcr.io/nvidia/deepstream-l4t:6.1-iot |

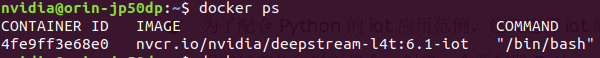

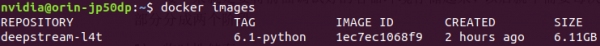

执行之后,会发现命令终端并未进入容器里面,依旧在本机(容器外)的状态,现在执行“docker ps”指令,会看到如以下的状态:

这里显示有个名为“ds_python”的容器处于运行状态,但是我们还没有进入这个容器的操作环境中。

- 使用docker exec指令进入容器:

现在以deepstream-l4t:6.1-iot创建的ds_python容器已经在后台启动,我们只要使用“docker exec”指令就能进入容器内操作,请执行以下指令:

|

$ |

docker exec -it ds_python bash |

这样就能进到容器里面。现在试试在容器内做些事情,例如创建一个目录、添加一个文件,然后执行“exit”退出容器,然后再执行前面的指令重新进入容器内,检查看看刚刚所做的修改应该还存在,这样就能确保我们为容器安装的内容可以保留。

- 重启系统之后的容器启动:

这种容器创建的方式,在系统重启之后还能保留前面的设定吗?重启一次系统就知道了,然后执行“docker ps”指令检查状态,发现看不到前面所创建的ds_python容器了,怎么办呢?

不用紧张,现在执行“docker ps -a”指令,就会发现这个容器依旧存在于背景资源中,只是没有启动而已,现在执行以下指令:

|

$ $ |

docker start ds_python docker ps |

现在再重新执行下面指令,就能进入容器里:

|

$ |

docker exec -it ds_python bash |

再检查看看前面所做的修改是否依然存在?现在就能确认这种方式能将容器的修改长期保留,是一种更加实在的用法。

- 为容器安装Python开发环境

现在可以在容器内按照https://github.com/NVIDIA-AI-IOT/deepstream_python_apps的“HOW-TO Guide”安装步骤,调试DeepStream的Python开发环境:

- 安装依赖库:

如果Jetson的操作系统是Ubuntu 20.04(JetPack 5.0以上),请执行以下的依赖库安装步骤:

|

$

|

apt install python3-gi python3-dev python3-gst-1.0 python-gi-dev git python-dev \ python3 python3-pip python3.8-dev cmake g++ build-essential libglib2.0-dev \ libglib2.0-dev-bin libgstreamer1.0-dev libtool m4 autoconf automake \ libgirepository1.0-dev libcairo2-dev |

- 从GITHUB仓下载源码到指定目录:

|

$ $ $ $ |

cd sources git clone https://github.com/NVIDIA-AI-IOT/deepstream_python_apps cd deepstream_python_apps git submodule update --init |

- 安装Gst-Python

|

$ $ $ $ $$ |

apt update apt-get install -y apt-transport-https ca-certificates -y update-ca-certificates cd 3rdparty/gst-python/ ./autogen.sh make && make install |

- 安装PyBinding:

请参照如下链接:

https://github.com/NVIDIA-AI-IOT/deepstream_python_apps/blob/master/bindings/README.md

现在就完成了Python环境的配置。

- 测试Python范例

要验证环境是否调试完成的最简单方法,就是执行一个最基础的deepstream-test1范例,请在容器内执行以下指令:

|

$ $ $ |

cd /opt/nvidia/deepstream/deepstream/ cd sources/deepstream_python_apps/apps/deepstream-test1 ./deepstream_test_1.py ../../../../samples/streams/sample_720p.h26 |

正常运行会看到如下图的执行结果。

这样就表示DeepStream容器的Python开发环境已经安装成功。

- 重复使用调试好的容器

接下来就是要将前面调试好的容器环境存储起来,以后就不需要每次调试一次环境。这部分分成三个阶段:

- 临时性保存:

事实上前面使用“-id”指令之后,这个容器就会一直保留在背景中执行,即便重启系统后也是存在的,如同前面所提供的,只要执行以下指令就能重新进入这个容器:

|

$ $ |

sudo xhost +si:localuser:root docker start ds_python && docker exec -it ds_python bash |

- 储存成Docker镜像:

现在需要在打开一个命令终端,使用“docker commit <容器名> <镜像名>”指令,将目前执行的容器存成一个镜像,请执行以下指令:

|

$ |

docker commit ds_python deepstream-l4t:6.1-python |

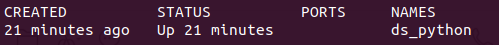

现在执行“docker images”指令,可以看到多了一个“deepstream-l4t:6.1-python”镜像,如下图所示:

只要不重装系统或者删除这个镜像,那么这个镜像就会一直保留在系统里面,以后如果需要再次使用,只要执行以下指令即可:

|

$ $ |

sudo xhost +si:localuser:root sudo docker run -it --rm --net=host --runtime nvidia -e DISPLAY=$DISPLAY -w /opt/nvidia/deepstream/deepstream -v /tmp/.X11-unix/:/tmp/.X11-unix -v ~/nvme/deepstream/sources:/opt/nvidia/deepstream/deepstream/sources -v ~/nvme/deepstream/samples:/opt/nvidia/deepstream/deepstream/samples deepstream-l4t:6.1-python |

或者可以同时启动多个独立的Python环境DeepStream容器,如下指令:

|

$ $ |

sudo xhost +si:localuser:root sudo docker run -id --name=ds_python2 --net=host --runtime nvidia -e DISPLAY=$DISPLAY -w /opt/nvidia/deepstream/deepstream -v /tmp/.X11-unix/:/tmp/.X11-unix -v ~/nvme/deepstream/sources:/opt/nvidia/deepstream/deepstream/sources -v ~/nvme/deepstream/samples:/opt/nvidia/deepstream/deepstream/samples deepstream-l4t:6.1-python |

- 导出成文件:

最保险的方式,就是将这个deepstream-l4t:6.1-python镜像导出成文件,自行保存好,这样即便系统重新安装后,也能直接从这个文件载入镜像,然后开启工作容器:

|

$

$ |

# 将镜像导出成文件 sudo docker save deepstream-l4t:6.1-python -o jp50dp_ds61_python # 将文件载入成镜像 sudo docker load -i jp50dp_ds61_python |

现在,这个导出的jp50dp_ds61_python压缩文件,也能部署到其他JetPack 5.0DP所安装的Jetson设备上使用,不需要在每台机器上重复调试Python开发环境。

来源:业界供稿

好文章,需要你的鼓励

埃森哲投资Profitmind,押注AI智能体变革零售业

埃森哲投资AI零售平台Profitmind,该平台通过智能代理自动化定价决策、库存管理和规划。研究显示AI驱动了2025年假日购物季20%的消费,约2620亿美元。部署AI代理的企业假日销售同比增长6.2%,而未部署的仅增长3.9%。Profitmind实时监控竞争对手价格和营销策略,并可创建生成式引擎优化产品文案。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币