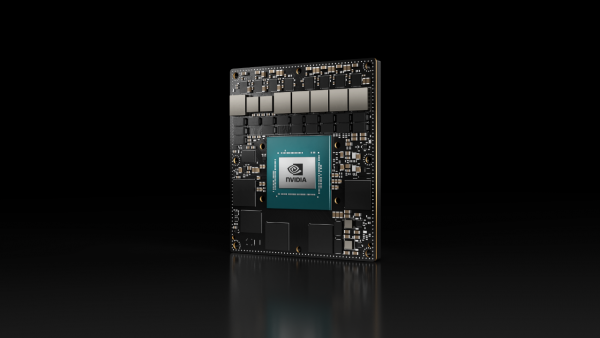

Nvidia发布首个用于生产部署的Jetson AGX Orin模块

Nvidia即将推出Jetson AGX Orin平台的一款生产用模块,旨在嵌入设备内部,并为机器人和边缘计算等各种应用提供AI加速。

Jetson AGX Orin 32GB生产模块将结合一个基于Nvidia Ampere架构的GPU以及一个基于Arm的8核Cortex-A78AE CPU,还有32GB内存和64GB嵌入式(eMMC)闪存存储,搭载在一块尺寸为100mm x 87mm(比Raspberry Pi略大)的板子上。

不过,Jetson AGX Orin 32GB模块的价格比Raspberry Pi的价格要高得多,高达999美元(约合817.32英镑),这让任何感兴趣的用户都有些失望了。

这个模块是Nvidia今年早些时候在GTC大会上公布的四款基于Jetson Orin的生产模块中的第一款,除此之外,Nvidia还推出了Jetson AGX Orin开发工具包。Jetson AGX Orin的64GB版本将于10月上市,而另外两款功能相对弱一些的Orin NX生产模块将于今年晚些时候上市。

根据Nvidia提供的规格数据显示,Jetson AGX Orin 32GB模块每秒可进行200万亿次运算(TOPS),低于开发者套件中硬件的275 TOPS,后者拥有2048核Ampere架构的GPU。而Jetson AGX Orin 32GB中的是1792核GPU。不过据称该模块的性能是此前Jetson Xavier一代模块的6倍。

据Nvidia称,全球合作伙伴网络中约有三十多家技术提供商已经上市了由这款新模块驱动的商用产品。

与开发者工具包一样,这款生产模块采用Nvidia Jetson软件堆栈,让开发者能够在Jetson上构建和部署完全加速的AI应用,包括Nvidia JetPack SDK开发环境,以及用于调整性能的CUDA-X库和工具集合。

Nvidia还表示,Nvidia提供的其他平台也可以采用这款Jetson AGX Orin 32GB模块,例如用于机器人技术的Isaac、用于计算机视觉的DeepStream、用于自然语言理解的Riva,以及使用训练模型加速模型开发的TAO工具包。

该模块提供了一系列I/O选项,从2 x8、1x4 和2 x1 PCIe 4.0通道、千兆位和万兆以太网端口、8K显示输出和USB端口,此外还提供了更多的UART、SPI、I2S和I2C端口,以及CAN总线和GPIO。但是,其中一些I/O选项是共享通用PHY (UPHY)连接器上的通道。

据Nvidia称,这些功能让开发者能够构建和部署Orin驱动的系统,这些系统配备了摄像头、适用于边缘AI、机器人、物联网和嵌入式应用的传感器。

Nvidia表示,合作伙伴将提供可用于生产的系统,让客户能够应对从制造、零售和建筑到农业、物流、医疗保健和智慧城市等行业面临的各种挑战。

来源:至顶网计算频道

好文章,需要你的鼓励

软银完成对OpenAI的225亿美元投资,持股比例达11%

软银集团已完成对OpenAI的400亿美元投资,向其转账225亿美元。此次投资使软银获得约11%的OpenAI股份,成为仅次于微软的第二大投资者。OpenAI将利用这些资金推进Starlink数据中心项目,计划到2029年在美国部署100亿瓦的计算能力。为完成此次投资,软银出售了部分投资组合资产,包括英伟达和T-Mobile股票,并以ARM股份作抵押获得贷款。

MBZUAI和法国综合理工学院最新突破:让AI写作比人工快4倍的神奇算法

MBZUAI和法国综合理工学院联合开发的SchED算法能让AI写作速度提升3-4倍。该算法通过监测AI生成文本的置信度,采用进度感知的动态阈值策略,在保持99.8%-100%原始质量的同时显著减少计算时间。实验覆盖多种任务类型,证明了算法的有效性和鲁棒性。

苹果在2026年笔记本电脑出货量下滑中占据有利地位

TrendForce将2026年笔记本市场预测下调至1.73亿台,同比下降5.4%。报告指出,若内存短缺未改善,下滑幅度可能达10.1%。尽管面临挑战,苹果预计将在2026年春季推出低成本MacBook,并凭借供应链效率和规模优势减少影响。IDC警告称,由于AI数据中心需求激增导致内存芯片严重短缺,PC出货量可能下滑9%,平均售价将上涨4-8%。

西安交通大学突破性发现:让AI“忽略“功能词,视觉语言模型免费获得超强防御力

西安交通大学研究团队发现,AI视觉语言模型容易受到功能词(如"是"、"的"等)的干扰而遭受攻击。他们开发了功能词去注意力(FDA)机制,让AI减少对这些词汇的关注。测试显示,该方法可将攻击成功率降低18%-90%,而正常性能仅下降0.2%-0.6%。FDA无需额外训练即可集成到现有模型中,为AI安全防护提供了简单有效的解决方案。