大缓存更强劲,搭载AMD Milan-X的浪潮GPU服务器NF5468A5深度评测

据近日业界发布的评测报告显示,以浪潮GPU服务器NF5468A5为平台,搭载2颗AMD Milan-X 7773X运行常见的气象应用WRF和计算流体力学应用OpenFOAM作为性能基准测试,其性能相比搭载两颗Rome 7742时的计算性能提升可高达80%。

NF5468A5是一款4U支持2颗AMD EPYC处理器和8颗双宽GPU卡,面向AI训练、推理、视频编解码等多种应用场景的GPU服务器。此次测试采用分别搭载2颗AMD Milan-X 7773X、Milan 7543和Rome 7742的配置组合。

AMD Milan-X处理器最大的亮点,就是采用3D堆叠技术(3D V-Cache),在不改变处理器面积的前提下,可用L3 缓存(SRAM)总数增加三倍。做个形象的比喻,这种3D堆叠技术就像将把相同面积的平房升级成三层小楼,通过纵向空间成倍扩展缓存数量。评测采用的NF5468A5平台是浪潮信息畅销海内外的弹性云AI服务器NF5468系列的全新产品,率先支持PCIe 4.0技术,4U空间内可装载2颗采用7nm先进制程工艺的AMD EPYC处理器和8块PCIe Gen4接口的AI加速卡,能够最大限度的发挥Milan-X处理器的极致性能。

WRF(The Weather Research and Forecasting Model),即天气预报模式,被誉为是次世代的中尺度天气预报模式,往往用于大范围高分辨的气候模拟,对系统的运算性能、内存的要求非常高;OpenFOAM(Open Source Field Operation and Manipulation)是对连续介质力学问题进行数值计算的软件,经常应用于汽车仿真等行业,进行仿真计算需要处理大量的实时数据,所以对系统的计算能力、数据吞吐能力都有很高的要求。

基于浪潮NF5468A5评测报告显示,Milan-X处理器通过搭载3D堆叠技术获得更高的L3缓存,确实对计算性能有较大提升,而性能改进意味着企业可以在更少的服务器上运行相同的作业,消耗的功率也能有明显降低。如下是评测报告中的性能测试数据:

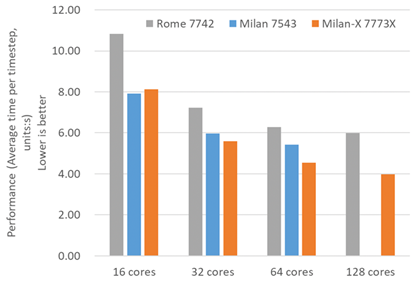

在WRF测试中,使用单节点相同核心数,以Rome 7742处理器运行时间为基准,在Milan 7543上的计算性能提升14%~27%,而在Milan-X 7773X处理器上性能提升 23%~34%。

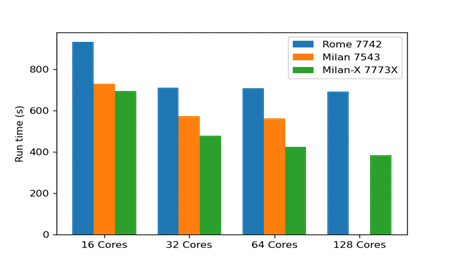

在OpenFOAM基准算例motorBike测试中,使用不可压稳态求解器simpleFoam计算模拟摩托车和骑手周围空气的运动情况。同样以Rome 7742处理器为基准,OpenFOAM在Milan 7543处理器使用单节点相同核心测试性能提升23%~28%,在Milan-X 7773X处理器上性能提升34%~80%。

在本次评测中也对NF5468A5有比较细致的介绍,据浪潮官网显示NF5468A5正在推出“超值机型 限免试用”,对该GPU服务器感兴趣的不妨一试。如下是评测中对于浪潮NF5468A5的介绍:

NF5468A5采用分区散热设计,内置独立的CPU和GPU主板,且分别安装在不同的平面。从机箱内部结构来看,设计者将发热量高的的GPU放在了机箱上3U空间,CPU板处于机箱下1U,内置6对12个6056风扇模组配合导风罩,实现机箱内风道分流,正是基于这种独特分层散热设计,使得送测的NF5468A5服务器可以支持280W最高功耗的Milan-X 7773X。系统设计支持32条DDR4 ECC内存,支持LRDIMM/RDIMM,提供高达8T的本地内存,实现与1536 MB 超大L3 cache间的高速数据交互。

NF5468A5采用了CPU直连GPU架构设计,率先支持PCI-E 4.0技术,最大限度提升CPU与GPU间的带宽,降低通信延迟,达到最佳效能,为客户提供极致优化的算力。系统提供丰富的IO扩展能力,提供10个PCIe 4.0 X16扩展槽位,支持8个全高全长的GPU加速卡。提供灵活存储方案,可选前置12 × 3.5英寸硬盘或24 × 2.5英寸硬盘,提供超大的本地存储能力,同时最大可支持8个热插拔NVMe SSD全闪配置,提供存储到内存到L3 cache的高速访存,可实现十倍于高端企业级SATA SSD的IOPS性能,带来极致IO存储性能飞跃。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元

AMD 发布新一代 AMD RDNA(TM) 4 架构,推出 AMD Radeon(TM) RX 9000 系列显卡

苏姿丰的十年历程回顾:AMD如何从英特尔廉价替代品成长为x86领域的有力竞争者

面临AMD及自身内部挑战,英伟达Green 500主导地位受到威胁

微软率先拿下HBM驱动的AMD CPU供货

基于 AMD 加速器的 El Capitan 首次登全球超算500强榜首

突发!AMD大爆雷!

AMD Versal家族再添新成员 ——打破AI内存桎梏 支持CXL 3.1

AMD超低时延金融加速卡 帮你跑赢高频交易“竞速赛”!

要超越英伟达,AMD还须十年时间

深度剖析:聊聊英特尔与AMD各自不同的CPU整合思路