MLPerf最新发榜,浪潮AI服务器囊括数据中心推理全部冠军

2022年4月7日,全球权威AI基准评测MLPerf™公布最新AI推理(Inference)V2.0榜单,浪潮AI服务器以最高性能获得了数据中心(固定任务)的全部16项冠军。

MLPerf™由图灵奖得主大卫•帕特森(David Patterson)联合顶尖学术机构发起成立,是国际最权威的AI性能基准评测,每年组织AI推理和AI训练测试各两次,以对迅速增长的AI计算需求与性能进行及时的跟踪测评。MLPerf™比赛通常分为固定任务(Closed)和开放优化(Open)两类任务,开放优化能力着重考察参测厂商的AI技术创新力,固定任务则因更公平地考察参测厂商的硬件系统和软件优化的能力,成为更具参考价值的AI性能基准测试。

本次是2022年MLPerf™的首次AI推理性能评测,旨在考察在各类AI任务中,不同厂商计算系统的推理速度和能力。本次评测中,在竞争最激烈的数据中心(固定任务)赛道,共有926项成绩提交,数量较上次比试翻倍,竞争非常激烈。

浪潮AI服务器创推理性能新纪录

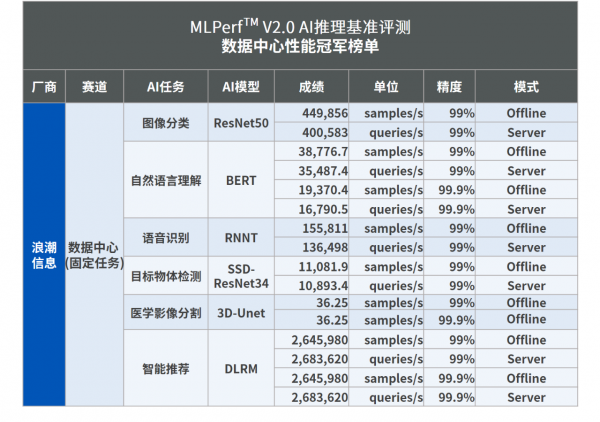

本次MLPerf™AI推理性能评测涵盖使用广泛的六大AI场景,包括图像分类、自然语言理解、语音识别、目标物体检测、医学影像分割、智能推荐,每个场景采用最主流的AI模型作为测试任务,分别为ResNet50、BERT、RNNT、SSD-ResNet34、3D-Unet、DLRM。MLPerf™测试要求模型推理精度达到99%以上,对于自然语言理解、医学影像分割和智能推荐3个任务则设置99%与99.9%两种精度要求,以考察当提升AI推理精度要求时对计算性能的影响。

为更加贴近实际应用情况,MLPerf™推理测试在数据中心赛道下设置了离线(Offline)与在线(Server)两种模式。离线模式代表任务所需所有数据都在本地可用,典型场景如大批量医疗影像样本存于本地等待统一识别。在线模式则反映了大部分的即时AI应用,其数据和请求以突发和间歇的方式在线送达,例如用户在浏览购物网站时智能推荐的推理请求。

浪潮AI服务器此次表现出色,以最高性能包揽了此次MLPerf™数据中心(固定任务)赛道的全部16项冠军。

本次MLPerf™测试中,浪潮AI服务器在ResNet50模型任务中创造了每秒处理449,856张图片的性能纪录,相当于仅用2.8秒即完成ImageNet数据集128万张图片的分类;在3D-UNet模型任务中,创造了每秒处理36.25张医疗影像的新纪录,相当于在6秒内完成对KiTS19数据集207张3D医疗影像的分割;在SSD-ResNet34模型任务中,创造了每秒对11,081.9张图片完成目标物体识别及定位的新纪录;在BERT模型任务中,创造了平均每秒完成38,776.7个问答的性能纪录,在RNNT模型任务中,创造了每秒将155,811段语音转为文字的性能纪录,在DLRM模型任务中,则创造每秒实现2,645,980次点击预测的最佳性能纪录。

此外,本次MLPerf™评测还设有边缘推理赛道,浪潮面向边缘场景设计的AI服务器同样表现出色,在边缘固定任务赛道的全部17项任务中斩获了11项冠军。

随着AI应用在各个行业中的持续深化,更快的推理速度,将带来更高的AI应用效率与能力,加速产业智能化转型。相比半年前的MLPerf™AI推理榜单V1.1,浪潮AI服务器将图像分类、语音识别和自然语言理解任务的推理性能分别提升31.5%、28.5%及21.3%,意味着浪潮AI服务器在自动驾驶、语音会议、智能问答和智慧医疗等等场景中,能够更高效快速地完成各类智能任务。

全栈优化能力助推AI性能持续提升

浪潮AI服务器在MLPerf™基准评测中的出色表现,得益于浪潮信息卓越的AI系统设计能力和全栈优化能力。

本次参与测评的浪潮AI服务器NF5468M6J拥有出色的系统设计,以分层可扩展计算架构在业界率先实现对12颗NVIDIA A100 Tensor Core GPU的支持,并以极佳的性能成绩一举揽获12项冠军。浪潮信息也是本次MLPerf™竞赛中可以唯一提供服务器支持8颗500W NVIDIA A100 GPU的厂商,并实现了风冷及液冷两种散热方式。在此次参赛的8颗GPU NVLink高端主流机型中,浪潮AI服务器在数据中心16个任务中斩获14项最佳成绩,展现出在高端机型中的领先优势。其中,NF5488A5是全球首批上市的A100服务器,在4U空间支持8颗第三代NVlink互联的NVIDIA A100 GPU和2颗AMD Milan CPU。NF5688M6是面向大规模数据中心优化设计的具备极致扩展能力的AI服务器,支持8颗A100 GPU和2颗Intel Icelake CPU,支持多达13张PCIe Gen4的IO扩展卡。

在硬件层面,浪潮AI服务器通过对CPU、GPU硬件性能的精细校准和全面优化,使CPU性能、GPU性能、CPU与GPU之间的数据通路均处于对AI推理最优状态;在软件层面,结合GPU硬件拓扑对多GPU的轮询调度优化使单卡至多卡性能达到了近似线性扩展;在深度学习算法层面,结合GPU Tensor Core 单元的计算特征,通过自研通道压缩算法成功实现了模型的极致性能优化。

浪潮信息是全球领先的AI计算厂商,AI服务器市场份额全球第一,连续五年以超50%的市场份额稳居中国AI服务器市场第一。浪潮信息致力于AI计算平台、资源平台和算法平台的研发创新,并通过元脑生态携手领先伙伴加速数实相融。

来源:业界供稿

好文章,需要你的鼓励

Instagram长视频内容和个性化订阅可能即将到来

Instagram负责人莫塞里在接受采访时透露,平台正考虑引入长视频内容功能,尽管此前一直专注于短视频。他承认为了吸引优质内容,Instagram可能需要支持长视频格式。此外,Meta最近推出了"您的算法"功能,旨在让用户更好地控制信息流内容。莫塞里承诺未来将提供更多工具,让用户主动塑造个性化内容,但完整实现可能需要2-4年时间。

香港大学联合Adobe研究突破:让AI既能看懂图片又能生成美图的“万能大脑“

香港大学联合Adobe研究院提出PS-VAE技术,成功解决了AI无法同时具备图像理解和生成能力的难题。通过创新的两阶段训练策略,让AI既能准确理解图片语义,又能生成高质量图像,在图像编辑任务上性能提升近4倍,为统一视觉AI系统开辟新路径,在数字创作、教育、电商等领域具有广阔应用前景。

至顶AI实验室硬核评测:戴尔 Precision 5490移动工作站搭建Open Deep Research,打造专属于你的全流程AI研究助手

在信息爆炸的时代,AI实验室的研究员们常常需要面对海量的论文、专利文件、论坛发言等各种渠道的信息。传统的查找方式不仅费时费力,还容易遗漏关键内容。那么,有没有一种方式能让AI真正代替人工,完成从找资料到写出稿的全流程工作?

华中科技大学与马里兰大学联合发现:AI评判员可能比想象中更不靠谱

华中科技大学与马里兰大学研究团队开发出Sage评估框架,首次无需人工标注即可评估AI评判员可靠性。研究发现即使最先进的AI模型在评判任务中也存在严重不一致问题,近四分之一困难情况下无法保持稳定偏好。团队提出明确评判标准和专门微调等改进方法,为构建更可靠AI评估体系提供重要工具。

高性能 AI 边缘推理服务器MIC-743-AT

Instagram长视频内容和个性化订阅可能即将到来

NVIDIA DGX Spark

Dell Pro Max with GB10

至顶AI实验室硬核评测:戴尔 Precision 5490移动工作站搭建Open Deep Research,打造专属于你的全流程AI研究助手

惠普ZBook Fury G1i高性能移动工作站

至顶AI实验室硬核评测:夸克 AI 眼镜全链路"无切换体验",当AI助手真正走进日常

夸克AI眼镜

至顶AI实验室硬核评测:据说这就是AI手机的形态,贴脸开大,豆包手机上手评测

OpenFlex(TM) Data24 NVMe-oF(TM) 存储平台

英特尔(R) 至强(R) 6776P处理器

Solidigm D7-PS1010 E1.S 液冷固态硬盘