浪潮AI服务器再获7项MLPerf AI训练冠军,全年44项第一领跑群雄

美国东部时间12月1日,国际权威AI基准测试MLPerf™公布最新一期训练(Training)榜单V1.1。浪潮信息提交了AI服务器所有8项单机测试的固定任务(Closed Division)成绩,并斩获其中7项冠军。

MLPerf™是影响力最广的国际AI性能基准评测,本次测试吸引谷歌、微软云、英伟达、浪潮信息、百度、戴尔、联想等14家公司及科研机构参与,共提交180项固定任务成绩,6项开放任务成绩。固定任务要求参赛各方使用与参考模型等价的模型和限定的优化器,对于实际用户评测AI计算系统性能具备很强的参考意义,也一直是MLPerf™中角逐最激烈及主流厂商最关注的领域。

本次性能基准评测涵盖了8类极具代表性的机器学习任务,分别为图像分类(ResNet)、医学影像分割(U-Net3D)、目标物体检测(SSD)、目标物体检测(Mask R-CNN)、语音识别(RNNT)、自然语言理解(BERT)、智能推荐(DLRM)以及强化学习(MiniGo)。

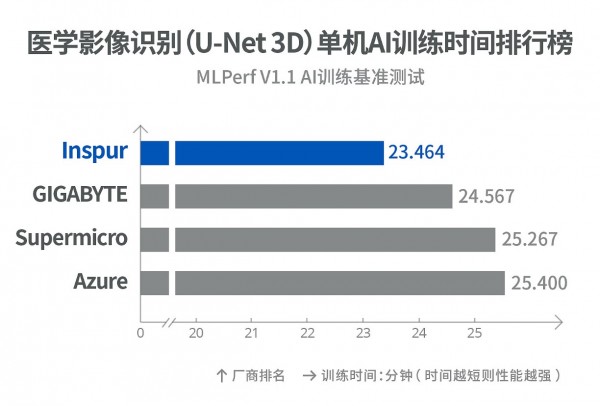

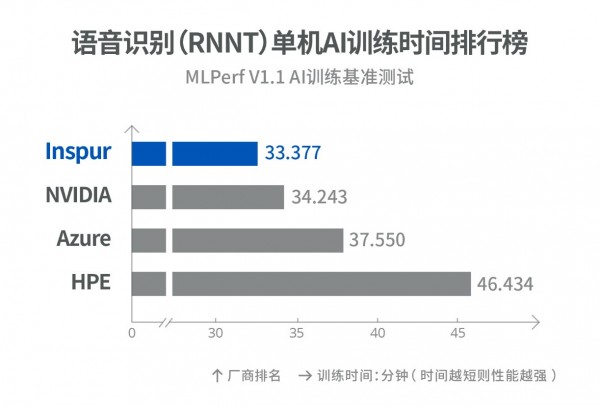

浪潮AI服务器在单机系统测试的全部8项固定任务中,获得7项冠军。其中,AI服务器NF5688M6获得医学影像分割、目标物体检测(Mask R-CNN)、自然语言理解、智能推荐4项冠军;AI服务器NF5488A5获得图像分类、目标物体检测(SSD)、语音识别3项冠军。

全栈AI能力 引领AI训练速度突破

凭借卓异的软硬件系统优化能力,浪潮AI服务器将MLPerf™训练基准的单机效率进一步提升至新的高度。相比半年前的MLPerf™ AI训练榜单V1.0,浪潮AI服务器将医学影像识别、语音识别、智能推荐和自然语言处理任务的单机AI训练速度提升18%、14%、11%和8%。

MLPerf™作为国际最权威的AI性能基准测试,不断刷新业内的AI训练速度。目前,浪潮信息是MLPerf™基准测试中医学影像分割、目标物体检测(Mask R-CNN)、自然语言理解、智能推荐、图像分类、目标物体检测(SSD)、语音识别7项AI任务的单机最快训练速度保持者。浪潮AI服务器在图像分类训练中每秒可处理27400张图片、在目标物体检测训练中每秒可处理12600张图片、在语音识别训练中每秒可处理8000段语音,引领全球AI训练速度突破,凸显出顶级AI服务器在AI模型训练效率上的巨大价值。

浪潮AI服务器在MLPerf™基准评测中的出色表现,得益于在AI计算系统创新上卓越的系统设计能力和全栈优化能力。在硬件层面,针对AI训练中常见的密集IO传输瓶颈,浪潮AI服务器以领先设计大幅降低通信延迟,极大提升了AI训练效率;同时,针对高负载多GPU协同任务调度,对NUMA节点与GPU之间的数据传输进行全面优化和深度调校,确保训练任务中的数据IO无阻塞;在散热层面,针对目前业界功率最高的A100-SXM-80GB(500W) GPU,浪潮率先开发的先进冷板液冷系统,确保GPU在全功率甚负载下依然稳定工作,将AI计算系统的性能发挥到极致。

MLPerfTM 2021年度收官 浪潮信息共获44项第一

MLCommons每年组织2次MLPerf™ 推理性能测试和2次MLPerf™ 训练性能测试。本次成绩公布意味着MLPerf™ 2021年度4次性能测试正式收官。浪潮AI服务器共斩获44项第一,名列MLPerfTM2021年度冠军榜首。

2021年,浪潮AI服务器在MLPerfTM数据中心AI推理场景的总32项任务中斩获17项冠军,在边缘AI推理场景的总31项任务中斩获16项冠军,从云到边全面领先;在单机AI训练场景的16项任务中浪潮AI服务器共斩获11项冠军。

2021年,浪潮AI服务器NF5488A5、NF5688M6以及边缘服务器NE5260M5参加到MLPerfTM竞赛中,各斩获18项、15项及11项冠军。

NF5488A5是全球首批上市的A100服务器,在4U空间支持8颗第三代NVLink互联的A100 GPU和2颗AMD Milan CPU,同时支持液冷和风冷散热技术。NF5688M6是面向大规模数据中心优化设计的具备极致扩展能力的AI服务器,支持8颗A100 GPU和两颗Intel Ice Lake CPU,支持多达13张PCIe Gen4的IO扩展卡。NE5260M5通过极致优化的信号和电源等系统设计,兼容高性能CPU和多种AI加速卡,通过减震降噪优化和严苛的可靠性测试,机箱深度430mm较普通服务器缩短近二分之一,满足空间受限的边缘计算场景部署需求。

浪潮信息是全球领先的AI计算厂商,AI服务器市场份额全球第一,中国市场份额已连续五年稳居第一。浪潮信息致力于AI计算平台、资源平台和算法平台的研发创新,并通过元脑生态与AI领先企业共同推进AI产业化和产业AI化进程。

好文章,需要你的鼓励

微软和谷歌主导企业AI供应商市场

根据Gartner最新报告,微软凭借广泛的合作伙伴和平台生态系统在企业级AI领域占据主导地位,而谷歌凭借集成的AI代理技术栈和可扩展的企业采用支持在企业代理AI方面领先。报告涵盖近30个AI技术竞赛领域,包括数据基础设施、模型代理、行业解决方案和网络安全等类别。尽管科技巨头投入数十亿资金扩展AI基础设施,但企业仍在努力证明AI技术的商业价值,超过三分之二的企业困于生成式AI试点阶段。

微软亚洲研究院联手清华大学:让AI看图不再“雾里看花“的双向感知新技术

微软亚洲研究院与清华大学联合提出双向感知塑造技术,通过创新的两阶段训练方法解决AI视觉理解中的关键问题。该技术让AI学会正确聚焦重要视觉信息,避免被无关内容误导。仅用1.3万训练样本就在八个基准测试中平均提升8.2%性能,超越使用数十万样本的专门模型,为AI视觉推理能力提升开辟新路径。

美国NIST发布人工智能网络安全框架指南草案

美国国家标准与技术研究院发布人工智能网络安全框架配置文件草案,旨在帮助组织安全使用AI系统。该文件围绕"安全"、"防御"和"阻止"三个重点领域,详细说明如何管理不同AI系统的网络安全挑战、利用AI增强网络防御能力以及阻止AI驱动的网络攻击。文件将网络安全框架的各个组件映射到具体建议上,覆盖入侵检测到供应链安全等各个方面。

上海交大团队突破大语言模型实时推理难题:让AI在时间限制内既快又准

上海交通大学研究团队开发了TimeBill框架,解决大语言模型在实时应用中的时间不确定性问题。该系统通过精确预测回答长度和执行时间,动态调整AI记忆管理策略,确保在规定时间内完成任务的同时保持回答质量。实验显示TimeBill在各种时间预算下都能实现最佳的完成率与性能平衡,为AI在自动驾驶、工业控制等安全关键领域的应用提供了重要技术支撑。