GTC 2021:Nvidia发布Quantum-2网络平台加速高性能计算

Nvidia发布了下一代InfiniBand网络平台Nvidia Quantum-2,致力于推动高性能计算的发展。

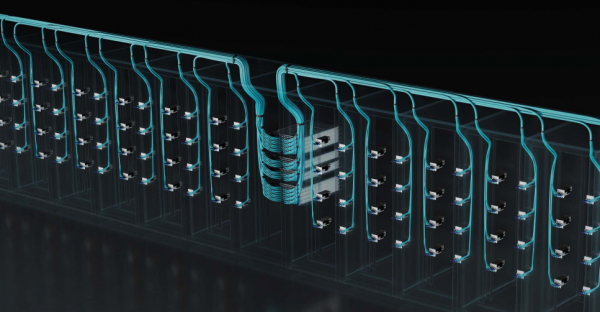

今天Nvidia在GTC 2021大会上宣布推出了Nvidia Quantum-2(如图),这是一个传输性能达到每秒400GB的InfiniBand网络平台,配置了全新的Nvidia Quantum-2交换机、ConnectX-7网络适配器,以及即将推出的BlueField-3数据处理单元。Nvidia表示,这一组合出色的网络吞吐性能和现金的多租户功能,可同时支持多个用户。

Nvidia的InfiniBand是一种计算机网络通信标准,用于对处理器和I/O设备之间的数据流进行高性能计算,以其高吞吐量和极低的延迟而闻名。

最新一代InfiniBand Quantum-2引入了新的功能,可进一步加速超算中心和提供了高性能计算服务的公有云平台中要求最为苛刻的工作负载。

Nvidia网络高级副总裁Gilad Shainer表示:“当今超级计算中心和公有云的需求正在走向融合,必须应对下一代高性能计算、人工智能和数据分析带来的挑战,提供尽可能高的性能,同时还必须安全地隔离工作负载,响应用户流量的各种需求。现在,Nvidia Quantum-2 InfiniBand实现了现代数据中心的这一愿景。”

Nvidia表示,为了提供所需的性能,Quantum-2 InfiniBand将网络速度提高了1倍,同时将上一代标准可用网络端口的数量增加了2倍,这意味着Quantum-2将性能提升高达3倍,同时将数据中心光纤交换机的需求减少6倍,此外还在大幅降低数据中心功耗的同时,将数据中心空间减少了7%。

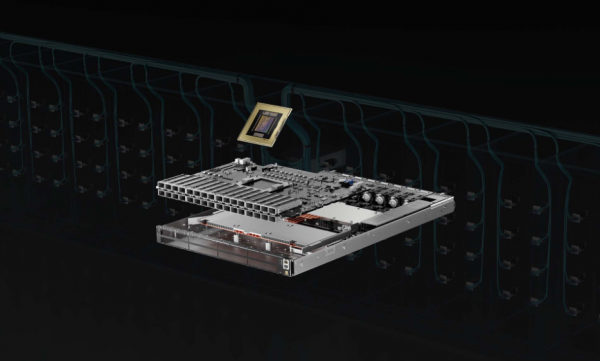

这一切都要归功于最新的Nvidia Quantum-2 InfiniBand交换机(如图),该设备的7纳米芯片上容纳了570亿个晶体管,提供多达64个400Gbps端口或128个200Gbps端口。Nvidia表示,将在各种交换机提醒中提供这款交换机,规模最大的配置中最多有2048个端口,是上一代Quantum-1系统的5倍多。

与此同时,Quantum-2还提供了多租户性能隔离方面的好处,可确保一个租户或者一个用户的活动不会受到其他租户在性能上的影响。Nvidia表示,这是通过先进的、基于遥测的拥塞控制系统实现的,可确保有足够的吞吐量可用,无论需求或用户数是否激增。

Quantum-2的另一个亮点是一种独有的SHARPv3网络计算计算,以上一代InfiniBand相比,该技术为AI应用程序提供了高达32倍的加速引擎,不仅如此,还有一个全新的纳秒级精确计时系统,可通过同步分布式应用(例如数据库处理)来减少等待和空闲时间带来的开销,从而提高性能水平。

Nvidia解释说,纳秒计时是一种新功能,可让云数据中心成为电信网络的一部分,并托管软件定义的5G无线电服务。

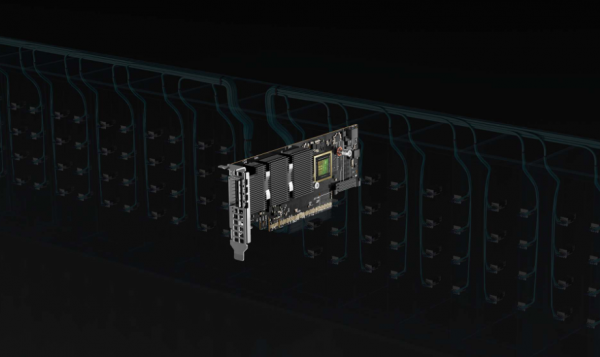

此次发布时,Quantum-2 InfiniBand设计支持2个网络端点、新的Nvidia ConnectX-7网络接口卡(下图)和即将推出的BlueField-3 DPU。ConnectX-7将于2022年1月打样,据说是由80亿个晶体管组成的,采用了7纳米设计,与上一代ConnectX-6相比,可处理的数据量增加了1倍。BlueField-3 DPU将于5月打样,采用7纳米设计,拥有220亿个晶体管,提供16个64位Arm CPU,用于卸载和隔离数据中心基础设施任务。

Nvidia表示,Quantum-2 InfiniBand交换机现在已经开始从基础设施和系统合作伙伴处供货,包括Atos Computing、DataDirect Networks、戴尔、Excelero、技嘉、HPE、IBM、浪潮、联想、Penguin Computing、超微、WekaIO和Vast Data。

来源:业界供稿

好文章,需要你的鼓励

UNIX V4磁带成功恢复:首个C语言编写的UNIX版本重新运行

计算机历史博物馆软件馆长Al Kossow成功恢复了上月在犹他大学发现的半世纪前磁带内容。UNIX V4是首个内核用C语言编写的UNIX操作系统版本,已从1970年代九轨磁带中成功恢复。现可从互联网档案馆下载并在SimH中运行。该版本包含约5.5万行代码,其中2.5万行为C语言,内核仅27KB大小。恢复过程使用了readtape程序采样原始磁通变化进行数据重建。

新加坡南洋理工大学提出“棱镜假设“:像光谱仪一样解读图像的神秘密码

新加坡南洋理工大学研究团队提出"棱镜假设",认为图像可像光谱一样分解为不同频率成分,低频承载语义信息,高频包含视觉细节。基于此开发的统一自编码系统UAE,通过频率域分解成功统一了图像理解和生成能力,在多项基准测试中超越现有方法,为构建真正统一的视觉AI系统提供了新思路,有望推动计算机视觉技术向更智能统一的方向发展。

AWS为Nutanix AHV虚拟化平台新增混合云存储支持

亚马逊云服务宣布其存储网关现已支持Nutanix的AHV虚拟化管理程序,进一步扩展混合云存储解决方案。此前AWS存储网关已支持VMware ESXi、微软Hyper-V和Linux KVM。由于AHV基于KVM架构,AWS表示添加支持相对容易。随着Broadcom收购VMware后策略调整,许多企业正寻求替代方案,Nutanix成为热门选择。分析师预测VMware可能在三年内失去35%的工作负载。

当AI遇到“健忘症“:芝加哥大学团队如何让智能助手不再胡编乱造

芝加哥伊利诺伊大学团队提出QuCo-RAG技术,通过检查AI训练数据统计信息而非内部信号来检测AI回答可靠性。该方法采用两阶段验证:预检查问题实体频率,运行时验证事实关联。实验显示准确率提升5-14个百分点,在多个模型上表现稳定,为AI可靠性检测提供了客观可验证的新方案。

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币