加速AI推理 NVIDIA发布TensorRT 8并获得ACM RecSys 2021挑战赛冠军 原创

训练对于深度学习来说是为了获得一个性能优异的模型,其主要的关注点在于模型的准确度等指标。推理则不一样,其没有了训练中的反向迭代过程,是针对新的数据进行预测,而我们日常生活中使用的AI服务都是推理服务。推理更关注的是高吞吐率、低响应时间、低资源消耗以及简便的部署流程,而TensorRT就是用来解决推理所带来的挑战以及影响的部署级的解决方案。

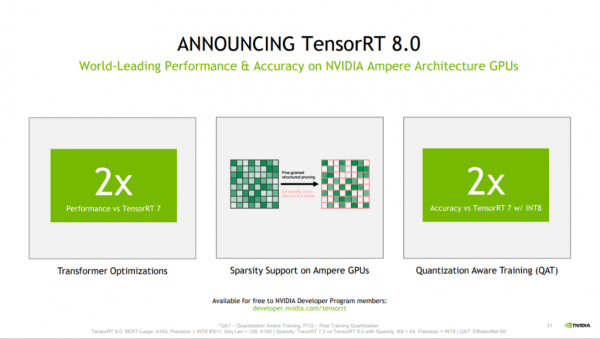

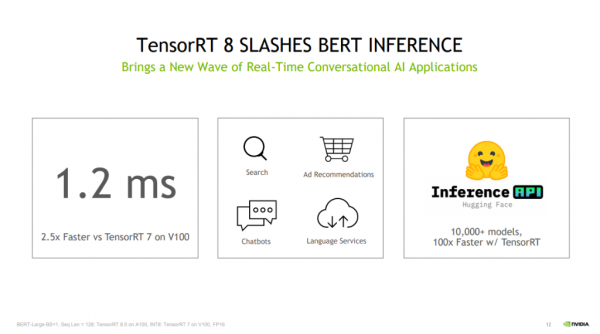

近日,NVIDIA于今日发布公司第八代AI软件TensorRT 8。该软件将语言查询推理时间缩短了一半,使开发者能够从云端到边缘构建全球最佳性能的搜索引擎、广告推荐和聊天机器人。TensorRT 8现已全面上市,并免费向NVIDIA开发者计划成员提供。用户还可从TensorRT GitHub库中获得最新版本插件、解析器和样本的开放源代码。

TensorRT 8的各项优化为语言应用带来了创纪录的速度,能够在1.2毫秒内运行BERT-Large——全球最广为采用的基于transformer的模型之一。过去,企业不得不缩减模型大小,而这会导致结果出现大幅偏差。现在有了TensorRT 8,企业可以将其模型扩大一倍或两倍,从而大幅提高精度。

TensorRT面对面

Tensor,深度学习中的张量。一个一维Tensor的叫Vector,二维的叫Matrix,三维四维的Tensor都有。 Tensor RT的Tensor指的就是这个概念,而整个TensorRT的工具是指一个GPU Inference Engine,也就是一个GPU推理引擎。

TensorRT基本上支持现在所有的主流框架训练出来的模型,把模型输入进来,然后TensorRT帮助做解析,实现网络层之间的优化。TensorRT可部署于超大规模数据中心、嵌入式或汽车产品平台。

除了针对transformer的优化之外,TensorRT 8还通过其他两项关键特性,实现了AI推理方面的突破。

其一是稀疏性,这是助力推动NVIDIA Ampere架构GPU性能提升的一项全新技术,它不但提高了效率,还使开发者能够通过减少计算操作来加速其神经网络。

其二是量化感知训练,开发者能够使用训练好的模型,以INT8精度运行推理,在这一过程中不会损失精度。这大大减少了计算和存储成本,从而在Tensor Core核心上实现高效推理。

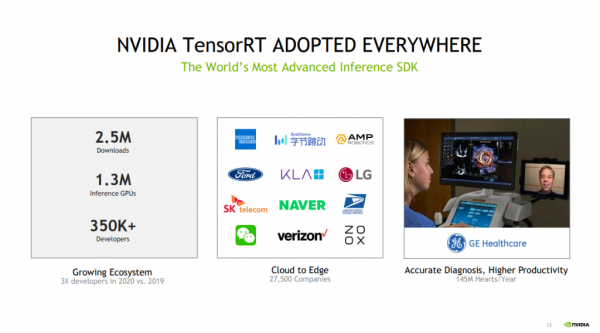

五年来,医疗、汽车、金融和零售等各个领域27500家企业的超35万名开发者下载TensorRT近250万次,众多行业客户已将TensorRT用于他们在对话式AI和其他各个领域的深度学习推理应用。例如Hugging Face与NVIDIA开展密切合作,推出能够助力实现大规模文本分析、神经搜索和对话式应用的开创性AI服务。Hugging Face加速推理API已经能够为基于NVIDIA GPU的transformer模型提供高达100倍的速度提升。通过TensorRT 8,Hugging Face在BERT上实现了1毫秒的推理延迟。

临床医生需要花费宝贵的时间来选择和评估超声图像。在Vivid Patient Care Elevated Release项目的研发过程中,GE医疗正在使用TensorRT,助力加速早期检测疾病的关键工具——超声波计算机视觉应用,使临床医生能够通过其智能医疗解决方案提供最高质量的护理。TensorRT凭借其实时推理能力,提高了视图检测算法的性能,同时缩短了研发项目的产品上市时间。

用实力说话

推荐系统是人工智能应用的重要方向,其通过比传统搜索更快、更智能的方式提供建议。

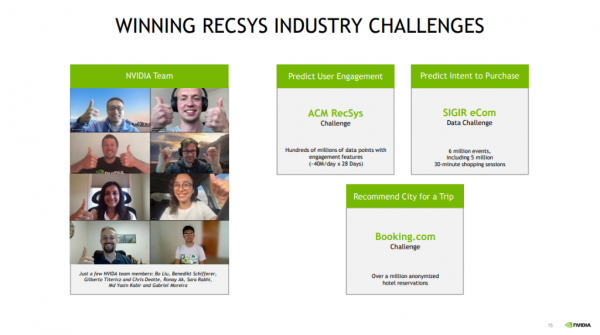

作为难度最高的一次推荐系统数据科学竞赛,ACM RecSys 2021挑战赛是计算机科学一个相对较新的分支,它催生了机器学习领域常用的应用程序之一,这一程序帮助数百万人找到他们想看、想买和想玩的内容。

而由七人组成的NVIDIA参赛团队第二次赢得冠军,该团队共使用了六个AI模型,达到了比赛规定的20千兆字节上限,所有这些模型都是根据他们研究7.5亿个数据点的经验精挑细选出来的。这次比赛有一项不同寻常的规则,要求模型必须基于一个云端CPU的单一内核运行,并且运行时间不能超过24小时。

众所周知,GPU本可以在很短的时间内完成推理工作,而且NVIDIA Merlin框架可以帮助用户快速建立自己的推荐系统。所以,让推理工作去适应CPU核心“就好像回到了远古时代”。事实上,比赛一结束,该团队就展示了在CPU核心上花费近24小时的推理工作,在单个NVIDIA A100 Tensor Core GPU上运行只需7分钟。

今年早些时候,NVIDIA团队在Booking.com挑战赛的40支参赛小组中拨得头筹。他们使用数百万个匿名数据点来准确的预测了欧洲度假者最终将选择前往的城市。

今年6月,另一项顶级RecSys大赛SIGIR电子商务数据挑战赛设置了更高的门槛。其2021年挑战赛提供了3700万个在线购物会话的数据点,并要求参赛者预测用户会购买哪些产品。

由于这场比赛与ACM RecSys挑战赛的时间重叠,NVIDIA团队不得不兵分两路,各有侧重地参与不同的比赛。

其中一只NVIDIA团队共包含五名成员,分别身处巴西、加拿大、法国和美国在每个排行榜中这只团队均排名第一或第二。能取得这样出色的整体表现,主要有两个因素。其一,他们在Transformer模型上下了很大功夫,这些模型是为自然语言处理开发的,并越来越多地被RecSys所采用。其二,他们深谙轮班工作的工作方法。

6月30日,NVIDIA在RecSys挑战赛取得四连胜。行业基准组织MLPerf宣布,NVIDIA及其合作伙伴在其所有最新训练基准测试中均创下新纪录,其中包括一个有关推荐系统的基准测试。

参赛团队描述了他们取得的成果——即在不到一分钟内训练基于14个NVIDIA DGX系统的推荐系统,与一年前提交的成果相比,速度加快了3.3倍。

NVIDIA的RecSys专家谈及他们的技术诀窍是一半是艺术,一半是科学。例如像Merlin这样的RecSys框架,以及NVIDIA深度学习学院所拥有的相关工具、论文和在线课程,还有使用多种模型,并使其协同工作。

结语

人工智能的运用分成两个阶段,一是学习训练阶段,二是推理阶段,此与应用程序相类似,程序开发阶段即为学习训练阶段,程序正式上线执行运作则为推理阶段。

不管是TensorRT 8还是RecSys挑战赛的佳绩,NVIDIA在推动AI推理方面的步伐一直没有止步,推动人工智能应用在行业中的落地。

来源:至顶网计算频道

好文章,需要你的鼓励

让自动驾驶AI学会“聚焦重点“,速度提升7倍却更加安全

来自北京大学多媒体信息处理国家重点实验室和小鹏汽车的研究团队发布了一项重要研究成果,提出了一种名为FastDriveVLA的创新框架,让自动驾驶AI能够像人类司机一样,学会在纷繁复杂的道路场景中快速识别并聚焦于真正重要的视觉信息。

清华团队让机器学会“透视眼“:用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

TechCrunch创业战场大赛消费和教育科技领域26强公司榜单

TechCrunch年度创业战场大赛从数千份申请中筛选出200强,其中20强进入决赛角逐10万美元大奖。本次消费科技和教育科技领域共有26家公司入选,涵盖无障碍出行、AI视频制作、服装租赁、护肤推荐、纹身预约等创新应用,以及AI语言学习、个性化数学教育、职场沟通培训等教育科技解决方案,展现了科技创新在日常生活和教育领域的广泛应用前景。

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。

TechCrunch创业战场大赛消费和教育科技领域26强公司榜单

新Mac开箱必备:完美工作桌面升级指南

如何使用ChatGPT新增应用集成功能

谷歌地图AI工具让节日和新年出行规划变得轻松便捷

2025年七大IT灾难回顾

openGauss熊伟:oGRAC+超节点,AI数据库的下一个五年

R语言重获关注 Tiobe编程语言排行榜重返前十

JDK 26:Java 26的新特性详解

AWS在re:Invent 2025后仍难构建企业AI完整解决方案

Linux基金会推出自主式AI基金会

GitHub个人访问Token被曝光后威胁激增,攻击者可直达云环境

Manus被收购,枫清科技将获过亿元投资:资本市场重估中国AI智能体

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币