MLPerf训练最新发榜:谷歌英伟达平分集群最佳,浪潮斩获半数单机冠军

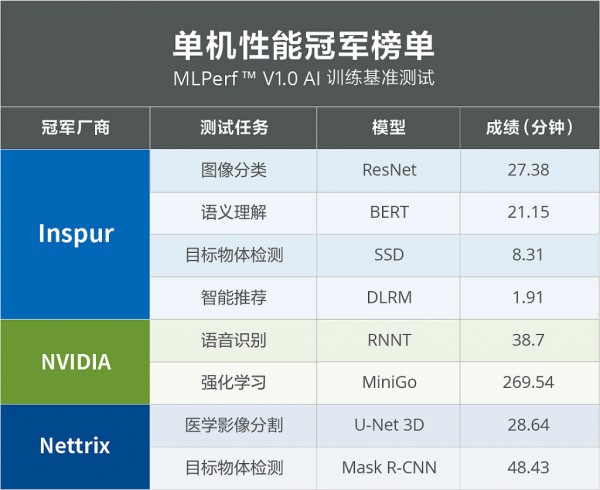

美国东部时间6月30日,国际权威AI基准测试MLPerf™公布最新一期榜单。在集群封闭任务赛道中,谷歌与NVIDIA各自获得4项第一;在单机封闭任务赛道中,浪潮获全部8项训练任务的4项冠军,NVIDIA、Nettrix各获得2项任务冠军。

MLPerf™由图灵奖得主大卫•帕特森(David Patterson)联合谷歌、斯坦福、哈佛大学等顶尖学术机构发起成立,是影响力最广的国际AI性能基准评测。此次性能评测基于最新MLPerf™ Training V1.0基准,分为固定任务(Closed)和开放任务(Open)。其中,固定任务要求使用相同模型和优化器,衡量同一深度学习模型在不同软硬件上的性能,广受厂商和客户看重;开放任务则放开对深度学习模型及精度的约束,侧重深度学习模型及算法优化的能力,旨在推进ML模型和优化的创新。

MLPerf™V1.0基准测试涵盖了8类极具代表性的机器学习任务,分别为图像识别(ResNet)、医学影像分割(U-Net3D)、目标物体检测(SSD)、目标物体检测(Mask R-CNN)、语音识别(RNN-T)、自然语言理解(BERT)、智能推荐(DLRM)以及强化机器学习(MiniGo)。其中,ResNet50和BERT作为计算机视觉和自然语言理解中最具代表性的AI模型,竞争最为激烈。

包括谷歌、NVIDIA、Intel、浪潮、戴尔、联想等在内的13家公司及科研机构,参与了此次MLPerf™封闭任务赛道测试。

谷歌与NVIDIA在集群系统测试中展开激烈冠亚军争夺,最终谷歌获得了ResNet、SSD、BERT和DLRM四项任务的第一,NVIDIA则夺得U-Net3D、Mask R-CNN、RNN-T和MiniGo四项任务冠军,双方平分秋色。在单机系统测试中浪潮获得ResNet、SSD、BERT和DLRM四项任务的冠军,NVIDIA获得RNN-T和MiniGo两项第一,Nettrix获得U-Net3D、Mask R-CNN两项第一。

作为业内最权威的AI基准测试,每一次MLPerfTM评测结果都在刷新业内纪录,不断突破AI系统性能。和2020年榜单相比,今年榜单的各项任务测试成绩均有明显提升。在集群训练上,Google在ResNet模型训练任务中以0.23分钟打破2020年创下的0.47分钟纪录,耗时缩短51%;在Bert模型任务中Google以0.29分钟完成训练,相比2020年0.39分钟的最佳纪录,用时缩短26%。

在单机性能上,浪潮同样在备受关注的ResNet和BERT上取得了新突破,创下单机27.38分钟完成128万张图片训练BERT模型的新纪录,比2020年最佳纪录耗时缩短18%;在BERT模型训练中,浪潮以21.15分钟打破2020年最佳成绩49.01分钟,用时缩短57%。

来源:业界供稿

好文章,需要你的鼓励

2025年金融服务业十大热点事件回顾

大型金融服务企业凭借雄厚投资能力推动企业IT发展,AI特别是生成式AI正成为焦点。金融业面临技术革命,AI将大幅降低IT复杂度和成本,但也带来就业挑战。本文回顾银行AI应用、IT系统故障、行业领袖访谈等十大关键事件,包括AI成为银行业唯一安全职业、劳埃德银行高管AI培训、英格兰银行核心系统升级等重要发展。

斯坦福大学团队突破性发现:AI智能体终于学会了如何聪明探索!

斯坦福大学、苏黎世联邦理工学院和Idiap研究所的研究团队开发出LAMER框架,首次让AI智能体学会了在陌生环境中巧妙平衡探索与利用。该框架通过跨回合训练和自我反思机制,让智能体能从失败中学习并改进策略。在四个测试环境中,LAMER分别取得了11%、14%和19%的性能提升,并在面对更困难或全新任务时展现出卓越的适应能力,为开发能自主学习的通用AI智能体奠定了重要基础。

2025年全球电信行业十大热点事件

2025年电信行业的一个显著趋势是非地面网络(NTN)和卫星通信从小众走向主流。Starlink凭借44个合作伙伴关系领跑卫星通信市场,航空公司纷纷部署机载连接服务。5G独立组网加速部署,推动移动数据消费创纪录增长。英国全光纤覆盖率达到78%,首次超越光纤到路边技术。Nokia在芬兰设立AI网络研发中心,为6G做准备。

特斯拉和苹果,谁也没想到最后是这群学者率先攻克了用摄像头“看见“雷达的难题

以色列理工学院联合MIT、英伟达等机构研究团队开发出RadarGen技术,能够仅通过摄像头画面生成逼真的汽车雷达数据。该技术采用扩散模型架构,将稀疏雷达点云转换为鸟瞰视图表示,结合深度估计、语义分割和光流信息指导生成过程,还支持场景编辑功能。实验表明生成数据可被现有检测器有效使用,为自动驾驶训练数据获取提供了新方案。

2025年全球电信行业十大热点事件

ChatGPT全指南:关于这款AI驱动聊天机器人的一切

全球最大影子图书馆备份Spotify热门歌曲,涉及300TB数据

Splat应用利用AI将照片转换为儿童涂色页面

至顶AI实验室硬核评测:在戴尔 Precision Max Slim上本地部署KAG,把 AI 问答系统卷出天际

联想ThinkPad

戴尔Precision

揭秘好莱坞顶级大片背后的基础架构力量

至顶AI实验室硬核评测:本地部署Step-Audio 2 mini

至顶AI实验室硬核评测:智谱AI Open-AutoGLM开源了,系统级AI Agent免费玩

高性能 AI 边缘推理服务器MIC-743-AT

Instagram长视频内容和个性化订阅可能即将到来