MWC 2021:Nvidia宣布5G边缘基础设施平台将支持Arm CPU

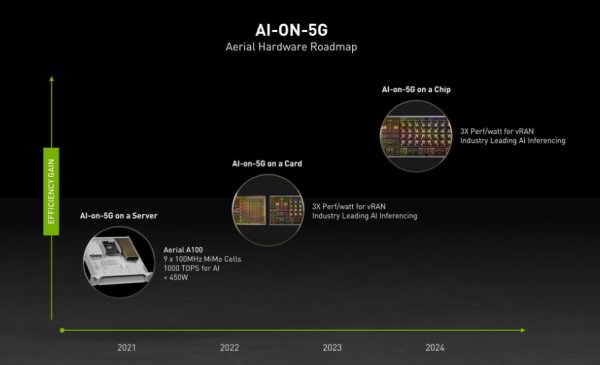

Nvidia正在加紧为网络边缘的5G应用提供动力,在Nvidia Aerial A100 AI-on-5G平台上增加对Arm CPU的支持。

Aerial A100 AI-on-5G是一个统一的融合平台,旨在提供边缘人工智能计算和5G连接。该平台将于4月推出,它把Nvidia Aerial软件开发套件与Nvidia BlueField-2 A100融合卡相结合,后者可以将多个CPU与Nvidia的数据中心处理单元进行配对。

该平台可以为高性能、软件定义的5G基站和人工智能应用提供支持,例如精密制造的机器人、自动导引车、无人机、无线摄像头、自助结账等。换句话说,它为企业提供了在边缘部署智能服务的一个选择。

因为Aerial A100 AI-on-5G平台已经支持英特尔的x86 CPU,所以今天Nvidia在巴塞罗那MWC世界移动通信展上发布的这项公告,有望为用户带来更多选择。Nvidia称,经过Nvidia认证的系统将创造一个“简化的路径,可构建和部署自托管的vRAN,把AI和5G带给私营企业、网络设备公司、软件制造商和电信服务提供商。”

Nvidia表示,Aerial A100 AI-on-5G平台的Arm版本将配置16个Arm Cortex A78处理器,以及即将推出的Nvidia BlueField-3 DPU,从而形成一个独立的融合卡,用于在云原生5G上运行边缘AI应用虚拟无线电区域网络。

Nvidia宣布支持Arm CPU并不令人意外,因为Nvidia正在以400亿美元收购Arm的过程中,这项交易正在接受监管机构的审查,预计要到明年才能完成。

Nvidia电信行业高级副总裁Ronnie Vasishta表示:“我们正在将计算人工智能和电信5G相结合,为5G上的人工智能创建一个软件定义的平台。通过支持Arm,我们不断成长的Aerial平台将加速推进无处不在的‘AI-on-5G’。”

据称,Nvidia的BlueField-3 A100 DPU是专为人工智能和加速计算工作负载设计开发的。它针对5G连接进行了优化,旨在与CPU协同工作。该DPU负责基础设施管理任务,例如扫描网络流量中的恶意软件和调度存储容量,通常这些任务是由CPU处理的,因此把这些任务卸载到DPU,可以让CPU资源释放出来专注用于运行计算任务。”

BlueField-3 DPU将于2022年上半年上市,届时还将搭载Nvidia的AI软件库,包括预训练的模型和Aerial 5G SDK,帮助开发人员缩短部署时间,向他们的应用中添加各种AI功能。

“Bluefield-3结合了Nvidia加速计算和Arm的性能水平,这一组合有助于扩大Arm的生态系统,让网络供应商在创建和部署5G系统方面有更多的选择,”Arm公司高级副总裁、基础设施业务线总经理Chris Bergey这样表示。

首个AI-on-5G创新实验室

打造平台是一回事,但让客户采用这个平台就是另一回事了。因此,Nvidia宣布与谷歌展开合作,创建了首个AI-on-5G创新实验室。

该实验室主要面向那些希望在Nvidia这个新平台上开发和测试解决方案的网络基础设施提供商和AI软件开发者。谷歌将主要贡献他们的Google Anthos平台,用于开发多云和边缘应用。

这对开发者来说是有一定吸引力的,因为Anthos本身就是一个受欢迎的产品,让开发者可以创建由Kubernetes管理的云原生容器化应用,运行在任何类型的云或边缘基础设施上。

谷歌云网络副总裁兼总经理Shailesh Shukla表示:“通过Anthos应用平台,谷歌云将让很多垂直市场的服务提供商和企业能够在网络边缘通过5G进行无缝连接。我们很高兴能够扩大与Nvidia的合作。”

两家公司表示,希望在今年年底之前启动并运行该实验室。

Constellation Research分析师Holger Mueller认为,5G和边缘的争夺战主要是集中在是在平台方面的,谁能够开发出最吸引人的产品并且得到最多企业的采用,谁就将赢得这场竞赛。

“Nvidia在这两方面都取得了进展,一方面Nvidia在5G人工智能软件平台上增加了对Arm芯片的支持,另一方面在企业采用方面,Nvidia与谷歌展开合作,使企业能够熟悉他们的5G AI平台并使用谷歌Anthos为其构建应用。”

来源:siliconANGLE

好文章,需要你的鼓励

埃森哲投资Profitmind,押注AI智能体变革零售业

埃森哲投资AI零售平台Profitmind,该平台通过智能代理自动化定价决策、库存管理和规划。研究显示AI驱动了2025年假日购物季20%的消费,约2620亿美元。部署AI代理的企业假日销售同比增长6.2%,而未部署的仅增长3.9%。Profitmind实时监控竞争对手价格和营销策略,并可创建生成式引擎优化产品文案。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币