重塑视频会议 NVIDIA Vid2Vid Cameo打造逼真的AI人脸说话动态 原创

疫情期间,线上视频会议成为人们生活与工作沟通的重要方式。但是你是不是会遇到如下尴尬:刚起床,头发凌乱、穿着睡衣,但是却被老板拉上开会。

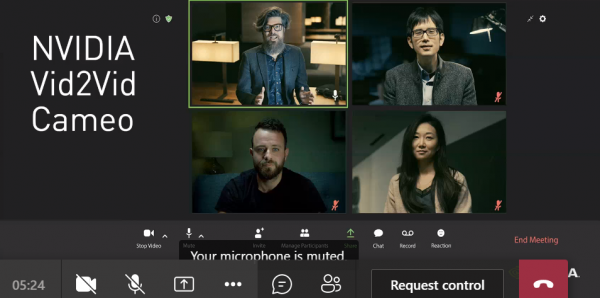

为了让你在每次视频通话中都能完美展现自己,在本周举行的CVPR(国际计算机视觉与模式识别会议)上,由NVIDIA研究人员Ting-Chun Wang、Arun Mallya和Ming-Yu Liu共同撰写发表的Vid2Vid Cameo论文提供了一个全新的解决方案。

逼真的AI人脸说话动态

Vid2Vid Cameo是用于视频会议的NVIDIA Maxine SDK背后的深度学习模型之一,它借助生成式对抗网络(GAN),仅用一张人物2D图像即可合成逼真的人脸说话视频。

Vid2Vid Cameo只需两个元素,即可为视频会议打造逼真的AI人脸说话动态,这两个元素分别是一张人物外貌照片和一段视频流,它们决定了如何对图像进行动画处理。

要使用该模型,参与者需要在加入视频通话之前提交一张参照图像(真实照片或卡通头像)。在会议期间,AI 模型将捕捉每个人的实时动作,并将其应用于之前上传的静态图像。

也就是说,上传一张穿着正装的照片之后,与会人员即使头发凌乱、穿着睡衣,也能在通话中以穿着得体工作服装的形象出现,因为AI可以将用户的面部动作映射到参照照片上。如果主体向左转,则技术可以调整视角,以便参与者看上去是直接面对摄像头。

除了可以帮助与会者展现出色状态外,这项AI技术还可将视频会议所需的带宽降低10倍,从而避免抖动和延迟。它很快将在NVIDIA Video Codec SDK中作为AI Face Codec推出,为开发者提供经过优化的预训练模型,以便在视频会议和直播中实现视频、音频和增强现实效果。

更广的应用空间

其实应用于视频通话只是Vid2Vid Cameo的一个重要应用场景,其还可用于协助动画师、照片编辑师和游戏开发者的工作。开发者已经能采用Maxine AI效果,包括智能除噪、视频升采样和人体姿态估计。SDK支持免费下载,还可与NVIDIA Jarvis平台搭配用于对话式AI应用,包括转录和翻译。

模型基于NVIDIA DGX系统开发,使用包含18万个高质量人脸说话视频的数据集进行训练。相应网络学会了识别20个关键点,这些关键点可用于在没有人工标注的情况下对面部动作进行建模。这些点对特征(包括眼睛、嘴和鼻子)的位置进行编码。

然后,它会从通话主导者的参照图像中提取这些关键点,这些关键点可以提前发送给其他的视频会议参与者,也可以重新用于之前的会议。这样一来,视频会议平台只需发送演讲者面部关键点的移动情况数据,无需将某参与者的大量直播视频流推送给其他人。

对于接收者一端,GAN模型会使用此信息,模拟参照图像的外观以合成一个视频。

通过仅来回压缩及发送头部位置和关键点,而不是完整的视频流,此技术将视频会议所需的带宽降低10倍,从而提供更流畅的用户体验。该模型可以进行调整,传输不同数量的关键点,以实现在不影响视觉质量的条件下,适应不同的带宽环境。

此外,还可以自由调整所生成的人脸说话视频的视角,可以从侧边轮廓或笔直角度,也可以从较低或较高的摄像头角度来显示用户。处理静态图像的照片编辑者也可以使用此功能。

NVIDIA研究人员发现,无论是参照图像和视频来自同一个人,还是AI负责将某个人的动作转移到另一个人的参照图像,Vid2Vid Cameo均能生成更逼真、更清晰的结果,优于先进的模型。

后一项功能可将演讲者的面部动作,应用于视频会议中的数字头像动画,甚至可以应用于制作视频游戏或卡通角色的逼真形象和动作。

结语

人工智能技术在便利人们生活和工作方面正在发挥越来越重要的作用,而Vid2Vid Cameo借助NVIDI强大的AI能力,让视频会议的体验更棒,乃至在专业的图形和视频制造中有着巨大的想象空间。

来源:至顶网计算频道

好文章,需要你的鼓励

埃森哲投资Profitmind,押注AI智能体变革零售业

埃森哲投资AI零售平台Profitmind,该平台通过智能代理自动化定价决策、库存管理和规划。研究显示AI驱动了2025年假日购物季20%的消费,约2620亿美元。部署AI代理的企业假日销售同比增长6.2%,而未部署的仅增长3.9%。Profitmind实时监控竞争对手价格和营销策略,并可创建生成式引擎优化产品文案。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币