赋能3D设计 GANverse3D另辟蹊径实现2D到3D的图像转换 原创

因为从不同角度捕捉同一物体的真实数据集很少,所以大多数将图像从2D转换为3D的AI工具都是使用像ShapeNet这样的合成3D数据集进行训练的,而这样的逆图形模型依赖于3D图形作为训练数据。

NVIDIA研究院正在研发一种全新深度学习引擎,其把GAN模型变成了一个非常高效的数据生成器,这样就可以基于网络上的任何2D图像创建出3D对象。而且由于是根据真实图像而不是合成数据进行训练的,所以AI模型能更好地推广到现实世界的应用中。

据悉,由多伦多的NVIDIA AI研究实验室开发的GANverse3D应用将平面图像放大成逼真的3D模型,可以在虚拟环境中可视化和控制。这种性能可以帮助建筑师、创作者、游戏开发人员和设计师轻松地将新对象添加到他们的实体模型中,而不需要3D建模方面的专业知识,也不需要在渲染上花费大量预算。

从2D到3D GANverse3D独辟蹊径

为了从现实世界的数据中获得多视图图像,例如网上公开的汽车图像,NVIDIA研究人员转而使用GAN模型,修改其神经网络层,将其转化为数据生成器。

为了生成训练数据集,研究人员利用生成性对抗网络——GAN合成图像,从多个角度描绘同一物体——就像摄影师绕着一辆停着的汽车走动,从不同的角度拍摄。这些多视图图像被插入到逆图形的渲染框架中,逆图形是从2D图像推断3D网格模型的过程。

该团队发现,仅训练神经网络的前4层,冻结剩余的12层参数,可以让GAN从不同的角度渲染同一对象的图像;保持前4层参数冻结,其他12层可变,可以让神经网络基于同一角度生成不同的图像。

通过手动分配标准角度,在特定高度和距离拍摄车辆照片,研究人员可以从单个2D图像快速生成多视图数据集。

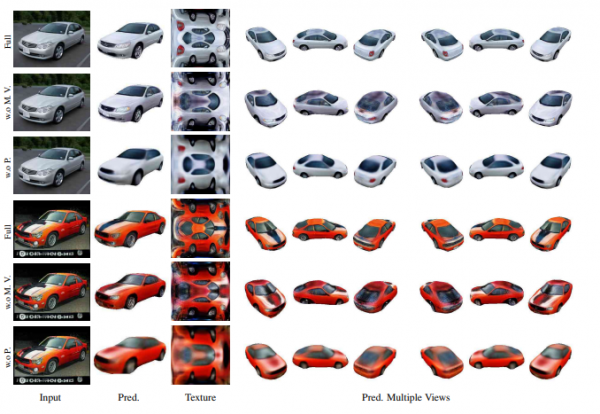

一旦完成了多视图图像训练,GANverse3D只需要一个2D图像即可预测3D网格模型。该模型可以与3D神经渲染器一起使用,使开发人员能够自定义对象和交换背景。

例如,单张汽车照片可以转换为3D模型,该模型可以在虚拟场景中行驶,并配有逼真的前灯、尾灯和转向灯。

最终的模型,在55000由GAN生成的汽车图像上训练而得,优于在流行的Pascal3D数据集上训练的逆图形网络。

从研究到生产 GANverse3D赋能3D设计

3D制作团队通常规模庞大、应用技术繁多且所在地点分散,NVIDIA Omniverse Enterprise可以让处于世界各地的3D设计团队跨多个软件套件工作,并在同一共享虚拟空间中进行实时协作的技术平台。目前,诸如宝马集团、Foster建筑事务所和WPP传播集团等公司已经在使用NVIDIA Omniverse Enterprise。

当作为NVIDIA Omniverse平台的扩展导入并在NVIDIA RTX GPU上运行时,GANverse3D可将任何2D图像重建为3D,将帮助游戏、架构和设计领域的创作者为游戏开发、城市规划甚至训练新的机器学习模型创建更丰富的虚拟世界。

并不是每个创作者都有时间和资源为他们所绘制的每一个对象创建3D模型。若要渲染展厅的汽车,或一条街的建筑,需捕获所需数量的多视图图像,成本可能高得令人望而却步。

而训练好的GANverse3D应用可以用来将汽车、建筑甚至一匹马的标准图像转换成可以在 Omniverse中自定义和制作动画的3D图形。借助Omniverse Connectors,开发人员可以在Omniverse中使用他们首选的3D应用程序,通过实时光线跟踪来模拟复杂的虚拟世界。

GANverse3D已经为诸如由Knight Rider的AI驱动的KITT等标志性汽车带来创新活力。为了重建 KITT,研究人员只需给训练好的模型输入汽车的图像,让GANverse3D预测相应的3D纹理网格,以及车辆的不同部分,例如车轮和前照灯。

然后,他们使用NVIDIA Omniverse套件和NVIDIA PhysX工具将预测的纹理转换成高质量的材料,使KITT具有更真实的外观和感觉,并将其与其他汽车一起放置在动态驾驶序列中。

总结

GANverse3D应用为2D到3D的图像转换提供了全新的思路,而目前3D图像设计在建筑师、创作者、游戏开发人员与设计师等领域有着广泛的应用,这样GANverse3D具有广阔的应用空间,特别是通过NVIDIA Omniverse触达用户,为用户业务创新提供更有力的支撑。

好文章,需要你的鼓励

Instagram长视频内容和个性化订阅可能即将到来

Instagram负责人莫塞里在接受采访时透露,平台正考虑引入长视频内容功能,尽管此前一直专注于短视频。他承认为了吸引优质内容,Instagram可能需要支持长视频格式。此外,Meta最近推出了"您的算法"功能,旨在让用户更好地控制信息流内容。莫塞里承诺未来将提供更多工具,让用户主动塑造个性化内容,但完整实现可能需要2-4年时间。

香港大学联合Adobe研究突破:让AI既能看懂图片又能生成美图的“万能大脑“

香港大学联合Adobe研究院提出PS-VAE技术,成功解决了AI无法同时具备图像理解和生成能力的难题。通过创新的两阶段训练策略,让AI既能准确理解图片语义,又能生成高质量图像,在图像编辑任务上性能提升近4倍,为统一视觉AI系统开辟新路径,在数字创作、教育、电商等领域具有广阔应用前景。

至顶AI实验室硬核评测:戴尔 Precision 5490移动工作站搭建Open Deep Research,打造专属于你的全流程AI研究助手

在信息爆炸的时代,AI实验室的研究员们常常需要面对海量的论文、专利文件、论坛发言等各种渠道的信息。传统的查找方式不仅费时费力,还容易遗漏关键内容。那么,有没有一种方式能让AI真正代替人工,完成从找资料到写出稿的全流程工作?

华中科技大学与马里兰大学联合发现:AI评判员可能比想象中更不靠谱

华中科技大学与马里兰大学研究团队开发出Sage评估框架,首次无需人工标注即可评估AI评判员可靠性。研究发现即使最先进的AI模型在评判任务中也存在严重不一致问题,近四分之一困难情况下无法保持稳定偏好。团队提出明确评判标准和专门微调等改进方法,为构建更可靠AI评估体系提供重要工具。

高性能 AI 边缘推理服务器MIC-743-AT

Instagram长视频内容和个性化订阅可能即将到来

NVIDIA DGX Spark

Dell Pro Max with GB10

至顶AI实验室硬核评测:戴尔 Precision 5490移动工作站搭建Open Deep Research,打造专属于你的全流程AI研究助手

惠普ZBook Fury G1i高性能移动工作站

至顶AI实验室硬核评测:夸克 AI 眼镜全链路"无切换体验",当AI助手真正走进日常

夸克AI眼镜

至顶AI实验室硬核评测:据说这就是AI手机的形态,贴脸开大,豆包手机上手评测

OpenFlex(TM) Data24 NVMe-oF(TM) 存储平台

英特尔(R) 至强(R) 6776P处理器

Solidigm D7-PS1010 E1.S 液冷固态硬盘

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币