NVIDIA赋能的系统迎来新搭档Ice Lake

机器学习和数据分析等数据密集型工作负载已变得司空见惯。为处理这些计算密集型任务,企业需要为实现高性能进行优化的加速服务器。

英特尔于昨日发布第3代英特尔至强可扩展处理器(代号“Ice Lake”)。该处理器基于全新的架构,可大幅提升其性能和可扩展性。在NVIDIA GPU和网络功能的帮助下,新系统成为理想的企业加速计算平台。此外,新系统还具备可实现GPU加速应用的功能。

Ice Lake平台加速计算的优势

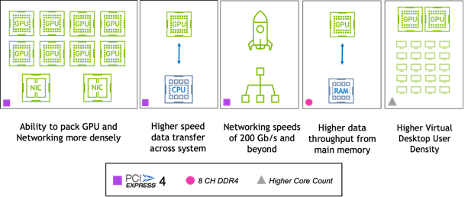

Ice Lake采用了PCIe Gen 4,其数据传输速率比前代产品增加了一倍,现在已经可以与基于NVIDIA Ampere架构的GPU(如NVIDIA A100 Tensor Core GPU)的原生速度相匹配。PCIe Gen 4的采用提高了与GPU间的吞吐量,这对于涉及大量训练数据的机器学习工作负载来说尤为重要。同时,PCIe Gen 4的采用也提高了数据密集型任务的传输速度,比如通过高性能NVIDIA A40数据中心GPU等加速的NVIDIA RTX虚拟工作站3D设计任务。

PCIe性能的提高加快了GPU直接内存访问的传输速度。GPU和采用GPUDirect视频技术的设备之间视频数据I/O通信速度的加快,可助力实现更强大的直播解决方案。

数据速率的提高还实现了200Gb/s的网络速度,例如NVIDIA ConnectX家族的HDR 200Gb/s InfiniBand网卡、200Gb/s以太网网卡,以及即将推出的NDR 400Gb/s InfiniBand网卡技术。

Ice Lake平台支持64条PCIe通道,因此可以在同一台服务器中安装更多的硬件加速器,包括GPU和网卡等,从而提高每台主机的加速密度。这也意味着由最新NVIDIA GPU和NVIDIA 虚拟PC软件加速的多媒体VDI环境可以实现更高的用户密度。

这些增强功能实现了前所未有的GPU加速扩展。企业可以通过在一台主机内使用更多的GPU并更加有效地连接多台主机的GPU,处理最大规模的工作。

英特尔还提高了Ice Lake内存子系统的性能,将DDR4内存通道数从6条增加到8条,使内存的最高数据传输速率达到3200MHz。这使得从主内存到GPU和网络的数据传输带宽变得更大,进而可提高数据密集型工作负载的吞吐量。

最后,处理器本身的改进也进一步加快了计算工作负载的速度。每个时钟周期的指令数增加10-15%,可使加速工作负载所对应的CPU部分整体性能提升多达40%。此外,核的数量也有所增加,比如8xxx系列中的核心多达40个。这将提高每台主机的虚拟桌面会话密度,进一步增加服务器GPU投资的回报。

NVIDIA十分高兴地看到合作伙伴发布由NVIDIA GPU加速的全新Ice Lake系统,用于包括戴尔科技专为GPU加速而打造的Dell EMC PowerEdge R750xa,以及基于第3代英特尔至强可扩展处理器和PCIe Gen4打造的全新联想ThinkSystem服务器(其中有多个型号搭载NVIDIA GPU)。

英特尔的全新Ice Lake平台及随附的加速器硬件非常适合准备更新数据中心的企业客户。全新架构的增强功能使企业能够运行性能更加出色的数据中心级加速应用。NVIDIA与英特尔的共同客户将能够迅速从中获益。

敬请访问NVIDIA认证服务器目录,查看采用Ice Lake CPU的GPU加速服务器型号列表。后续将会有更多系统加入,欢迎定期访问该目录。

来源:业界供稿

好文章,需要你的鼓励

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

2026年科技行业多元化发展前景与挑战预测

科技行业女性从业者比例从2015年的16%增至2025年的22%,进步缓慢。尽管各种倡议不断推进,但多元化员工仍面临离职率高、薪酬差距和发展机会不足等问题。2025年经济不确定性导致企业削减多元化项目,美国政策变化也产生连锁反应。随着AI技术快速发展,缺乏多元化团队将导致技术偏见,影响产品质量和市场表现。2026年将成为科技行业多元化发展的关键节点。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

2026年科技行业多元化发展前景与挑战预测

智能体AI推动云安全策略根本性变革

Salesforce推出AI能力框架助力企业数字化转型

大众汽车牵手高通打造智能网联座舱体验

Ruby 4.0.0发布:引入ZJIT编译器和Ruby Box隔离技术

Meta签约三家核能公司为AI数据中心提供6.6吉瓦电力

大多数开发者不信任AI生成代码却不检查

大规模数据中心安全防护中人员因素的关键作用

HPE OneView严重漏洞遭野外攻击利用

安联保险与Anthropic达成全球合作加速负责任AI应用

智能硬件助力Apple Home:Flic物理按钮控制解决方案

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币