NVIDIA Jetson Nano 2GB 系列文章(9):调节 CSI 图像质量

在本系列上一篇文章中,我们为大家展示了如何执行常见机器视觉应用。在本篇文章中,我们将带领大家调节 CSI 图像质量。

前面两篇文章在 Jetson Nano 2GB 上使用 CSI 摄像头做了几个实验,效果很不错,并且很容易上手。很快有用户反映,觉得摄像头拍到的图像质量似乎有点问题,包括可能有些噪点、色偏之类的问题,或者想处理白平衡、调整亮度/对比度/饱和度之类的问题,该如何解决?

本期重点就带着大家利用强大的 GStreamer 框架,调整一些设定值,来改变 CSI 摄像头截取图像的质量,主要包括 nvarguscamerasrc 与 videobalance 这两个元素,都提供可调整的参数,以下简单说明。

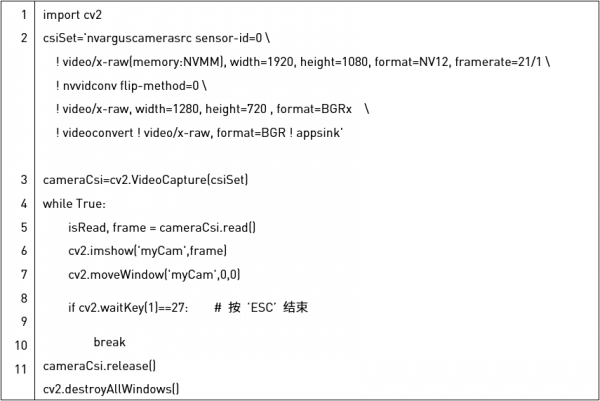

首先启动一个最基础的 CSI 摄像头调用代码,如下:

执行结果如下图:

nvarguscamerasrc 元素

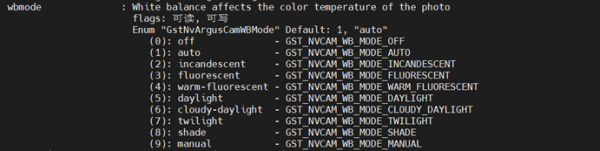

接着在 Jetson Nano 2GB 上打开一个终端,利用 GStreamer 提供的 gst-inspect-1.0 指令去查询 CSI 摄像头可设定的参数有哪些。

指令后面的“nvarguscamerasrc”元素对应 CSI 设备,是 NVIDIA 提供 Argus 库的对应关键字。执行上述指令后会出现长达 146 行的列表,内容太多不一一说明,仅就以下部分进行测试:

wbmode : 白平衡影响照片的色温,可设定[0:9]的整数

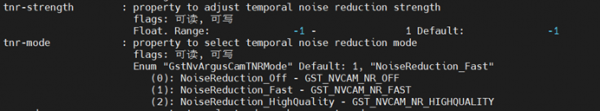

tnr-mode 与 tnr-strength :调整时间降噪强度

首先选择 tnr-mode 选项:设值为[0:2]的整数

然后再选择 trn-strength 强调,从[-1:+1]之间的浮点数

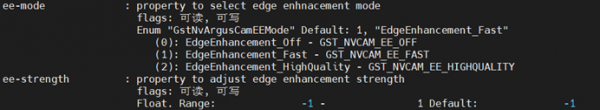

ee-mode 与 ee-strength:调整边缘增强强度

首先选择 tnr-mode 选项:设值为[0:2]的整数

然后再选择 trn-strength 强调,从[-1:+1]之间的浮点数

saturation:饱和度,设值[0:2]之间的浮点数

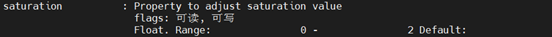

以上是 nvarguscamerasrc 设定值的一部分,因此在 GStreamer 工作流里面,需要放在 nvarguscamerasrc 元素里。下面代码做以下的测试设定:

-

白平衡:wbmode=3(白炽灯)

-

时间降噪强度:tnr-mode=2(NoiseReduction_HighQuality),tnr-strength=1

-

边缘强化强度:ee-mode=2(EdgeEnhancement_HighQuality),ee-strength=1

-

饱和度:saturation=0.5

添加的代码在下方代码“粗体底线”的部分:

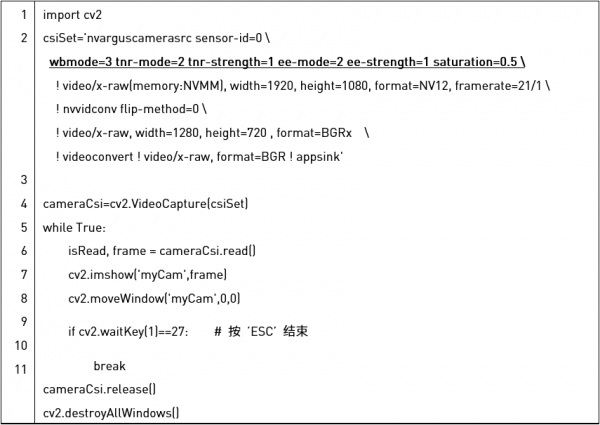

执行结果如下图:

这个输出结果与原图相比较,可以明显看到因为饱和度只取“0.5”,导致颜色明显变淡,边缘的部分则明显增强,至于噪点部分没有明显变化。

videobalance 元素

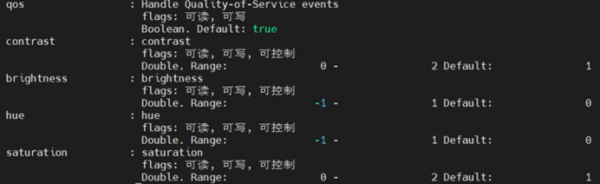

另外还有一个 videobalance 元素可以对图像质量进行调整,同样使用 gst-inspact-1.0 来检查 videobalance 里的参数,执行以下质量:

这部分设定值比较单纯,主要由 7 个设定值,其中与图像有关的以下部分:

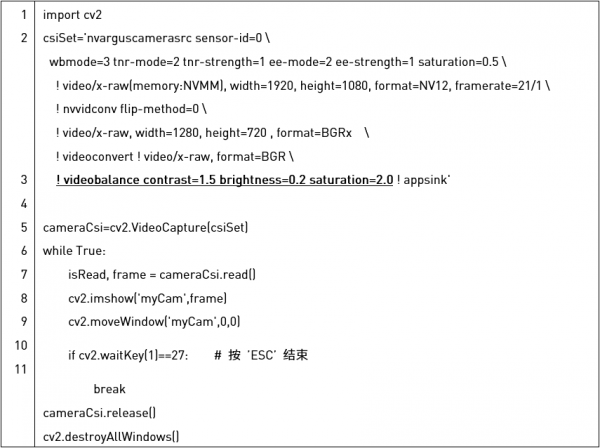

下面代码做以下的测试设定,见于“粗体底线”部分:

-

对比度 constrast(预设值为 1)设为 1.5

-

亮度 brightness(预设值为 0)设为 0.2

-

饱和度 saturation(预设值为 1)设为 2.0

添加的代码在下方代码“粗体底线”的部分:

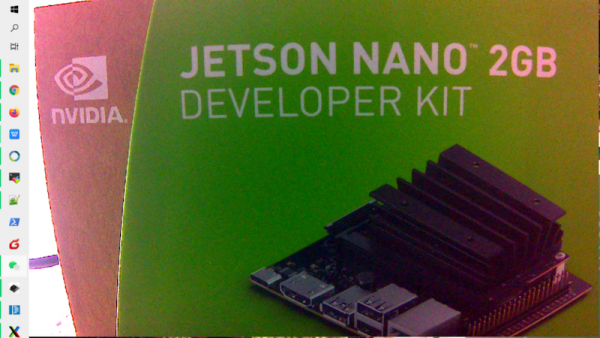

执行结果如下图:

这里的饱和度改变较大,可以看出明显的差异。

以上是简单地透过调整这两个元素的部分参数所作的实验,实际的优化过程还需根据实际状况进行优化调整,特别是光线模式的选择,最好根据当时的状况修改。

来源:英伟达

好文章,需要你的鼓励

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

2026年科技行业多元化发展前景与挑战预测

科技行业女性从业者比例从2015年的16%增至2025年的22%,进步缓慢。尽管各种倡议不断推进,但多元化员工仍面临离职率高、薪酬差距和发展机会不足等问题。2025年经济不确定性导致企业削减多元化项目,美国政策变化也产生连锁反应。随着AI技术快速发展,缺乏多元化团队将导致技术偏见,影响产品质量和市场表现。2026年将成为科技行业多元化发展的关键节点。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

2026年科技行业多元化发展前景与挑战预测

智能体AI推动云安全策略根本性变革

Salesforce推出AI能力框架助力企业数字化转型

大众汽车牵手高通打造智能网联座舱体验

Ruby 4.0.0发布:引入ZJIT编译器和Ruby Box隔离技术

Meta签约三家核能公司为AI数据中心提供6.6吉瓦电力

大多数开发者不信任AI生成代码却不检查

大规模数据中心安全防护中人员因素的关键作用

HPE OneView严重漏洞遭野外攻击利用

安联保险与Anthropic达成全球合作加速负责任AI应用

智能硬件助力Apple Home:Flic物理按钮控制解决方案

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币