扩展对主流CPU的支持 NVIDIA宣布支持Arm为百万兆级超算开辟新路径 原创

至顶网服务器频道 06月18日 新闻消息(文/李祥敬):近日,一年一度的全球超算盛会——ISC2019正在德国法兰克福举行。NVIDIA在ISC2019上宣布CUDA支持Arm CPU,并将于年底前向Arm生态系统提供支持,这将有助力业界构建具有极高能效水平的百万兆级AI超级计算。

NVIDIA GPU加速计算在高性能计算领域的作用不断得以凸显。。今年的Top500榜单中,采用GPU加速的超级计算机数量达到了125台,较去年增长了25%。在排名前10的超级计算机中,有一半都采用了GPU加速,其中就包括了世界上最快的ORNL Summit和排名第二的LLNL Sierra。

此外,欧洲最快的超级计算机Piz Daint和日本最快的超级计算机ABCI也都采用了NVIDIA Tesla GPU加速。在软件开发方面,NVIDIA开发者增长了50%,600多个CUDA应用问世,GPU性能得到不断提升,NVIDIA GPU浮点计算能力更是较去年提升了45%。

NVIDIA驱动了当今最快的超算系统,其打造的GPU成为人工智能计算的基石。另外,根据最新发布的Green500排行榜,在全球最节能的25款超级计算机中,有22款都得益于NVIDIA的支持,包括CUDA GPU、NVIDIA与Mellanox合作优化整体超级计算集群的处理;以及NVIDIA发明的SXM 3D封装和可实现极密集型扩展节点的NVIDIA NVLink互连技术。GPU已经成为了打造高能效超级计算机的核心加速计算平台。

NVIDIA加速计算和Arm高能效CPU架构结合,助力业界构建具有极高能效水平的百万兆级AI超级计算机

现在计算多样化,比如通用计算、异构计算等,这直接驱动了GPU、FPGA、POWER、Arm等芯片架构的发展。NVIDIA在ISC2019上宣布将于年底前向Arm生态系统提供支持。

在笔者看来,NVIDIA对于Arm架构的支持,补齐了GPU加速计算对于主流CPU架构的支持,这包括x86、POWER和Arm。这意味着什么呢?这意味NVIDIA对于算力的全覆盖,x86代表了通用计算,而POWER是关键业务计算,Arm代表了端计算或者边缘计算。

所以,我们也就明白了NVIDIA与Arm的合作代表了NVIDIA对于AI算力的思考,毕竟现在除了云端AI,边缘AI同样重要,云端协同才能发挥AI的最大价值。而NVIDIA统一的加速软件堆栈为云端一体化AI提供了有力支撑。

同时,众所周知,功耗问题成为HPC和AI前行面临的一大挑战,毕竟它们对于算力的需求是巨大的,但是问题也来了,那就是巨大的功耗功率和能源问题。而Arm在低功耗方面非常突出,NVIDIA CUDA加速的计算和Arm的高能效CPU架构的相结合,将助力业界构建具有极高能效水平的百万兆级AI超级计算机。

NVIDIA提供对Arm的支持,将CUDA加速引入Arm架构,这对于整个产业界而言具有里程碑意义,Atos、Cray、CSC、HPE、Marvell、Mellanox等超算中心和系统提供商以及系统级芯片制造商已经在Arm架构上进行相关测试。

比如Cray系统管理和编程环境(编译器、库和工具)已经能够在XC和未来的Shasta超级计算机上支持Arm处理器,将CUDA和CUDA-X HPC和AI软件堆栈用于Arm平台,并将其与Cray系统管理和编程环境紧密集成,能够助力Cray实现百万兆级时代超级计算机实现的愿景。

HPE Apollo 70是一款基于Arm的专用HPC系统,现支持NVIDIA GPU。NVIDIA对Arm的支持为HPE Apollo 70的发展提供了进一步的加持,HPE Apollo 70支持2U GPU托盘和多种节能冷却选项,让HPE能够进一步助力HPC行业解决日益不可持续的功耗水平问题。

综上所述,依托NVIDIA和Arm成熟的生态,NVIDIA实现对于Arm的支持,为当前HPC和AI的发展拓展了更为广阔的发展路径。这对于双方以及各自生态的影响是深远的,也是整个产业界乐见其成的。

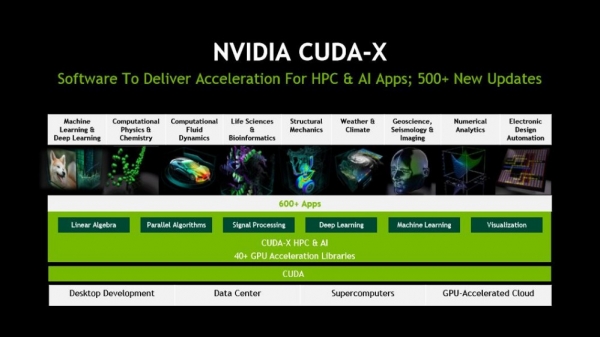

CUDA-X与NGC持续更新优化,加速HPC与AI融合

当前,HPC与AI的融合趋势非常明显。无论是医疗健康、工业制造,还是交通运输、金融投资,围绕数据所产生的智能化分析充斥着人们的工作和生活,AI似乎无处不在。HPC的出现,则在算力乃至算法层面加速了这一进程。HPL-AI是一种新的评估AI超算能力指标,对比评测结果,NVIDIA借助技术创新让全球最快超级计算机SUMMIT实现了3倍多的性能表现。

NVIDIA提供了的全堆栈的AI和HPC软件,为600多个HPC应用程序和所有AI框架提供加速,这包括了所有NVIDIA CUDA-X AI和HPC库、GPU加速的AI框架和软件开发工具,如支持OpenACC的PGI编译器和性能分析器。其中,为了加速HPC和AI应用,NVIDIA CUDA-X进行了500多项更新。CUDA-X包含十几个专用加速库,能够将机器学习和数据科学工作负载加速至高达50倍,其通过充分利用NVIDIA Tensor Core GPU加速工作负载处理。

同时,NVIDIA NGC进行了更新,支持更好地应用部署HPC和AI应用。NVIDIA NGC是一个综合资源库,包括GPU加速软件、经预先训练的AI模型、数据分析模型训练、机器学习、深度学习、以及通过CUDA-X AI加速的高性能计算。更新的NVIDIA NGC集成了GPU优化的软件Hub,支持60个预训练的AI模型,15多个模型训练脚本,针对行业应用(医学影像、视频分析等)的流程。目前,客户更广泛得采纳NVIDIA NGC,200多个超算网站和800多家高校进行了部署。

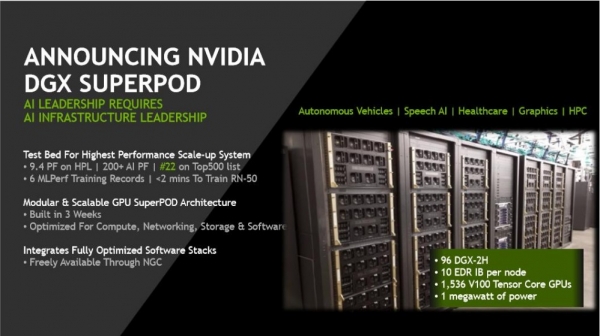

全球No.22超算DGX SuperPOD,三周可部署,比同类系统体积小400倍,让大规模计算能力普惠更多行业

除了软件层面的更新,NVIDIA在硬件创新也进行了积极探索。在GTC 2019上,针对超算和超大规模数据中心NVIDIA推出了NVIDIA DGX-2和NVIDIA DGX POD全新产品。依托DGX POD,企业可以构建基于DGX POD的AI基础架构,实现大规模AI。

在ISC2019上,我们迎来了DGX SuperPOD。这是NVIDIA推出的全球速度排名第22位的超级计算机,该超级计算机系统的搭建仅用时3个星期,采用了96台NVIDIA DGX-2H超级计算机(内含1536颗NVIDIA V100 Tensor Core GPU),由NVIDIA NVSwitch及Mellanox网络结构相联接。其处理能力高达9.4Petaflops,例如DGX SuperPOD软硬件平台能够在不到2分钟的时间之内完成ResNet-50训练。在2015年,该人工智能模型推出的时候,即便采用当时最先进的系统——单颗NVIDIA K80 GPU,也需要25天才能了完成训练任务。而DGX SuperPOD生成结果的速度较之加快了18000倍。

具备同等性能的其他TOP500超级计算机系统都由数千台服务器构建而成,而DGX SuperPOD占地面积更少,其体积比这些同等系统小400倍左右。得益于其模块化和企业级设计,该系统还能够以极快的速度完成部署。其他同等规模的系统通常需要6-9个月才能完成部署毕,而对于DGX SuperPOD而言,在工程师采用经过验证的规范性方法情况下,其仅需3个星期即可部署完毕。对于希望部署NVIDIA SuperPOD架构的用户来说,他们可以

通过构建像DGX SuperPOD这样的超级计算机,这让大规模计算能力得以跨出学术界,为那些想要使用高性能计算加快其各种计划的交通运输公司及其他行业所用。如果他们希望使用NVIDIA SuperPOD架构的用户来说,他们可以通过DGX-Ready Data Center计划获取相关服务。

通过自身软硬件的集成和协同,同时依靠庞大的生态,NVIDIA DGX系统正在成为企业落地HPC和AI的重要支撑。如今,NVIDIA DGX系统已经被众多有着大规模计算需求的企业机构所采用,例如宝马、Continental、福特与Zenuity等汽车公司,还有Facebook、微软与富士胶片等公司,以及日本理化学研究所与美国能源部实验室等。

结语

当前随着算力的极大丰富,HPC与AI的应用创新不断深入发展。同时,在算法层面,NVIDIA为HPC和AI提供了全面的软件堆栈,借助自身的GPU架构,驱动多样化的工作负载。得益于在软硬件方面的持续发展,NVIDIA在加速计算的路上越走越远。

好文章,需要你的鼓励

亚马逊推出Alexa网页版:生成式AI助手的新选择

亚马逊在CES期间宣布推出Alexa.com网站,用户可像使用其他AI聊天机器人一样与Alexa交互。经过数月早期体验,Alexa+已获得数千万用户。新网站支持语音和文本交互,需登录使用以确保跨设备功能连续性。76%的Alexa+交互为独特任务,包括智能家居控制和第三方集成。Alexa+兼容七年来的设备,正式版将收费每月20美元或包含在Prime会员中。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

AI笔记公司Plaud在CES 2026推出新款可穿戴设备NotePin S,可夹在衣领、戴在手腕或挂在脖子上记录对话。该设备通过蓝牙连接手机,配备双麦克风,录制范围约3米,支持一键高亮标记重要时刻。同时发布的还有Plaud Desktop桌面AI记录工具,可原生捕获线上会议内容,无需机器人加入通话。两款产品将所有笔记、会议和对话整合到统一平台管理。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

亚马逊推出Alexa网页版:生成式AI助手的新选择

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

机器人初创公司推出现实版瓦力机器人及其他伴侣产品

VisIC宣布完成2,600万美元B轮融资

CES 2026 | AMD扩张“边缘统治力” “芯片级异构”塑造汽车、工业边缘应用“新法则”

CES 2026 | NVIDIA新风向: Rubin平台面市 ,系统级“AI工厂”成型,物理AI加速落地

英伟达Vera-Rubin平台推出前六月已淘汰现有AI硬件

英特尔推出首批18A工艺制程的Core Ultra处理器

Rokid在CES 2026推出无屏AI智能眼镜

英伟达物理AI模型为新一代机器人铺路

微软发布 GitHub Copilot 的 C++ 代码编辑工具

至顶AI实验室硬核评测:戴尔Precision 5690移动工作站,部署DeepSeek+LobeChat打造个人超级智能体