NVIDIA扩充NGC软件中心,助力数据科学家加速构建优化型解决方案

NGC为越来越多的AI容器添加了模型、模型脚本和行业解决方案;NGC-Ready企业级服务器和支持服务的新浪潮推动了GPU加速AI的发展。

无论是为了推进科学进步,还是构建自动驾驶汽车,或是基于海量数据获得业务洞察力,数据科学家、研究人员和开发者都需要强大的GPU算力,以及适用的软件工具。

AI很复杂,构建模型的过程可能非常耗时。容器技术对于简化复杂的部署和工作流程起着至关重要的作用。

在GTC 2019,NVIDIA进一步扩充了NGC(NGC是一个包含了深度学习、机器学习、HPC等基础软件的软件中心),加入了预先训练的AI模型、模型训练脚本和行业专用软件堆栈。

借助这些新工具,无论技术水平高低,都能够通过AI快速轻松地实现价值。

以NGC为后盾,让您能够专注开展业务

数据科学家的时间非常宝贵,然而构建模型所需的计算资源很大。如果他们花费数小时甚至数天从源头开始编译框架却出现了错误,将会影响其生产力和收入并降低竞争优势。

成千上万的数据科学家和开发者已开始使用NGC中性能优化的深度学习框架容器,如TensorFlow和PyTorch,这些框架容器每月更新一次。如此一来,他们就能避开耗时且容易出错的部署流程,转而专注于构建解决方案。

NGC为那些希望追赶最新计算趋势潮流的公司降低了入门门槛。而对于那些已经走在潮流中的公司来说,NGC又让他们能够以更快的速度实现更大的价值。

通过预训练模型和训练脚本加速AI项目

许多AI应用程序都有共同的需求:分类、对象检测、语言翻译、文本转语音、推荐引擎、情感分析等等。在使用这些功能开发应用程序或服务时,根据您的用例对一个预先训练的模型进行调整,要比从头开始快得多。

NGC的新模型注册为数据科学家和研究人员提供了最常用的AI模型库,让他们能够由此启程,对AI应用程序进行重新训练和基准测试,并快速进行构建。

NGC企业帐户持有者还可通过托管私有注册,在其机构和团队中进行模型上传、共享、以及版本化。模型注册可通过https://ngc.nvidia.com和命令行界面进行访问,因此用户可将其部署于混合云环境中,并为其机构提供对版本化模型的有限的访问权限。

NGC还提供模型训练脚本,利用NVIDIA Tensor Core赋力的混合精度可为其提供最佳的实践效果,使NVIDIA Turing和Volta GPU相较于前几代在进行训练和推理时能实现3倍的性能提升。

通过提供经过精确度测试和融合测试的模型和训练脚本,NGC能够帮助用户对其最为重要的NVIDIA深度学习资产进行集中化和管理。

医学影像和智慧城市的训练和部署堆栈

跨行业的高效工作流程始于预先训练的模型,然后使用新的数据执行迁移学习训练。接下来,再对网络进行精简和优化,然后部署到边缘设备上进行推理。将这些预先训练的模型与迁移学习相结合,就无需耗费高昂的成本从头开始,大规模收集数据、添加标签并训练模型,能够让业内专家快速启动深度学习工作流程。

但是,训练、优化和部署的细节却因行业而异。NGC如今面向智慧城市和医学影像领域提供了具有针对性的工作流程。

在智慧城市领域, 用于流式传输分析的NVIDIA迁移学习工具包提供为智能视频分析工作负载量身定制的迁移学习,例如对象检测和摄像头视频帧分类。然后通过面向智慧城市的NVIDIA DeepStream SDK ,将经过重新训练、优化和精简的模型部署到NVIDIA Tesla或Jetson平台。

在医学影像领域,NVIDIA Clara Train SDK使医疗机构能够先使用预先训练的MRI扫描模型进行器官分割,然后使用迁移学习来根据该机构的数据集对这些模型进行改进。Clara Train会生成优化模型,然后使用NVIDIA Clara Deploy SDK进行部署,以便日后为新患者的扫描结果提供更强大的分割能力。

NGC-Ready系统——针对AI工作负载优化的验证平台

由全球顶级系统制造商提供的NGC-Ready系统已经过NVIDIA验证,因此数据科学家和开发者能够以最优方式加速运行深度学习和机器学习工作负载。

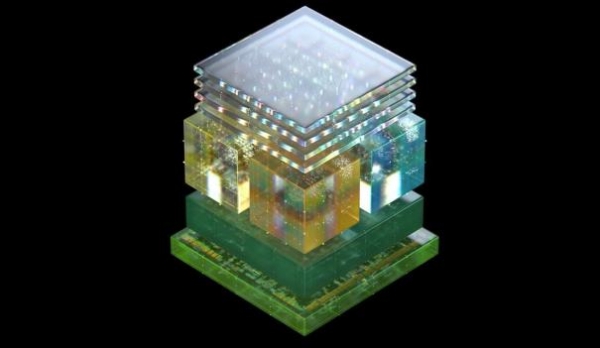

基于NVIDIA V100 GPU的旗舰系统,具有640个Tensor Core和高达32GB的内存。为实现最大限度的利用率,由全新NVIDIA T4 GPU赋力的系统在各种加速工作负载中均展现了出色的性能,包括机器学习、深度学习、虚拟桌面和HPC。

从容部署AI基础架构

AI的跨行业应用迅猛飙升。这就需要IT团队能够支持不同用户群的各类新型工作负载、软件堆栈和硬件。在应用环境发生变化的时候,最大限度地减少系统停机时间、保持用户工作效率至关重要。

为解决这一问题,我们推出了NVIDIA NGC支持服务,提供企业级支持以确保NGC-Ready系统实现最优运行,并最大限度地提高系统利用率和用户工作效率。这些全新服务使IT团队能够直接与NVIDIA相关专家取得联系,快速解决软件问题,最大限度地缩减系统停机时间。

NGC支持服务可通过NGC-Ready系统销售商获取,思科现已针对其思科 UCS C480 ML提供此服务,该产品采用了NVIDIA V100系统,经NGC-Ready验证。HPE将于6月份起针对其HPE ProLiant DL380 Gen10服务器提供此服务,该服务器采用NVIDIA T4系统,经NGC-Ready验证。其他几家OEM也将在未来几个月内开始销售这些服务。

好文章,需要你的鼓励

大多数 AI 项目仅停留在构建阶段:为何主权控制是规模化成功的关键

尽管AI实验广泛开展,但大多数AI项目缺乏成熟度无法规模化。93%的组织在使用或构建AI系统,但仅不到10%建立了强健的治理框架。研究显示,超过50%的AI实验从未投产,仅1%的项目实现真正变革性成果。缺乏数据和AI主权是关键障碍,而拥有主权的组织AI项目成功率提升2倍,回报率增长5倍。

香港中大联合牛津等名校:AI视频已能完美骗过人工智能检测,连顶级模型都认不出真假

香港中文大学等顶尖院校联合研究发现,当前最先进的AI视频生成技术已能制作出连顶级检测系统都无法识别的假视频。研究团队开发了Video Reality Test平台,测试结果显示最强生成模型Veo3.1-Fast的假视频仅有12.54%被识别,而最强检测系统Gemini 2.5-Pro准确率仅56%,远低于人类专家的81.25%。研究还发现检测系统过度依赖水印等表面特征,音频信息能提升检测准确性,但技术发展已对信息真实性判断带来严峻挑战。

企业AI价值实现的五大人力准备障碍

企业正竞相释放AI的变革潜力,但真正的瓶颈不在技术而在人力准备度。Gartner研究显示,56%的CEO计划在未来五年削减管理层级,但91%的CIO未跟踪AI引发的技能变化。超过80%的领导者根本不衡量AI准确性。AI价值取决于员工适应和与智能机器共同发展的能力。CIO必须应对五个关键人力障碍:AI退出效应、中层管理困境、行为副产品、准确性悖论和影子AI现象,这些深层次的行为反射和组织动态如不解决将阻碍转型。

Google DeepMind让AI画图快了一半,“预览模式“让创作者告别漫长等待

Google DeepMind团队提出了革命性的"扩散预览"模式,通过ConsistencySolver技术实现AI图像生成的"预览+精修"工作流程。该技术能在5-10步内生成高质量预览图像,与传统40步完整生成保持高度一致性,用户体验测试显示总体时间节省近50%,大大提高了创作效率和创意探索的自由度。

大多数 AI 项目仅停留在构建阶段:为何主权控制是规模化成功的关键

企业AI价值实现的五大人力准备障碍

企业AI PC普及将在2026年放缓

AI闪耀中国!联想天禧AI亮相吴晓波科技人文秀

亚马逊全新通用型EC2 M8a实例正式发布

IBM推出SAP迁移管理工具应对2027年系统升级截止期

博通AI硬件收入激增65%,VMware业务稳健增长

英伟达发布Nemotron 3开源模型助力可扩展多智能体系统

从AI到模拟对抗,网络安全桌面演练今年有了新变化

Equity 2026年预测:AI智能体崛起、重磅IPO与风投行业变革

英伟达护城河难撼动,Gemini无法击败OpenAI

山河为证,荣誉加冕,华为乾崑助传祺向往S9首次智行中国顺利收官

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币