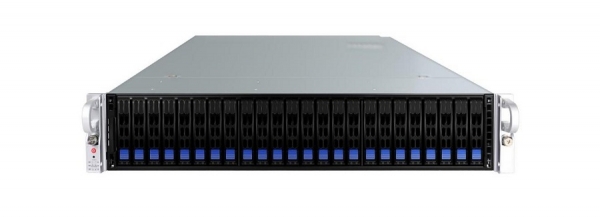

智慧算力 极致性能:杰和2U四路关键业务服务器

业内,提及关键业务服务器,必然有一个词与之紧密相关,即RAS特性:可靠性(Reliability)、可用性(Availability)以及可服务性(Serviceability)。甚至用户对于RAS特性的关注程度不亚于对性能、可扩展性的重视。这是为什么呢?因为RAS特性关乎关键业务能否连续地运行下去,而关键业务一旦出现问题,造成的损失是难以估量的,关系到企业的声誉、关乎企业未来的发展。杰和2U四路服务器GCR2524MP-RF凭借强大的计算能力和优异的能效比,在可靠性、可用性、可服务性等方面表现优异,非常适用于政府、通信、金融、证券及各类大型企业等对系统性能、扩展性和稳定性有着较高要求的关键业务应用领域。

杰和GCR2524MP-RF是一款2U四路标准机架式关键业务服务器。采用英特尔® C612服务器专用芯片组,最大支持四个英特尔® 至强® E5 4600 v3/v4处理器,具备强大的计算能力和优异的能效比。秉承旗舰级四路服务器产品定义,杰和GCR2524MP-RF整机最大支持24个2.5寸热插拔SSD硬盘,集成2个高性能千兆网卡,2个万兆网卡(可选),支持网络唤醒、网络冗余、负载均衡等网络高级特性,满足虚拟化应用对网络带宽的苛刻需求。其应用场景:大型数据中心的虚拟化整合,大型应用软件的中间件应用,大型数据库应用,数据挖掘,联机事务处理等,以及对性能有较高要求的大型政府、企业的数据库及核心业务软件应用。

极致全能的性能表现,满足苛刻的应用要求

采用英特尔® 至强® E5-4600 v3/v4系列处理器,整机拥有高达88个计算核心、176个计算线程、220MB 片内高速缓存,大幅提高应用处理性能。支持8通道 12G SAS RAID 控制器,硬盘数据带宽提升 100%。支持4颗NVMe接口的2.5英寸PCIE SSD硬盘,大幅提升系统IO吞吐能力的同时简化了系统维护难度,非常适合分级存储机制。标配1600W白金效率冗余电源模块。优异配置带来的强劲性能表现,使其满足多种苛刻的应用需求,是大型数据库、ERP、CRM、大数据、高性能计算和虚拟化整合等主流应用的最佳选择。

扩展灵活,从容应对各种场景

杰和GCR2524MP-RF具备强大的内存扩展能力,最大支持48个内存插槽,支持DDR4 1600/1866/2133/2400MHz内存,最大内存容量3TB(LRDIMM)。采用24盘位设计,支持2.5寸热插拔SSD硬盘,其中 4 颗 支持NVMe 接口,可连接2.5寸PCIE SSD 硬盘。支持1/0/10/5/50/60级别磁盘阵列,灵活配置本地存储,提高数据处理及数据保护性能。提供7个PCIe 3.0扩展插槽,最大支持2块GPU协处理卡,满足面向未来IT的企业级应用需求。凭借深厚的技术实力、持续创新和敏锐的市场洞察,聚焦高质量产品与服务,杰和四路服务器GCR2524MP-RF从容应对大型数据库、企业资源规划(ERP)、CRM、虚拟化整合等应用场景。

高效的管理方案,易于维护的系统架构

考虑到数据中心构建复杂性的特点,杰和GCR2524MP-RF采用熟悉的2U标准机架式外形,系统关键部件如电源、系统风扇、硬盘等均采用热插拔设计,一旦出现故障,用户可不宕机换件,保证系统的不停顿运作,提升系统的可用性。而且用户可以根据自身业务需求灵活选配合适的系统组件进行分段投资,有效降低企业的TCO,是主流数据中心的理想服务器。高效的管理方案是用户选择服务器的重要标准之一,杰和GIM服务器管理平台基于IPMI标准,借助Web的图形用户管理界面管理和监控服务器的状态,提供全面的远程系统监测、管理和控制功能,及时发现和排除服务器故障,大大降低服务器维护的费用并提高维护效率。

杰和通用服务器产品系列

好文章,需要你的鼓励

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

洛杉矶大火一年后,亚马逊Ring安全服务推出Fire Watch功能以降低野火风险。该功能集成在Ring应用的邻里版块中,计划今春全美推广。系统依托非营利组织Watch Duty的野火预警,当检测到野火时会通知附近用户,符合条件的户外摄像头将启用AI图像识别监测火情。Ring还推出AI异常事件预警和主动警告功能。但隐私问题仍存争议,多个州因隐私法限制相关AI功能使用。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

Snowflake与Google Gemini深度整合,全云环境支持数据分析

数据平台Snowflake将谷歌Gemini模型集成到其Cortex AI中,让客户在数据环境边界内访问基础模型。Cortex AI支持跨云推理,无论客户环境运行在AWS、Azure还是谷歌云上。该平台已支持OpenAI、Anthropic等多家模型提供商,采用按需付费模式。客户可通过SQL或API直接访问模型,分析多模态数据并构建AI应用场景。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

TOTOLINK EX200存在未修复固件漏洞可被完全远程接管

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

Snowflake与Google Gemini深度整合,全云环境支持数据分析

联想和摩托罗拉推出自有设备端AI助手

机器海龟游向环保使命:仿生技术守护珊瑚礁

CES 2026最酷笔记本电脑:可拆卸设计成为新趋势

AMD 在 CES 2026 发布新款锐龙处理器、Ryzen AI 及 AMD ROCm,全面扩展其在客户端、图形和软件领域的 AI 领先地位

AMD发布Instinct GPU新品挑战英伟达数据中心霸主地位

NVIDIA创始人兼CEO黄仁勋荣获技术领域最高荣誉——2026年IEEE荣誉奖章

红帽深化与NVIDIA的合作,将企业级开源与机架级AI深度结合,加速实现可投入生产的创新

Linux在CES 2026:企鹅系统依然活跃于物联网、汽车和AI领域