Nvidia T4 GPU芯片将落地谷歌云及主流服务器系统

图形芯片已经成为实现人工智能的标准,因为人工智能非常适合于加速视频游戏的并行处理。现在,图形芯片越来越多地进入云计算领域,在这个领域中那些提供图像和语音识别、自动驾驶汽车的企业可以租赁图形芯片的处理能力。

特别是,来自市场领导者Nvidia的GPU专注于在网络边缘执行AI任务,以实现服务的加速。这个被称为推理的过程指的是神经网络能够从实时呈现的新数据中进行事物推断——这与预先训练模型的过程有所不同。

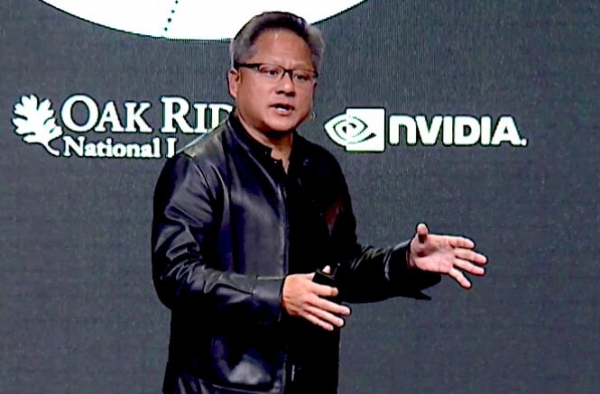

近日,Nvidia首席执行官黄仁勋公布了最新的T4云GPU,并将于9月推出,在Google的云上提供。他在本周达拉斯举行的SC18超级计算大会的主题演讲中宣布了这一消息。

谷歌是第一个支持T4访问的云提供商,但它不会是最后一个。Nvidia副总裁、加速计算总经理Ian Buck在一次简报中表示:“它在云中的速度令人印象深刻。我们正处于GPU计算兴起的时代。”

谷歌的云并不是唯一支持T4的云。来自Dell EMC、IBM、联想和超微等主要计算机制造商的大约57种服务器设计也采用了这种芯片,其大小与手机相当。

Buck表示,由于体积小、运行功率相对较低,因此T4适合在网络边缘运行AI应用,此外还可用于AI模型和计算机图形的分布式训练。

谷歌似乎更专注于推理,并通过深度学习虚拟机图像在Google Compute Engine进行推理,而且很快将通过Google Kubernetes Engine,以及通过谷歌的Cloud Machine Learning Engine,用于管理容器(这种软件可以使应用在多个计算环境中无需更改即可运行)。

尽管Nvidia在加速人工智能计算工作、以及使用GPU来弥补CPU芯片(仍然是大多数计算机的核心)性能提升放缓方面处于领先地位,但由于人工智能服务的迅速发展,Nvidia也面临越来越激烈的竞争,例如来自AMD、英特尔和Xilinx等芯片制造商,以及其他如FPGA定制芯片和应用专用集成电路等其他类型芯片带来的挑战。

Moor Insights&Strategy总裁兼首席分析师Patrick Moorhead表示:“摩尔定律的放缓正在推动采用GPU、FPGA和ASIC的异构数据中心计算的加速。像AMD、英特尔、Nvidia和Xilinx这样的公司正在加速整个领域的一切。”

Nvidia今天还谈到了在超级计算领域的覆盖,在本周公布的半年度TOP500超级计算机榜单中,使用Nvidia GPU的系统数量比去年同期增长了48%,达到127套。此外,Nvidia的芯片也被用于位于榜单第一和第二位置的两套超级计算机,美国能源部部署在橡树岭国家实验室的Summit超级计算机,以及部署在劳伦斯利弗莫尔国家实验室的Sierra超级计算机。

黄仁勋表示:“这是Nvidia在超级计算领域取得突破的一年。随着摩尔定律的终结,一个又人工智能和机器学习工作负载驱动的全新HPC市场正在出现。”

好文章,需要你的鼓励

科技巨头预测2026年AI发展趋势:治理和投资回报成关键

戴尔、微软、Salesforce等科技领导者发布2026年AI预测,认为AI代理安全防护和投资回报率是客户关注焦点。戴尔CTO预测AI将转向本地部署以加强控制;ServiceNow强调AI价值必须体现在业务收益上;Snowflake重视数据治理在AI代理管控中的作用;Salesforce认为AI将成为品牌形象代言人;微软强调信任是AI代理部署的关键要素。

MBZUAI和法国综合理工学院最新突破:让AI写作比人工快4倍的神奇算法

MBZUAI和法国综合理工学院联合开发的SchED算法能让AI写作速度提升3-4倍。该算法通过监测AI生成文本的置信度,采用进度感知的动态阈值策略,在保持99.8%-100%原始质量的同时显著减少计算时间。实验覆盖多种任务类型,证明了算法的有效性和鲁棒性。

苹果2026年六大产品发布前瞻

苹果计划在2026年推出多款重磅新品,包括配备miniLED面板和A19 Pro芯片的27英寸外接显示器、搭载homeOS系统的7英寸智能家居控制设备、首次采用OLED屏幕的全新MacBook Pro、具备7.8英寸内屏的iPhone Fold折叠手机、售价699美元起的入门级MacBook,以及升级OLED显示技术的iPad mini。

西安交通大学突破性发现:让AI“忽略“功能词,视觉语言模型免费获得超强防御力

西安交通大学研究团队发现,AI视觉语言模型容易受到功能词(如"是"、"的"等)的干扰而遭受攻击。他们开发了功能词去注意力(FDA)机制,让AI减少对这些词汇的关注。测试显示,该方法可将攻击成功率降低18%-90%,而正常性能仅下降0.2%-0.6%。FDA无需额外训练即可集成到现有模型中,为AI安全防护提供了简单有效的解决方案。