NVIDIA AI芯片Jetson Xavier亮相WRC 2018世界机器人大会 原创

至顶网服务器频道 08月27日 新闻消息(文/李祥敬): 在前不久举行的WRC 2018世界机器人大会上,NVIDIA展出了专为机器人设计的芯片Jetson Xavier。同时,NVIDIA高级软件经理李铭博士也向媒体详细介绍了这款芯片的特点,阐述了Jetson Xavier如何推动机器人软硬件技术的发展。

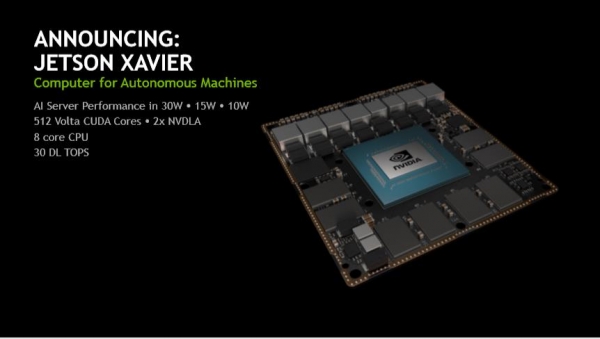

NVIDIA Jetson Xavier于今年6月初在2018年台北国际电脑展(COMPUTEX 2018)上首发,NVIDIA将其描述为一台适用于自主机器人的AI计算机。NVIDIA创始人兼首席执行官黄仁勋在发布这款芯片的时候说,这就是未来智能机器人的大脑。在NVIDIA看来,机器人终归是要拥有超强的边缘计算能力,而Jetson Xavier正是为了下一代自主机器打造的AI计算芯片。

李铭表示,当前人工智能已经发展到了一个转折点,而GPU芯片可凭借其可变性和超强的计算力以及CUDA平台为AI的发展提供了强有力的支持。现在NVIDIA将GPU带到了机器人领域,将Jetson Xavier打造成未来智能机器人的大脑。

专为机器人打造的AI芯片

据介绍,Jetson Xavier是NVIDIA单独做过的最长的一个处理器项目,为了打造它,NVIDIA耗费了五年的时间(三年设计、两年筑造),共有超过8000人参与了设计与开发,也是NVIDIA首款专门为机器人设计的产品。

Jetson Xavier拥有6种高性能处理器,包括1个Volta Tensor Core GPU、1个8核ARM64 CPU、2个NVDLA深度学习加速器、1个图像处理器、1个视觉处理器和1个视频处理器。这些处理器使其能够同时、且实时地处理数十种算法,以用于传感器处理、测距、定位和绘图、视觉和感知以及路径规划。

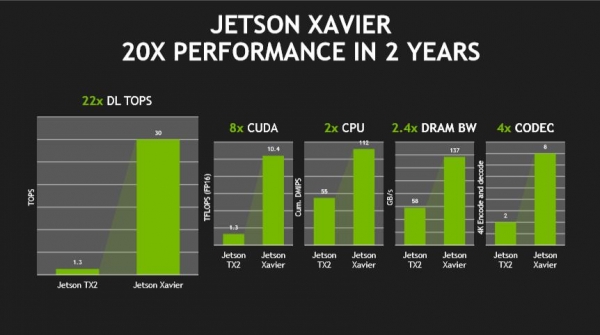

这样的配置让其能够在30W以下的嵌入式模块中提供相当于一台GPU工作站的性能。Jetson Xavier拥有超过90亿个晶体管,可提供每秒30万亿次操作的深度学习和计算机视觉任务。相较于上一代产品Jetson TX2,Jetson Xavier的能效提升了10倍之多,性能优化了20倍之多。

李铭告诉记者,Jetson Xavier专攻自主机器,像机器人手臂、自动化设备与服务型机器人、无人机等,可广泛应用于工业生产线、仓储、物流、零售与农业等多种场景。同时,Jetson Xavier也适用于智慧城市应用程序和便携式医疗设备。

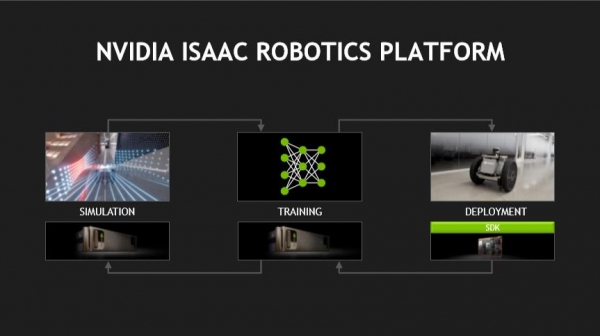

NVIDIA为Jetson Xavier的模拟、训练、验证和部署提供了一个工具箱——NVIDIA Isaac机器人软件平台,包括包含API工具包Isaac SDK、智能机器加速应用Isaac IMX以及高度逼真的虚拟仿真环境Isaac Sim。

- Isaac SDK,一套API和工具,支持开发机器人算法软件及运行时框架。

- Isaac IMX,Isaac智能机器加速应用,是NVIDIA开发的机器人算法软件的集合。

- Isaac SIM,提供高度逼真的虚拟仿真环境,具备高保真度,并可以借助Jetson Xavier进行硬件测试。

李铭特别指出,Isaac SIM可以在虚拟世界中对机器人进行训练,而不用担心对现实物理世界造成破坏性的影响,比如在训练消防机器人或者其他复杂性环境的工作机器人。NVIDIA希望为机器人产业打造一个端到端的解决方案。

黄仁勋也为我们描述了未来智能机器人产业的美好前景,他说,AI是我们这一时代最强大的技术力量。第一阶段人工智能将实现全新的软件自动化水平,从而帮助诸多行业提高生产力;其后,人工智能与传感器和执行器相结合,将成为新一代自主机器的核心。终有一天,数十亿台智能机器人将用于制造、送货上门服务、仓储物流等领域。

来源:至顶网服务器频道

好文章,需要你的鼓励

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

洛杉矶大火一年后,亚马逊Ring安全服务推出Fire Watch功能以降低野火风险。该功能集成在Ring应用的邻里版块中,计划今春全美推广。系统依托非营利组织Watch Duty的野火预警,当检测到野火时会通知附近用户,符合条件的户外摄像头将启用AI图像识别监测火情。Ring还推出AI异常事件预警和主动警告功能。但隐私问题仍存争议,多个州因隐私法限制相关AI功能使用。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

Snowflake与Google Gemini深度整合,全云环境支持数据分析

数据平台Snowflake将谷歌Gemini模型集成到其Cortex AI中,让客户在数据环境边界内访问基础模型。Cortex AI支持跨云推理,无论客户环境运行在AWS、Azure还是谷歌云上。该平台已支持OpenAI、Anthropic等多家模型提供商,采用按需付费模式。客户可通过SQL或API直接访问模型,分析多模态数据并构建AI应用场景。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

TOTOLINK EX200存在未修复固件漏洞可被完全远程接管

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

Snowflake与Google Gemini深度整合,全云环境支持数据分析

联想和摩托罗拉推出自有设备端AI助手

机器海龟游向环保使命:仿生技术守护珊瑚礁

CES 2026最酷笔记本电脑:可拆卸设计成为新趋势

AMD 在 CES 2026 发布新款锐龙处理器、Ryzen AI 及 AMD ROCm,全面扩展其在客户端、图形和软件领域的 AI 领先地位

AMD发布Instinct GPU新品挑战英伟达数据中心霸主地位

NVIDIA创始人兼CEO黄仁勋荣获技术领域最高荣誉——2026年IEEE荣誉奖章

红帽深化与NVIDIA的合作,将企业级开源与机架级AI深度结合,加速实现可投入生产的创新

Linux在CES 2026:企鹅系统依然活跃于物联网、汽车和AI领域

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币