NVIDIA发布Turing架构,为计算机图形领域带来革新

混合渲染通过融合实时光线追踪、AI、模拟和光栅化,为计算机图形带来根本性变革

加拿大不列颠哥伦比亚省温哥华——SIGGRAPH——太平洋时间2018年8月13日——NVIDIA今日推出NVIDIA Turing GPU架构,为计算机图形领域带来革新。

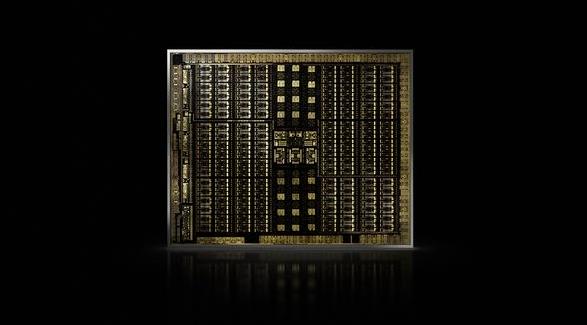

Turing架构是自2006年发明CUDA GPU以来的重大飞跃,其采用了可加速光线追踪的全新RT Core,以及面向AI推理的Tensor Core,首次使实时光线追踪成为可能。

这两者结合更强大的模拟计算和光栅化功能,迎来了新一代混合渲染,能够满足价值2500亿美元的视效行业需求。混合渲染可实现影院级的交互式体验、基于神经网络的全新惊艳效果、以及在高度复杂模型上的流畅交互。

NVIDIA还推出了率先采用Turing架构的产品——NVIDIA Quadro RTX 8000、Quadro RTX 6000及Quadro RTX 5000 GPU,其将为各行各业中约5000万设计师和艺术家的工作带来变革。

NVIDIA创始人兼首席执行官黄仁勋在年度SIGGRAPH大会期间的演讲中提到:“Turing架构是NVIDIA十多年来在计算机图形领域最为重要的创新。混合渲染将为行业带来变革,开启令人惊叹的可能性,通过更美观的设计、更丰富的娱乐、以及更多的互动体验来改善我们的生活。实时光线追踪的到来也是我们全行业的梦想成真。”

Turing架构是NVIDIA的第八代GPU架构,使全球首款光线追踪GPU成为可能,也是超过一万个工程年的努力成果。借助Turing的混合渲染功能,应用能够以相当于早前Pascal一代6倍的速度对物理世界进行模拟。

为助力开发者充分利用这些功能,NVIDIA通过全新AI、光线追踪和模拟SDK,强化了其RTX开发平台,并宣布成百上千万名设计师、艺术家和科学家所采用的主要图形应用均计划通过RTX开发平台充分发挥Turing架构的特性。

分析公司JPR首席执行官Jon Peddie表示:“这是计算机图形学史上的一大重要时刻。NVIDIA实现了实时光线追踪,而此前我们都认为这可能要到五年之后才能实现。”

RT Core加速实时光线追踪

Turing架构采用了名为RT Core的专用光线追踪处理器,能够以高达每秒10GigaRays的速度对光线和声音在3D环境中的传播进行加速计算。Turing架构将实时光线追踪运算加速至早前Pascal架构的25倍,且GPU节点可用于电影效果的最终帧渲染,其速度是CPU节点的30倍之多。

Cinesite首席技术官Michele Sciolette表示:“Cinesite很荣幸能够与Autodesk和NVIDIA合作,使Arnold能够用于GPU渲染,但如此令人叹为观止的效果仍超出了我们的预期。这意味着我们能够在更高画质的场景中更快速、更频繁地进行迭代。这将彻底改变我们艺术家的工作方式。”

利用强大的Tensor Core实现AI加速

Turing架构还采用了Tensor Core——可加速深度学习训练与推理的处理器,能够提供每秒高达500万亿次Tensor运算。

如此高水平的性能可支持AI增强型功能,助力创建具有强大新功能的应用。这些新功能包括DLAA(深度学习抗锯齿),这是高画质动态图像生成领域内的一项突破,以及去噪、分辨率缩放和视频调速。

这些特性是NVIDIA NGX软件开发套件的一部分,这种全新深度学习技术堆栈可助力开发者通过预先训练的网络,轻松地在应用中集成加速且增强的图形、照片成像和视频处理。

采用全新Turing流式多处理器实现更快速的模拟和光栅化

基于Turing架构的GPU采用了流式多处理器(SM)架构,该架构新增了与浮点数据路径并行执行的整数执行单元,以及带宽为早前架构两倍的全新统一缓存架构。

结合可变速率着色等全新图形技术,Turing SM实现了前所未有的单核性能水平。凭借多达4608个CUDA内核,Turing架构可支持高达16万亿次浮点运算,同时支持每秒16万亿次整数运算。

开发者可利用NVIDIA的CUDA 10、FleX和PhysX SDK来创建复杂的模拟,例如用于科学可视化的粒子或流体动力学、虚拟环境和特殊效果。

供货

最先采用Turing架构的Quadro GPU将于第四季度开始供货。

来源:业界供稿

好文章,需要你的鼓励

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

洛杉矶大火一年后,亚马逊Ring安全服务推出Fire Watch功能以降低野火风险。该功能集成在Ring应用的邻里版块中,计划今春全美推广。系统依托非营利组织Watch Duty的野火预警,当检测到野火时会通知附近用户,符合条件的户外摄像头将启用AI图像识别监测火情。Ring还推出AI异常事件预警和主动警告功能。但隐私问题仍存争议,多个州因隐私法限制相关AI功能使用。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

Snowflake与Google Gemini深度整合,全云环境支持数据分析

数据平台Snowflake将谷歌Gemini模型集成到其Cortex AI中,让客户在数据环境边界内访问基础模型。Cortex AI支持跨云推理,无论客户环境运行在AWS、Azure还是谷歌云上。该平台已支持OpenAI、Anthropic等多家模型提供商,采用按需付费模式。客户可通过SQL或API直接访问模型,分析多模态数据并构建AI应用场景。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

TOTOLINK EX200存在未修复固件漏洞可被完全远程接管

Ring推出Fire Watch功能,利用家庭摄像头追踪野火威胁

Snowflake与Google Gemini深度整合,全云环境支持数据分析

联想和摩托罗拉推出自有设备端AI助手

机器海龟游向环保使命:仿生技术守护珊瑚礁

CES 2026最酷笔记本电脑:可拆卸设计成为新趋势

AMD 在 CES 2026 发布新款锐龙处理器、Ryzen AI 及 AMD ROCm,全面扩展其在客户端、图形和软件领域的 AI 领先地位

AMD发布Instinct GPU新品挑战英伟达数据中心霸主地位

NVIDIA创始人兼CEO黄仁勋荣获技术领域最高荣誉——2026年IEEE荣誉奖章

红帽深化与NVIDIA的合作,将企业级开源与机架级AI深度结合,加速实现可投入生产的创新

Linux在CES 2026:企鹅系统依然活跃于物联网、汽车和AI领域

NVIDIA Blackwell 现已在云端全面可用

为“代理式AI”装上“护栏” NVIDIA打造“三重防线”

黄仁勋现身北京致辞:60年后,计算机正被重新定义

CES 2025 | NVIDIA Isaac GR00T Blueprint 让人形机器人“加速进化”

未来,就在我们手中

CES 2025 | 代理式AI崛起:NVIDIA定义下一代“代理式 AI Blueprint”

深度学习最佳 GPU,知多少?

NVIDIA推出用于多语言生成式人工智能的NeMo Retriever微服务

NVIDIA 初创加速计划 | 2024 NVIDIA 创业企业展示完美收官!

老黄掏出“迷你版AI超算”,每秒67万亿次运算,仅售2070元人民币