强化敏捷与大规模交付 浪潮海外首发InCloud OpenStack 5.5

当地时间,5月21日,浪潮在2018 OpenStack温哥华峰会上正式发布全新InCloud OpenStack 5.5,融合最新的容器技术实现了OpenStack的容器化部署,在规模化部署、简单易用和智能化运维上带来更出色的表现,帮助全球云计算用户更好的构建先进的云基础设施。

此次InCloud OpenStack 5.5海外首发,OpenStack基金会执行总裁Jonathan受邀出席了本次新品发布会,并对新品和浪潮在社区的贡献给予了高度认可。Jonathan表示:作为OpenStack基金会黄金会员的浪潮,对于OpenStack 的贡献在逐年增加,有很多来自浪潮的专家投入到OpenStack中,为数十个的不同项目做出了贡献,浪潮从市场和技术两个维度都为OpenStack做出了很大贡献。

在云计算已成为智慧时代基础设施的当下,浪潮通过与自身服务器、存储产品体系的深度融合,凭借完整的计算虚拟化、软件定义存储、软件定义网络产品体系及整体交付能力,致力于为用户交付敏捷、开放、融合、安全的软硬一体化云基础设施。

峰会现场,浪潮集团副总裁Jay Zhang出席InCloud OpenStack 5.5发布仪式并发表精彩演讲,据Jay Zhang介绍:最新发布的产品更加强调敏捷交付与大规模部署,可满足行业用户对于大规模部署稳定运行、智能化运维、两地三中心等诉求,进一步显示出浪潮持续优化InCloud OpenStack原生产品的创新能力,以及基于行业实践和面向未来的技术发展洞察。

简单易用:一键式容器化部署,资源图形化编排

InCloud OpenStack在安装部署方面,基于容器化技术封装各个组件为独立于宿主操作系统的容器化镜像,依靠统一分发实现一键式批量部署。基于数据可视化组件,实现服务编排可视化拖拽,可基于系统模板或自定义拖拽创建编排模板,通过所见即所得的方式完成资源的编排,提升用户友好度。

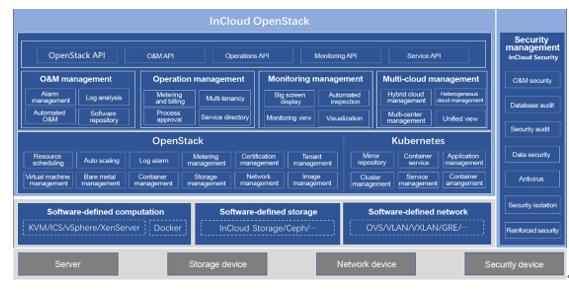

InCloud OpenStack 5.5架构图

云管理:虚拟机、裸机、容器的统一管理

InCloud OpenStack 5.5基于OpenStack架构实现了虚拟机、裸机、容器三种计算资源的同平台统一管理和对外提供服务,进行三种资源的并行调度,实现集计算、存储和网络资源的融合共享,降低运维与管理成本。

针对虚拟机服务支持自定义RAID、支持多租户、裸金属与VPC内的虚拟机互通等,有效提升系统性能及灵活性。针对容器高效部署和管理K8S集群,支持容器应用的自动化部署、容器镜像管理、服务目录管理、监控和弹性伸缩以及容器的持久化存储等功能。

单集群1000+节点大规模交付能力

目前,随着稳定性、易用性以及集成友好度的显著提升,OpenStack从测试环境到生产环境的转变速度越来越快,但大规模部署依然对OpenStack的管理及稳定运行带来挑战。浪潮InCloud OpenStack 5.5为了满足大规模数据中心交付能力,从两个维度对原生OpenStack产品进行了优化。一方面,采用多Region方式实现大集群的分而治之,所有的Region使用一套Keystone系统,解决因集群规模扩大而带来keystone系统瓶颈,从独立部署Keystone和Token认证两个维度进行优化;另一方面,为了增加单Region的集群规模,采用分离方案对数据库、消息通信机制进行优化,使得单集群规模大于1000+节点。

两地三中心容灾能力

InCloud OpenStack 两地三中心方案可对外提供同城150KM双中心双活,异地数据中心主备的容灾能力;方案采用浪潮自研的网络设备、集中式存储设备和云管理平台可以从数据、网络、业务层面稳定高效的保证客户业务连续性。该方案可以有效的帮助客户节约成本、提高业务高可靠、采用可视化一键式故障切换方案实现高效故障管理等能力。

目前,基于InCloud OpenStack 5.5的“两地三中心”云数据中心解决方案已成功交付,帮助客户构建起单集群超过1000节点、总规模达1400+节点的全球领先云基础设施。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元