IBM公司宣称,POWER 9加InfiniBand的组合才是AI最优解 原创

IBM公司在本月早些时候于纽约召开的AI纽约峰会上指出,其POWER 9方案在支持AI以实现“认知”工作能力方面优于通用或专用型X86商业现成(简称COTS)工具。

蓝色巨人最近公布了一项“演示”,据称其能够利用自有专有服务器配合低延迟/高带宽技术接入FlashSystem阵列——例如PCIe Gen 4、EDR与QDR InfiniBand以及NVMe over Fabrics,从而在性能表现上将COTS服务器及存储方案远远甩在身后。

当然,E8、Excelero、Pavilion以及Farmation Data Systems等初创企业都已经在推出NVMe over Fabrics访问型存储阵列,而Pure Storage也有意作出尝试——这一切都能够支持立足X86服务器的访问能力。

另外,IBM公司在展示中还使用了NVMe over Fabrics InfiniBand(简称NVMe-oF)。IBM公司并没有正式公布在AC922服务器或者FlashSystem 900阵列上支持NVMe-oF协议,但从目前的技术预览来看确有这种可能。

此次展示于今年12月5日到6日召开的AI纽约峰会上正式亮相。荐AC922采用PCIe第四代总线,速度是目前大多数服务器所使用的PCIe第三代总线的两倍。

IBM公司还向与会者们展示了基于POWER 9的AC922与五台FlashSystem 900阵列利用NVMe-oF实现对接的预览方案,并表示其能够有效降低数据访问延迟并提升传输带宽。

蓝色巨人Flashsystem产品组合与赋能战略经理Woody Hutsell在博文中指出,这台AC922服务器“能够将I/O数据吞吐能力提升至目前x86服务器内所使用的PCIe第三代总线的5.6倍。”

IBM公司表示,其将成为AI实现方案的理想之选——其能够摄取“海量数据,同时完成实时推理(对象检测)。”

Hutsell表示,FlashSsytem 900已经能够利用InfiniBand连接支持SRP(即SCSI over RDMA协议),并可将SCSI代码替换为NVMe代码以进一步降低延迟水平。

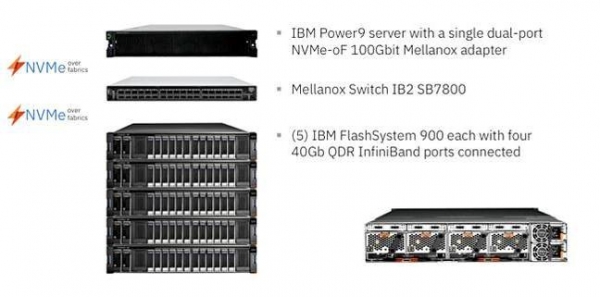

IBM公司在技术预览中使用的硬件配置。

在展示中,AC922服务器通过一个双閊NVMe-oF EDR 100Gbit Mellanox适配器接入一台Mellanox Switch-IB 2 7800交换机——后者又接入五台FlashSystem 900阵列,每台阵列配有4个每秒40 Gbit QDR InfiniBand端口。

这套配置可提供每秒41 GB总传输带宽,其中读取与写入能力最高可分别达到每秒23 GB与每秒18 GB。不过IBM方面并没有给出访问延迟数据。

IBM公司指出,POWER 9服务器加FlashSystem 900/NVMe-oF InfiniBand的组合能够为企业AI提供必需的低延迟与高传输带宽,意味着其在性能表现上要优于采用NVMe连接的其它一切x86服务器加闪存存储阵列方案。然而由于延迟数字尚未提供,这样的结论似乎很难令人信服。

评论意见:COTS配置能否与之匹敌?

Excelero公司为美国宇航局艾姆斯实验室打造的一套NVMe over Fabrics虚拟SAN系统可为4K IOPS提供平均199微秒的延迟水平,其最低延迟甚至仅为8微秒。这套系统的传输带宽在1 MB存储块大小的情况下可超过每秒140 GB。

该系统拥有128个计算节点,因此不能直接与IBM公司演示的单服务器进行比较。尽管如此,我们还是能够借此发现一些端倪,也许某家至强SP服务器供应商会采用PCIe第四代总线、NVMe over Fabrics外加每秒100 Gbit以太网连接全闪存阵列系统来观察所能达到的性能峰值。

好文章,需要你的鼓励

Plaud推出新款AI可穿戴设备,有望取代Otter.ai

Plaud在CES上推出两款AI笔记新品。NotePin S延续简约设计,可作为手环、项链或胸针使用,新增即时高亮按钮功能,售价179美元。同时发布的Plaud Desktop可录制在线会议,支持Zoom、Google Meet等平台,采用原生录制方式而非机器人参会。两款产品均可通过Plaud生态系统统一管理录音内容。

ETH苏黎世突破性WUSH技术:让AI大模型压缩实现接近零损失的革命性方案

瑞士ETH苏黎世联邦理工学院等机构联合开发的WUSH技术,首次从数学理论层面推导出AI大模型量化压缩的最优解。该技术能根据数据特征自适应调整压缩策略,相比传统方法减少60-70%的压缩损失,实现接近零损失的模型压缩,为大模型在普通设备上的高效部署开辟了新路径。

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

Instagram负责人亚当·莫塞里发布深度分析,指出我们正进入"无限合成内容"新时代,AI生成的照片和视频与真实内容越来越难以区分。他表示,人们需要从默认相信眼见转向保持怀疑态度,关注内容发布者身份和动机。莫塞里认为相机公司发展方向错误,过度追求完美效果。平台需要构建更好的创作工具,标记AI生成内容,验证真实内容,并提供发布者可信度信号。

机器人终于能读懂你的手势了!弗吉尼亚大学团队让机器人变身“人类动作翻译官“

弗吉尼亚大学团队创建了Refer360数据集,这是首个大规模记录真实环境中人机多模态交互的数据库,涵盖室内外场景,包含1400万交互样本。同时开发的MuRes智能模块能让机器人像人类一样理解语言、手势和眼神的组合信息,显著提升了现有AI模型的理解准确度,为未来智能机器人的广泛应用奠定了重要基础。

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

派拓网络安全官:智能体将成2026年最大内部威胁

Subtle发布搭载降噪模型的无线耳机

Xreal发布新款AR眼镜和电源集线器,革新工作娱乐体验

纳瓦尔Flow 2扫地机器人问世:配备AI识别技术能找到丢失物品

7个家庭AI技巧让智能聊天机器人相形见绌

Mac成为企业环境中最可持续设备的原因调查显示

首次独居必备的10款实用智能设备推荐

OpenAI重组团队开发语音AI硬件产品,2026年推出新模型

AI重塑工作格局:Mercor如何连接人才与智能体训练

科技巨头在股价飙升中套现160亿美元

联想问天 WR5215 G5服务器重磅发布:以能效和性能树立单路服务器新标准