Nvidia GPU云延伸至高性能计算应用领域 原创

有超过500个高性能计算应用都采用了GPU加速,Nvidia把目标对准了让这些应用更易于访问。

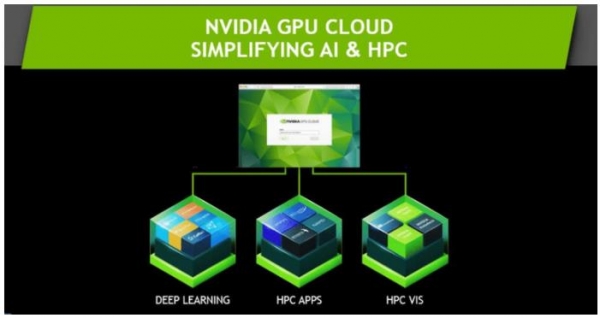

Nvidia开始涉足融合GPU加速的大量高性能计算(HPC)应用,本周一宣布在Nvidia GPU Cloud (NGC)容器注册表中增加了新的软件和工具,可以让科学家们快速部署科学计算应用和HPC可视化工具,

通常,希望使用这些应用的科学家们面临着耗费大量时间的安装问题以及资源密集的升级过程。现在,访问这些应用就像“从苹果应用商店下载一款应用一样简单”,Nvidia公司副总裁、加速计算总经理Ian Buck表示。

任何持有NGC帐户的人,都可以从NGC容器注册表获得HPC应用和HPC可视化容器。HPC容器可以运行在任何Nvidia Pascal和下一代Nvidia GPU加速的系统上。

Nvidia在丹佛举行的SuperComputing17大会上公布了这些工具,展示Nvidia正在越来越多地涉足高性能计算领域。

目前,已经有超过500个HPC应用是GPU加速的。来自分析师公司Interesect360 Research的报告,这其中包括TOP15以及70%的TOP50 HPC应用。从天文学到生命科学和医疗成像,GPU加速应用正在被用于广泛的科学领域,但是却难以安装。

Buck解释说:“这些应用是从很多不同的软件堆栈和库之上进行开发的,是由研究人员为他们自己开发的,而不一定是为大众发布开发的——这并不是他们的首要任务。”

Nvidia在深度学习和云社区领域解决了相同的问题,上个月,Nvidia发布了GPU Cloud for AI开发者工具,现在该工具已经成为容器注册表的一部分。

就NGC中的HPC应用来说,Nvidia是从小范围起步的,主要有5个应用:GAMESS、GROMACS、LAMMPS、NAMD和RELION,未来还有更多。

与此同时,在HPC可视化方面,Nvidia与ParaView合作推出了三个容器现在正处于测试阶段:ParaView with Nvidia IndeX是针对可视化大规模批量数据的;ParaView with Nvidia Optix是针对光线追踪的;Nvidia Holodeck则提供了交互式的实时可视化和高质量视觉效果。

本周一Nvidia还宣布基于Nvidia Volta架构的Tesla V100 GPU现在已经通过所有主流服务器厂商和主流云服务提供商提供,以交付人工智能和高性能计算,服务器厂商包括Dell EMC、HPE、华为、IBM和联想,云服务提供商包括阿里云、AWS、百度云、微软Azure、Oracle Cloud和腾讯云。

好文章,需要你的鼓励

DoorDash永久封禁使用AI伪造送餐照片的司机账户

DoorDash确认了一起司机使用AI生成图片伪造配送记录的事件。奥斯汀居民Byrne Hobart在社交媒体上曝光,称司机接单后立即标记为已配送,并提交了一张AI生成的配送照片。该司机疑似使用破解账户,通过DoorDash的历史配送照片功能获取了客户门前的图片。DoorDash发言人表示,经调查后已永久封禁该司机账户,并对客户进行了赔偿,强调公司对欺诈行为零容忍。

ETH苏黎世突破性WUSH技术:让AI大模型压缩实现接近零损失的革命性方案

瑞士ETH苏黎世联邦理工学院等机构联合开发的WUSH技术,首次从数学理论层面推导出AI大模型量化压缩的最优解。该技术能根据数据特征自适应调整压缩策略,相比传统方法减少60-70%的压缩损失,实现接近零损失的模型压缩,为大模型在普通设备上的高效部署开辟了新路径。

SwitchBot推出AI可穿戴设备:全天候语音记录助手

SwitchBot在CES展会上发布了AI MindClip,这是一款可穿戴麦克风设备,能够记录并转录用户说出的每一个声音。该产品配备AI功能,可以总结对话内容并提取有用数据,还能根据判断主动创建提醒事项。虽然类似产品在本届CES上不少见,但SwitchBot希望通过智能化功能在竞争中脱颖而出。目前产品的具体上市时间和价格尚未公布。

机器人终于能读懂你的手势了!弗吉尼亚大学团队让机器人变身“人类动作翻译官“

弗吉尼亚大学团队创建了Refer360数据集,这是首个大规模记录真实环境中人机多模态交互的数据库,涵盖室内外场景,包含1400万交互样本。同时开发的MuRes智能模块能让机器人像人类一样理解语言、手势和眼神的组合信息,显著提升了现有AI模型的理解准确度,为未来智能机器人的广泛应用奠定了重要基础。

iOS 18.2新增三种iPhone个性化定制功能

Backlot应用评测:影视发现神器让你轻松找到想看的内容

Plaud发布新款AI别针和桌面会议记录器

Twitter联创推出新社交应用Tangle,获2900万美元融资

DoorDash永久封禁使用AI伪造送餐照片的司机账户

SwitchBot推出AI可穿戴设备:全天候语音记录助手

思科或洽谈收购网络安全公司Axonius,但遭到否认

微软CEO纳德拉成AI推广者,呼吁超越低质内容

法律界巨头LexisNexis推动生成式AI进入法庭实践

Pebble Round 2智能手表回归,全新升级带来两周超长续航

OpenAI硬件设备将主打音频交互功能并搭载全新ChatGPT模型

Mac新机必装应用程序完整指南