NVIDIA宣布推出全球首台AI计算机,让自动驾驶出租车成为现实

北京—2017年10月10日——NVIDIA于今日发布了全球首台为完全自动驾驶出租车而设计的AI计算机。

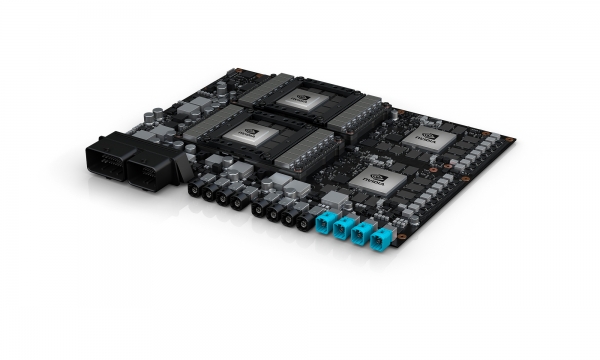

代号为Pegasus的全新系统扩展了NVIDIA DRIVE PX AI计算平台,可以处理L5无人驾驶汽车。NVIDIA DRIVE PX Pegasus的每秒操作超过320万亿次——比其前身NVIDIA DRIVE PX 2的性能超出10倍以上。

NVIDIA DRIVE PX Pegasus将有助于使无人驾驶这一新型汽车——没有方向盘、踏板或汽车视镜且内部如同客厅或办公室的完全自动驾驶汽车——成为可能。此类汽车将按需抵达,安全将乘客送达目的地,从而让每个人(包括老年人和残疾人)享受移动出行。

驾驶员可以利用节省下来的数百万小时在日常通勤中工作、娱乐、用餐或睡觉。这种永不疲劳、不受损害且不会分心的汽车将挽救无数生命——同时提高道路安全性、减少拥堵、释放被停车场占用的宝贵土地。

在利用NVIDIA DRIVE PX平台进行开发的225个合作伙伴中,有超过25家正利用NVIDIA CUDA GPU开发完全自动驾驶出租车。现在,此类车辆的后备箱类似于小型数据中心,装在配备服务器级NVIDIA GPU的计算机机架上,以运行深度学习、计算机视觉和并行计算算法。此类车辆的尺寸、功率需求和成本导致它们并不适合大批量生产。

自动驾驶出租车的计算需求巨大——通过高清的360度环绕摄像机和激光雷达感知周围环境、对车辆进行厘米级高精度定位、追踪周围车辆和人员、规划前往目的地的安全舒适路线。所有这些处理必须通过多级冗余来实现,以确保最高安全级别。无人驾驶汽车的计算需求强度比目前最先进的汽车高50到100倍。

NVIDIA创始人兼CEO黄仁勋表示:“创造完全自动驾驶汽车是全社会最重要的事业之一,也是最难完成的挑战之一。Pegasus的突破性AI计算性能和效率对于该行业实现此愿景至关重要。”

“无人驾驶汽车将提供新的乘车和拼车服务。它将创造出全新车型,犹如置于车轮上的办公室、客厅或酒店房间。出行者只需根据目的地和沿线的出行活动来订购想要的车型。社会的未来将因而被重塑。”

广泛的行业支持

几乎所有汽车制造商、运输服务公司和初创公司都在使用NVIDIA AI来开发L5车辆。

产品规格

NVIDIA DRIVE PX Pegasus由四个高性能AI处理器提供动力。它搭载了NVIDIA两款最新的Xavier系统级芯片处理器——包括基于NVIDIA Volta架构的嵌入式GPU——具备两个新一代独立GPU以及为加快深度学习和计算机视觉算法而创造的硬件。该系统将通过一个车牌大小的计算机,为完全自动驾驶汽车提供强大的计算能力,大幅降低能耗和成本。

Pegasus依据业界最高安全级别的ASIL D认证要求而设计,配备汽车输入/输出,包括CAN(控制器局域网)、Flexray、用于摄像机、雷达、激光雷达和超声波的16个专用高速传感器输入以及多个10Gbit以太网络连接器。其组合内存带宽为每秒超过1TB。

NVIDIA DRIVE PX平台

NVIDIA DRIVE PX平台从实现L2+/L3功能的单个移动处理器配置扩展为针对完全L5的多个移动处理器和独立GPU组合。这些配置在单一的开放软件架构上运行。这使得汽车制造商和tier1供应商能够从开发阶段转入实现各种自动驾驶解决方案的生产阶段——从高速公路上的AutoCruise到点到点行程的AutoChauffeur,再到针对完全无人驾驶汽车的Pegasus。

NVIDIA DRIVE PX是NVIDIA AI计算解决方案系统中的一员。在NVIDIA DGX-1 AI超级计算机的数据中心训练深层神经网络的数据科学家们可以在车辆内无缝运行NVIDIA DRIVE PX。统一的架构让同样的NVIDIA DRIVE软件算法、数据库和工具既能在数据中心内运行也能在车内实现推理。

通过这种“云到车”的方法,无人驾驶汽车能够在整个生命周期内进行网络更新,从而添加新的功能特征。

产品上市

Pegasus将于2018年下半年正式向NVIDIA汽车合作伙伴提供。NVIDIA DriveWorks软件和NVIDIA DRIVE PX 2配置现已经提供给从事自动驾驶汽车和算法的开发人员使用。

好文章,需要你的鼓励

北大学者带你拖拽3D物体,像玩拼图一样让虚拟世界动起来

北京大学团队开发的DragMesh系统通过简单拖拽操作实现3D物体的物理真实交互。该系统采用分工合作架构,结合语义理解、几何预测和动画生成三个模块,在保证运动精度的同时将计算开销降至现有方法的五分之一。系统支持实时交互,无需重新训练即可处理新物体,为虚拟现实和游戏开发提供了高效解决方案。

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——模型推理

AI硬件的竞争才刚刚开始,华硕Ascent GX10这样将专业级算力带入桌面级设备的尝试,或许正在改写个人AI开发的游戏规则。

达尔豪斯大学团队重磅研究:为什么AI社会模拟需要从“沙盒游戏“升级为“开放世界“?

达尔豪斯大学研究团队系统性批判了当前AI多智能体模拟的静态框架局限,提出以"动态场景演化、智能体-环境共同演化、生成式智能体架构"为核心的开放式模拟范式。该研究突破传统任务导向模式,强调AI智能体应具备自主探索、社会学习和环境重塑能力,为政策制定、教育创新和社会治理提供前所未有的模拟工具。

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——模型推理

上交联手阿里团队打造"AI记忆管家"ReMe,像人类一样从经验中学习

意大利航空携手ESA部署卫星通信技术提升飞行效率

苹果TV急需PoE支持以释放企业应用潜力

Google Translate为所有耳机带来实时语音翻译功能

生成式AI在心理健康咨询中的时间规律与人类使用习惯分析

回顾我们的2025年AI预测:准确性如何?

ServiceNow斥资10亿美元收购Veza 加速智能体权限管理

除英伟达和台积电外,其他AI公司都需要靠量补利

2025年数据中心芯片领域最热门发展趋势

自动化技术领导者揭示企业对AI认知的关键误区

五分之三企业对Wi-Fi投资信心增强