看浪潮M5如何应对“万物AI时代” 原创

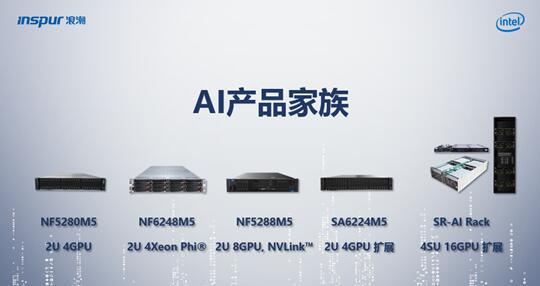

至顶网服务器频道 07月25日 新闻消息: 继年初人工智能首次写入政府工作报告后,国务院近日印发我国第一个人工智能(AI)规划--《新一代人工智能发展规划》,人工智能从一个技术热点上升为一项国家战略。而作为智慧计算领导者的浪潮,近期发布了M5新一代服务器,推出通用、融合架构、应用优化和关键业务4大系列35款产品,面向云计算、大数据、深度学习三大应用场景提供业界最丰富的产品阵列,为国家人工智能战略的发展提供了极致丰富的计算平台。

浪潮AI产品家族

浪潮AI产品家族

人工智能是浪潮智慧计算的重心

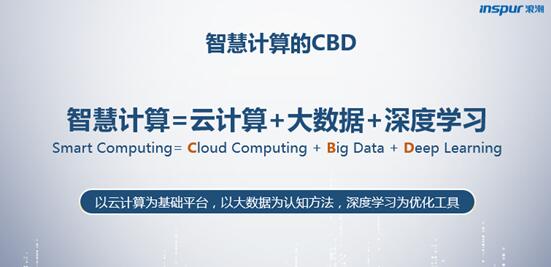

新一代M5反映出浪潮比较重要的变化是,服务器设计从均衡开始走向极致,主打"面向应用/场景的极致设计"概念,以此强有力的推进智慧计算业务的持续发展。智慧计算是浪潮目前最为看重的一项高成长性业务,它以云计算为基础平台,以大数据为认知方法,以深度学习作为优化工具,其核心是CBD(Cloud computing,Big data,Deep learning)。从组成要素来看,智慧计算与人工智能有着高度的重合,要知道目前引发人工智能热潮的三个重要因素即是超大规模的计算能力、爆炸式的数据增长、机器学习尤其是深度学习算法的出现。

浪潮智慧计算核心三要素

浪潮智慧计算核心三要素

可以说,将人工智能视为浪潮智慧计算业务的重心一点都不为过,而在这一领域的成功也将有助于浪潮实现跻身全球前三服务器厂商的目标。据埃森哲发布的研究报告,通过转变工作方式以及开拓新的价值和增长源,人工智能有潜力将2035年的中国经济总增加值提升7.111万亿美元,即从6.3%提速至7.9%。而对现代人工智能产生深远影响的科学家于尔根o施米德胡贝教授(Jürgen Schmidhuber)认为,人工智能将重构几乎所有的行业,包括金融、医疗保健、汽车、消费、娱乐等领域。毫无疑问,谁能赢得人工智能,谁就会赢得未来。

当我们行至一个"万物AI时代"的大门之前,该如何以计算推开这扇大门呢?浪潮M5新一代服务器的发布将带来耳目一新的AI计算体验,其构建了业界最全的AI的产品线,在部署密度、峰值性能、硬件解耦处于业界领先水平,相比上一代产品性能提升1.5倍。

应对AI计算"成长的烦恼"

M5系列所强调的极致、弹性两大特点更加匹配人工智能对计算的需求。我们常说人工智能对计算力的需求是无止境的,但在实际应用中并非总是如此。虽然人类社会的数据总量依然在爆炸式的增长,但能够用于深度学习训练的标注数据却无法快速增长,因此很多从事人工智能研究和应用的用户必须要考虑弹性的问题:在初期训练数据总量不大的时候,可以使用小规模的AI计算平台;随着训练数据规模的扩大,可以非常简单的扩容AI计算平台。

M5系列中被称为"AI超级计算机"的NF5288M5(AGX-2),具备良好AI计算扩展能力,是全球首款在2U空间内高速互联集成8颗最高性能GPU加速器的服务器,在单位计算密度上体现出非常明显的极致性,但它也可支持2-8卡的随需扩展,用户可根据模型训练的实际需要自由选择计算力。AGX-2具备良好的I/O扩展能力,GPU间互联带宽高达150GB/s,提供8块NVMe/SAS/SATA热插拔硬盘,可支持最多4块100Gbps的EDR InfiniBand接口卡的高速集群互联。

浪潮发布全球最高密度、最强性能的AI服务器NF5288M5

浪潮发布全球最高密度、最强性能的AI服务器NF5288M5

另一款可灵活扩展的新型AI加速计算产品GX4。实现了协处理器与CPU计算资源的解耦和重构,突破了常规AI计算设备的8卡扩展限制,实现了更高的单机计算性能。每个GX4可在2U空间内支持4块加速卡,而单台服务器最高可扩展链接4台GX4从而实现单机16卡的加速计算池。这种独立的加速计算模块设计极大提升了系统部署弹性,既能轻松实现2到16卡的高扩展性,也能通过改变服务器与扩展模块的链接方式实现快速灵活的拓扑转换,使计算架构与上层应用更匹配。

极致满足超大规模AI计算

而对于那些已经拥有超大规模数据和复杂神经网络的用户来说,AI计算平台的性能自然是越强越好。M5系列中的SR-AI整机柜就是一款面向更大规模数据集和深层神经网络的超大规模AI计算平台,能够高效支撑复杂的深度学习线下模型训练任务,适用于图像识别、语音识别、自然语言处理、搜索排序等AI应用。

SR-AI整机柜是全球首个采用PCIe Fabric互联架构设计的AI方案,其I/O BOX单节点即可实现支持16个GPU的超大扩展,并且可以通过PCI-E交换机实现4个BOX、64块GPU的级联,峰值处理能力达到为512TFlops。

同时,传统的AI计算设备集群需要通过高速网络实现数据的交互,这会带来us级以上的延迟,而SR-AI整机柜中GPU BOX间的互联是通过PCI-E交换机来实现,并借助GPUDirect RDMA技术可以大幅下降跨节点GPU间的通信延迟,能够实现ns级网络延时。

关注人工智能"上层建筑"

除了在底层架构层面关注人工智能的计算需求外,浪潮也从AI软件实现、框架优化和应用加速着手,解决AI计算中面对的各类复杂问题。目前,深度学习的模型训练往往流程较长、开发环境较复杂,涉及数据准备和处理、特征工程、建模、调参等多个步骤及多个框架和模型,每个框架依赖环境不同且有可能交叉使用。更大的"痛点"在于,深度学习模型在训练时往往耗时较长,短则数小时长则数天,以往在训练完成后才意识到模型存在问题,大大耗费了用户的精力和时间。

为此,浪潮除独立开发出AIStation深度学习系统管理平台、Teye应用特征分析系统以及Caffe-MPI深度学习并行计算框架之外,同时也在不断强化GPU、MIC和FPGA三种异构计算平台下的应用加速能力,协助用户完成AI应用的迁移、优化。

突破传统,创新研发

浪潮之所以能够打破服务器均衡设计的束缚,开发出一系列贴近应用场景的AI计算产品,很重要的原因得益于JDM(联合开发,Join Design Manufacture)模式。这是一种有别于OEM、ODM的新商业模式,即面向应用、融合产业链、与客户联合定制开发模式,能够创造出更显著的商业价值。同时,JDM模式也让浪潮建立了更难以逾越的竞争壁垒,因为这种能力很难复制,需要长时间的经验积累和不断的技术资源投入,以及对客户保持专注和对其需求的准确理解,并不是简单的靠投钱就能砸出来的。

目前,JDM模式主要集中在浪潮与互联网客户之间。以浪潮与百度合作为例,双方从单纯的产品合作向研发模式、生产模式的两端深入推进,使得硬件产品与软件算法从研发设计阶段就开始接触和磨合,这令研发出的AI计算产品更符合业务需求,最大化发挥AI计算力和创新能力。浪潮两度获得百度颁发的服务器领域唯一的"技术创新奖",可以说是JDM模式最好的诠释。

可以说,浪潮是隐身在众多超大互联网公司身后的产品"研发部门"。关键的是,这种联合创新背后,既代表了最前沿的技术需求,也意味着浪潮必须在快速交付以及定制化、个性化解决方案方面必须具备强大能力。

孕育无限可能的人工智能将是一场没有既定方向的长跑,对于AI解决方案在中国占有率达到60%的浪潮而言,只有保持强大的创新能力与准确的趋势预判,才能持续领跑。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元