全球大学生比赛百度人工智能交通预测 谁获胜了? 原创

人工智能解决交通拥堵

前不久,百度发布了《2017第一季度中国城市研究报告》显示了各城市的交通拥堵情况,同期,百度联合2017 ASC世界大学生超算竞赛,将人工智能交通预测列为赛题,这是当前热门的无人驾驶技术中最关键的应用软件之一,可以在考虑时空关系后对交通情况做出合理预测,帮助车辆选择最合适的路线,特别是在城市拥堵情况下的路线选择更有现实的意义。ASC17超算竞赛有全球230支队伍超1000名大学生参赛,最终选出20支队伍晋级总决赛。

5天,准确预测300+道路交通状况

ASC世界大学生超算竞赛是世界规模最大的超算竞赛,由浪潮和亚洲超算协会共同举办,今年的人工智能赛题来自百度深度学习研究院,预赛阶段给出某城市前50天实际采集的交通状况的训练数据集,要求参赛队预测出第51天的交通状况。在总决赛阶段,赛题难度进一步升级,要求各队伍在3000瓦功耗下采用组委会提供的浪潮超算服务器搭建系统集群,利用百度PaddlePaddle框架开发深度学习神经网络算法,预测多达300+道路在某规定时间的早高峰路况,而所有工作需在5天时间内完成。

某城市早晚高峰交通路网数据

这项看似不可能完成的任务,最终还是得以解决。北京航空航天大学、清华大学、乌拉尔联邦大学以及香港浸会大学表现出自身的独到理解,为解决交通拥堵提供了开阔思路。

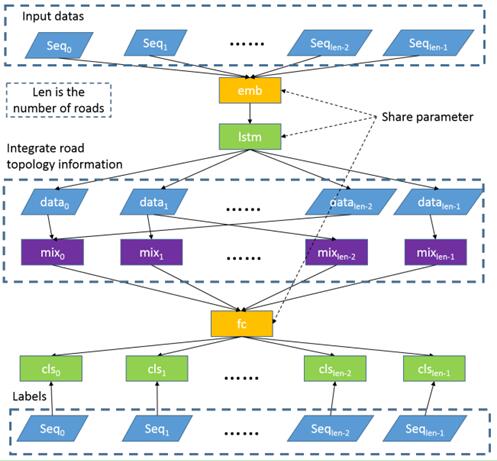

北航准确度最高

北京航空航天大学团队的计算平台为10台浪潮NF5280M4服务器的纯CPU集群,每台服务器搭载2颗Intel Xeon E5-2680v4,16G x8 DDR4 内存。其神经网络采用双层LSTM(Long Short Term Memory)结构,其模型配置如图2所示。该团队同时考虑了交通模型的时间特征与空间特征,第一层LSTM采用这两种特征作为输入信息,并将处理过后的输出信息与之前的空间信息一起传递给第二层LSTM,然后由第二层LSTM计算并得到预测结果。在数据的处理过程中,其团队充分利用提供的数据,对道路状况进行聚类处理,并利用HTCondor对训练及测试进行了加速处理。

图2. Model of information extraction based on LSTM

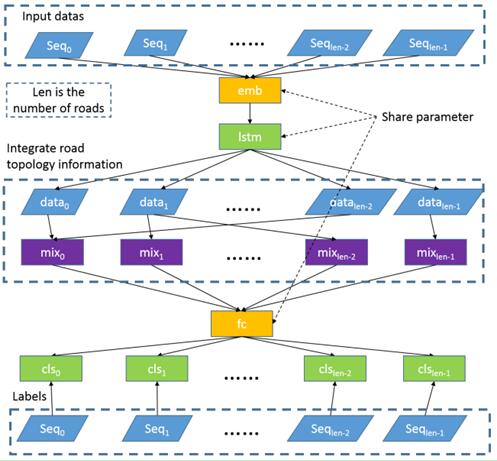

清华大学:历史统计平均值

清华大学团队采用了8台浪潮NF5280M4服务器集群,每台服务器额外搭载1个NVIDIA Tesla P100 GPU加速器。在模型训练及预测前,对数据进行了平衡处理,并对丢失值采取周围平均化方法填补。其训练结果以历史统计平均值方法为基准,对比了多种深度学习模型,并最终采用SAE(Stacked AutoEncoder)方法,取得了较为理想的预测精度。SAE模型的配置由图3给出。

图3. SAE (Stacked AutoEncoder)

乌拉尔联邦大学:独立空间特征提取

乌拉尔联邦大学团队采用了6台浪潮NF5280M4服务器集群,每台服务器额外搭载2个NVidia Tesla K20X GPU加速器。其对模型采取对每条道路单独训练神经网络的策略,且对每条道路的训练数据进行了独立的空间特征的提取,图4展示了路网交通状况的周期性。这种方法具有良好的可拓展性,当有新的道路添加时,只需对新道路进行模型训练即可,而其他道路无需重新训练。在神经网络模型的选择上,乌拉尔联邦大学团队也采用了LSTM网络。

香港浸会大学:时空关联分析

香港浸会大学团队的计算基于4台浪潮NF5280M4服务器,每台服务器额外搭载2个NVIDIA Tesla P100 GPU加速器。其团队对交通数据进行了空间信息提取以及交通流状况的详细动态分析,展示了道路交通状况在时间与空间上的关联性,并以历史平均数据为基准,对比了多种DNN模型与LSTM网络模型的优劣,最终采用3层的LSTM网络进行训练与预测。

人工智能被誉为未来人类十大科技之一,浪潮人工智能与高性能产品部总经理刘军表示,以深度学习为代表的人工智能技术需要与实际的生产、生活有更紧密的结合,才能更好的改变人的生活,而人工智能的发展依赖于算法、数据和计算技术的支撑。浪潮与亚洲超算协会举办ASC竞赛并设立人工智能赛题,就是希望更多年轻人可以更好的理解该技术,培养更多相关人才。

人工智能是浪潮智慧计算战略的重要支撑,浪潮致力打造多样化的硬件平台、管理调度与分析平台和深度学习框架的"平台组合",实现前端承接多源数据、后端支撑智能应用,为人工智能提供领先计算力。同时,浪潮还将进一步推动人工智能人才的培养,而ASC竞赛就是其中之一。

好文章,需要你的鼓励

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

西部数据闪存业务分拆后,SanDisk宣布将停用广受欢迎的WD Black和Blue品牌,推出全新的SanDisk Optimus系列NVMe产品线。WD Blue驱动器将更名为SanDisk Optimus,而高端WD Black驱动器将分别更名为Optimus GX和GX Pro。尽管品牌变更,底层硬件和供应链保持不变。然而受全球内存短缺影响,预计2026年第一季度客户端SSD价格可能上涨超过40%。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

福特汽车准备在车载系统中引入AI智能助手

福特汽车在2026年消费电子展上宣布将在车辆中引入AI助手技术。该AI助手最初将在福特和林肯智能手机应用中推出,从2027年开始成为新车型的原生功能。福特希望通过AI技术实现车辆个性化体验,提供基于位置、行为和车辆能力的智能服务。同时,福特将采用软件定义车辆架构,推出自研的高性能计算中心,提升信息娱乐、驾驶辅助等功能。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

智能体驱动全球创新浪潮,微软携手前沿伙伴迈进消费电子新未来

达索系统在CES 2026上展示AI驱动的医疗创新, 重塑精准、可预测与个性化医疗

Arm 发布 20 项技术预测:洞见 2026 年及未来发

美光推出全球首款面向客户端计算的 PCIe 5.0 QLC SSD

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

福特汽车准备在车载系统中引入AI智能助手

ChatGPT推出健康模式:结合医疗数据提供个性化建议

福特推出AI数字助理及新一代BlueCruise自动驾驶技术

联想Legion Pro可卷曲概念机展现移动大屏游戏新体验

印度和新加坡在智能体AI采用方面超越全球同行

华硕CES 2026新品:更小巧的ProArt GoPro笔记本和升级版Zenbook Duo

n8n警告CVSS满分漏洞影响自托管和云版本