面对数据中心高能耗,是“逃离”还是“自我革命”

在许多人看来,IT行业是一个严谨、缜密甚至有些死板的行业,但这并不代表IT圈就没有“脑洞大开”的创意,比如:把数据中心建在海底。

“脑洞大开”背后的功耗成本压力

2013年,微软启动了名为“纳提克”的海底数据中心研究计划。2015年,在加利福尼亚海岸约30英尺深的海底,通过将服务器部署在一个重达38000磅,长10英尺,宽7英尺的集装箱中,微软启动了长达105天的可行性验证,最终证实“非常成功”。

微软公司2015年8月进行水下数据中心实验

现实中,不光是海底,在南极和北极都已出现IDC的身影,例如美国国家科学基金会的南极数据中心和Facebook位于北极圈以南100公里的瑞典吕勒奥镇数据中心。从海底到极地,数据中心这么拼,到底为哪般?

其实这些看似“脑洞大开”的背后,是对数据中心高能耗导致运营成本激增的无奈。

数据中心能耗到底有多高?

目前的数据中心主要是以高密度,大型化为发展趋势。2016年,超过100个机架以上的数据中心的占比将超过60%。以3000个机架的数据中心为例,以每个机架平均功率如果按照3kW计算,其总负荷就将达到9000kW,全年的耗电量将达到78840000kWh,电费支出超过7800万元。加之配套设备,电费将接近1.5亿。

那么数据中心的电都被谁“吃”了?数据中心能耗主要来源于IT 设备、照明系统、空调系统、供配电系统等。其中IT设备的能耗约占总功耗的约45%,空调制冷系统占40%,供电系统10%,照明系统5%左右。可以看到IT设备和制冷系统是用电的大户,这也是为什么顶级互联网企业的数据中心会尝试进入极地,因为那里的温度足够低,可以通过外界的冷空气或者冷水进行散热,省去空调制冷的能耗,电力消耗将减少40%,对于拥有海量服务器的数据中心而言,这是何等大的成本节省。

“留守”数据中心的自我革命

虽然将数据中心向极地迁移是节省能耗的有效措施,但是对于绝大多数的企业数据中心而言,这是不可能的。首先,迁移数据中心需要巨大的财力支撑,新建数据中心厂房、建设配套设施、雇佣运维人员等成本可能已经远超数据中心本身的能耗成本。第二,新风系统或者海水冷却的设计和可靠性验证也不是一朝一夕可以完成。因此目前大部分数据中心仍然“留守”在城市的郊区或者稍靠北方的地域。

那么这些“留守”下来的数据中心就无法降低功耗成本了么?从数据中心能耗的占比来看,45%的用电量是由IT设备产生的,虽然作为核心单元,无法将IT设备的功耗将为0,但是尽最大可能将IT设备的能耗控制在可接受的范围内,也是降低数据中心能耗成本的重要手段,这是数据中心内部发起的“自我革命”。

先来看下中国x86服务器的类型占比,我们姑且将单路、双路的机架式和塔式服务器算作是计算存储均衡型或偏存储服务器,将刀片式和高密度服务器算作偏计算型服务器,那么根据IDC 2016Q3的数据显示,2016Q1-Q3中国市场计算存储均衡型或偏存储型服务器的出货量超过130万台,而偏计算型服务器仅为20万台。计算密集型服务器依靠高主频、高密度来实现价值,我们从中降低的能耗较少,而占据市场86%的偏存储型服务器则大有可为。

如何让90%的数据降低存储能耗

据HGST的研究表明,在数据中心里只有10%-15%的数据是被经常访问的,而其他全部是“冷数据”。对这些海量的“冷数据”,部分企业仍然采用2U机架式服务器进行存储,但效果往往是“大马拉小车”。一方面,2U最多支持12块3.5寸硬盘,均摊到每TB的成本较高;另一方面,“冷数据”的低访问率意味着其对CPU、内存、网络、PCIe扩展等性能要求不高。如果将其和温数据,甚至是热数据挤在一个“房间”,那么带来的后果只能是机房投入、功耗及运维成本的居高不下,难以做到资源的最优化配置。

因此,对互联网企业而言,尤其是随着大数据时代的来临,如何实现数据的分级存储,为占据90%数据总量的“冷数据”找到最合适的“家”,是困扰企业已久的难题。而那些具有市场敏感性的服务器厂商,也适时推出了化解“冷存储”困境的产品,比如浪潮SA5224L4。

SA5224L4——互联网“冷存储”专属利器

浪潮SA5224L4

密度提升60%,功耗降低42%

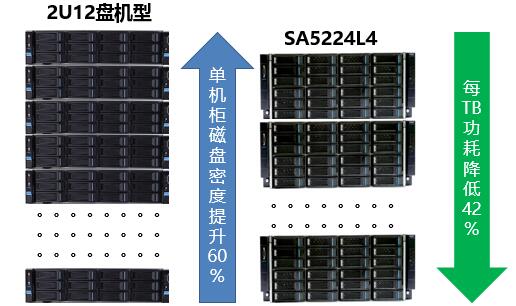

对于“冷数据”的存储而言,高容量、低功耗无疑是其两个关键诉求。在容量方面,SA5224L4可支持36块3.5寸硬盘,相比2U12盘机型,单节点磁盘密度提升了50%,单机柜磁盘密度提升60%,使得单位空间内磁盘部署密度得到提升,大幅降低了服务器的部署规模。同时,SA5224L4配备2个后置2.5寸硬盘做OS或缓存,释放了磁盘的存储空间,让存储性能发挥到极致。

在功耗方面,SA5224L4在兼顾“冷存储”性能需要的同时,整机功耗较传统“冷存储”方案大幅下降,每TB功耗降低幅度可达42%。

E3单路,性能够用而成本更优

作为国内服务器行业的领导厂商,浪潮推出的SA5224L4无疑是专为互联网企业打造的一把“冷存储”利器。首先,在计算性能与“冷存储”需求的平衡上,SA5224L4的设计者显得颇具用心。该产品采用单路设计,并且在CPU的最初选择上没有像其他厂商那样使用性能较优的Intel E5-2600V3系列,而是采用E3-1200V3系列CPU,搭配4条DDR3内存,在具备更低功耗和成本的同时,实现了计算性能与“冷存储”需求的完美匹配。此外,网络IO方面,在四个板载千兆网口设计的基础上,可通过外插满足万兆的扩展要求,保证了业务运行不会受网络带宽的影响。

前金山云CTO杨钢曾经指出:“作为存储服务提供商,我们的职责是把用户的数据存好,并且在用户想要使用的时候快速拿出来。但同时,我们也要尽可能地降低存储成本。”可以说,用作“冷存储”的服务器需要对性能、功耗、成本、安全等每一项指标都做到精打细算,最大实现各项指标的平衡,因此其开发难度并不低,这也是为什么业界大多数4U36盘位机型定位在温热数据存储的原因。而正是源于浪潮SA5224L4对“冷存储”的精准定位,使其成为奇虎、网易、金山、七牛等诸多互联网客户“冷存储”的理想选择。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元